Traffico sito: cos’è, come si monitora e come individuare i cali

Non è soltanto un insieme di numeri isolati né solo una questione di quantità: il traffico di un sito è un indicatore essenziale attraverso cui capire cosa funziona e cosa invece non va nel nostro progetto digitale, perché ci permette di capire il gradimento di Google, analizzare le interazioni degli utenti, investigare da dove provengono, quali pagine preferiscono e quali comportamenti seguono. Ma non basta raccogliere i dati: per mantenere la rotta giusta e garantire una crescita costante serve anche comprendere le fonti del traffico – organico, a pagamento, diretto o referral – e analizzare in che modo influenzano le performance generali del sito. Bisogna poi essere proattivi, perché capiterà sicuramente il giorno (brutto) in cui ci ritroviamo a osservare una diminuzione del traffico, e allora entra in gioco la necessità di sapere dove guardare per analizzare le cause di questo calo, consapevoli che ogni piccola variazione ha il potenziale di destabilizzare i flussi di utenti verso il nostro sito. Insomma, è il momento di concentrarci sull’analisi del traffico di un sito, per comprenderne meglio il significato e per esplorare quali strumenti possiamo utilizzare per tracciarlo e diagnosticarne eventuali anomalie.

Che cos’è il traffico di un sito web

Il traffico di un sito web è il numero complessivo di visitatori che accedono al sito, indipendentemente dal canale di provenienza.

Ogni visita può essere originata da diverse fonti come i motori di ricerca, inserzioni pubblicitarie, link da altri siti o accessi diretti. Monitorare il traffico consente di valutare la visibilità e le performance del sito, fornendo informazioni utili per migliorare la sua efficacia e ottimizzare le strategie di acquisizione degli utenti.

E quindi, il traffico web rappresenta il flusso di visitatori che atterrano su un sito attraverso diversi canali e fonti; a livello pratico, si traduce nel numero complessivo di accessi che una pagina riceve in un determinato lasso di tempo, ma il termine racchiude una dinamica ben più complessa, perché non si tratta solo di contare le visite, ma di capire da dove provengono e in che modo gli utenti arrivano al nostro contenuto.

Da un lato, il traffico è uno degli indicatori principali della salute di un sito, utile per misurare l’efficacia delle strategie adottate, siano esse SEO, SEM, campagne pubblicitarie o azioni di marketing. Dall’altro, sapere come i visitatori raggiungono il sito ci permette di determinare se stiamo puntando correttamente la nostra attenzione sulle giuste fonti di traffico o se è necessario un aggiustamento nelle strategie.

Quali sono le principali fonti di traffico web

In generale, possiamo ricondurre le fonti del traffico web a quattro grandi categorie: traffico organico, traffico a pagamento (o paid), traffico diretto e traffico referral. Comprendere queste diverse tipologie ci permette di avere una visione più definita su quanto un sito sia realmente performante e quali siano le aree su cui concentrare i nostri interventi.

Ogni canale ha il suo ruolo e le sue peculiarità, e inserirli in strategie complementari contribuisce a potenziare la visibilità e il successo del sito, nel breve e nel lungo termine.

In linea di massima, il traffico organico è probabilmente la fonte più ambita, soprattutto per chi lavora nell’ambito della SEO: oltre a essere generato gratuitamente (almeno dal punto di vista economico diretto), può infatti garantire risultati sostenibili e stabili nel tempo, a patto che vengano messe in atto strategie SEO efficaci e aggiornate. Il traffico a pagamento garantisce invece risultati istantanei, ma con un livello di temporaneità soggetto al budget, mentre il traffico referral e diretto ci parlano del legame tra i nostri contenuti, il nostro network e l’importanza del brand.

Indipendentemente dalla fonte, l’analisi dettagliata del traffico di un sito ci fornisce un quadro del suo stato di salute complessivo: se osserviamo un continuo afflusso di dati dai vari canali, significa che il sito ha una solida base di visibilità, mentre eventuali cali in specifici segmenti devono farci riflettere su quali strategie siano meno efficaci e potrebbero aver bisogno di una revisione. La misurazione di ciascun tipo di traffico, quindi, rappresenta non solo una metrica quantitativa, ma un indicatore vitale per indirizzare al meglio gli sforzi di miglioramento e ottimizzazione.

Quando analizziamo il traffico web, distinguere e comprendere le diverse fonti da cui provengono i visitatori è quindi uno degli aspetti prioritari, anche per avere una visione chiara su quale tipologia sia più adatta alle nostre strategie. Per il monitoraggio del traffico organico possiamo usare strumenti analitici – Google Analytics o Google Search Console, tra i primi – oppure SEO tools basati su calcoli statistici e previsionali, come SEOZoom.

- Traffico organico

Il traffico organico è la linfa vitale di tante strategie digitali. Comprende tutti i visitatori che atterrano su un sito web dai motori di ricerca – come Google, Bing o Yahoo – senza l’ausilio di campagne pubblicitarie a pagamento e quindi senza spendere budget direttamente in advertisiting: è un segnale che indica come le nostre pagine siano ben posizionate nei risultati di ricerca, attirando clic in modo naturale grazie alla qualità del ranking organico, senza costi pubblicitari aggiuntivi. Il visitatore, quindi, fa una ricerca specifica su Google, trova la nostra pagina tra i risultati, clicca e atterra sul sito: ecco una visita proveniente da traffico organico.

Un traffico organico in crescita implica che il nostro sito, nel corso del tempo, sia stato in grado di rispondere efficacemente alle query di ricerca degli utenti, guadagnando visibilità e credibilità agli occhi di Google.

Il vantaggio principale di questa fonte è la sostenibilità nel lungo termine: la SEO richiede tempi iniziali lunghi per ottenere risultati, ma una volta consolidato il brand consente poi di generare visite continuative e costanti, senza la necessità di ulteriori investimenti economici diretti, a differenza delle campagne a pagamento. Se da un lato questo impatta sugli investimenti per un periodo iniziale per creare e raggiungere queste posizioni, dall’altro i benefici possono proseguire nel tempo, se il sito riesce a mantenere e migliorare la propria presenza nella SERP.

- Traffico a pagamento (Paid)

Traffico a pagamento è quello generato attraverso inserzioni pubblicitarie a pagamento, come le campagne realizzate tramite Google Ads o altre piattaforme di advertising, anche via social media. Questi visitatori cliccano su link sponsorizzati in seguito a un investimento economico finalizzato a promuovere pagine specifiche. In questo caso, quindi, per far visualizzare i contenuti agli utenti paghiamo una certa somma per ogni clic che riceviamo. È una fonte di traffico molto importante per chi desidera risultati immediati o per chi deve lanciare un sito nuovo, perché crea visibilità istantanea e permette di raggiungere rapidamente un’audience specifica. Tuttavia, il traffico a pagamento comporta costi continui e spesso elevati: finché manteniamo attive le campagne, continueremo a ricevere traffico, ma una volta terminati i fondi, il flusso di nuovi visitatori si interromperà quasi immediatamente. A differenza dell’organico, questo canale non è in grado di sostenersi autonomamente sul lungo periodo senza continui investimenti. Affidarsi solo al traffico a pagamento può dunque risultare costoso nel lungo periodo, senza muovere lo stesso livello di sostenibilità e continuità che invece garantiscono le strategie SEO e il traffico organico. Le visite ottenute saranno preziose, ma legate a doppio filo al budget disponibile.

- Traffico diretto

Il traffico diretto raccoglie tutti quei visitatori che accedono al sito digitando direttamente l’URL nel proprio browser, senza passare attraverso altre fonti esterne come i motori di ricerca o i social. Questo tipo di traffico è in stretta correlazione con la brand awareness e con la riconoscibilità del sito o della singola pagina: se un utente ricorda il nome del sito e lo digita direttamente senza passare per un motore di ricerca, vuol dire che ha familiarità e fiducia verso il nostro marchio, il nostro prodotto o i servizi offerti. Il traffico diretto deriva spesso da utenti già fidelizzati o da azioni di marketing offline, come l’inserimento diretto dell’URL su materiali promozionali o la pubblicità classica. Pur rappresentando una fonte attendibile di utenti con un’esperienza pregressa del sito, questo tipo di traffico non offre le stesse opportunità di crescita rispetto al traffico organico, poiché il suo potenziale di incremento è limitato dalla notorietà del brand. Inoltre, può includere anche clic da segnalibri o e-mail che non sono monitorate correttamente con codici di tracciamento.

- Traffico referral

Il traffico referral proviene da visitatori che arrivano sul nostro sito cliccando su un link trovato su un altro dominio; è quindi generato da link presenti su altri siti che puntano a contenuti specifici nel nostro dominio. Questo tipo di visite è indice di quanto il nostro sito sia citato e collegato in giro per il web, spesso correlato a campagne di link building o contenuti di valore che le altre fonti trovano utile condividere con i propri utenti. I link referral provengono da siti partner, blog o altre piattaforme esterne che citano o rimandano ai nostri contenuti: catturare traffico riconducibile a tali fonti non solo migliora la visibilità del sito, ma spesso apporta un incremento in termini di credibilità e trust nel settore, agevolando anche il ranking nei motori di ricerca.

Verificare in che modo questo traffico si sviluppa può fornire informazioni chiave sull’efficacia delle nostre relazioni online e sul posizionamento del sito nei network di riferimento.

Perché è importante monitorare il traffico web

Il traffico web ci racconta molto sulla performance del nostro sito e ci permette di capire se stiamo intercettando e soddisfacendo le esigenze del nostro pubblico, e un corretto monitoraggio del flusso di utenti ci permette di sapere come accedono alle nostre pagine, da dove provengono e cosa fanno una volta atterrati sul sito.

Questo tipo di analisi non serve solo a misurare quante persone visitano il sito, ma soprattutto a comprendere l’impatto delle nostre strategie, dal lato SEO così come dal lato marketing, per valutare in modo preciso e il più possibile oggettivo dei KPI quali l’engagement, l’interesse e le performance complessive delle pagine del nostro progetto online.

Uno degli aspetti più interessanti del monitoraggio del traffico è che permette di scoprire quali fonti stanno contribuendo con il maggior numero di visitatori e in che modo ognuna di esse incide sulle nostre metriche principali. Quando vediamo crescere il traffico organico, ad esempio, possiamo dedurre che le nostre strategie SEO stanno funzionando e che i contenuti sono ben ottimizzati per rispondere adeguatamente alle query degli utenti sui motori di ricerca; all’inverso, una flessione nel traffico organico potrebbe avvertirci della necessità di rivedere le nostre parole chiave o verificare variazioni nell’algoritmo di Google, che possono impattare la visibilità complessiva.

Non meno importante è tenere conto delle altre fonti di traffico, come quello a pagamento che, per sua natura, richiede una gestione continua e un monitoraggio accurato: per valutare l’efficacia di una campagna marketing dobbiamo sapere esattamente quante visite produce, ma anche quante di queste visite si traducono in conversioni, siano esse vendite, lead o altre azioni desiderate. In questo modo, possiamo ottimizzare il budget investito, evitando sprechi e garantendo che le risorse siano impiegate in modo efficiente.

Un monitoraggio costante del traffico ci aiuta anche a perfezionare l’esperienza utente: controllare metriche come il tasso di rimbalzo o il tempo medio trascorso sul sito ci consente di capire se stiamo offrendo contenuti che coinvolgono realmente gli utenti o se, al contrario, esistono pagine che li portano ad abbandonare il sito troppo in fretta. Quando notiamo che gli utenti trascorrono più tempo su specifici contenuti e interagiscono maggiormente con essi, possiamo adattare la nostra strategia e replicare questo successo su altre sezioni del sito.

Cali di traffico del sito: cosa fare quando perdiamo visitatori

Al di là delle accortezze messe in atto, nella nostra esperienza di gestione di un sito web potremmo ritrovarci prima o poi a fronteggiare una riduzione imprevista del traffico.

Una mattina apriamo Search Console o Analytics e scopriamo che il traffico del sito è calato, e che in particolare sta diminuendo il traffico da Ricerca Google.

E per quanto ci impegniamo, ragioniamo, interveniamo e ci arrovelliamo, il nostro sito continua a perdere gradualmente traffico organico.

Identificare le cause del problema è il primo passo per invertire questa tendenza negativa e riportare il flusso di visitatori alla normalità: un calo di traffico organico può dipendere da diverse ragioni, alcune delle quali legate a fattori interni al sito (problemi tecnici o azioni manuali), altre invece connesse a cambiamenti più ampi, come quelli algoritmici da parte di Google o modifiche nelle tendenze di ricerca degli utenti.

Siti in calo: le cause frequenti e i consigli di Google

Ma da cosa dipende questa improvvisa e lenta discesa e come possiamo comprendere i motivi dietro al calo di traffico?

In nostro supporto arriva Google, che presenta una serie di consigli per analizzare i motivi che possono determinare la perdita di traffico organico, con 5 cause che sono considerate le più frequenti, e una guida (anche grafica) che mostra visivamente gli effetti di tali cali e ci aiuta ad analizzare le fluttuazioni negative del traffico organico per provare a rispondere e risollevare il nostro sito.

Il problema è stato trattato anche in una apposita pagina della documentazione di Google,in cui Daniel Waisberg spiega analiticamente come appaiono e cosa significano le fluttuazioni negative di traffico che si possono riscontrare nei volumi di un sito.

In estrema sintesi, secondo il Search Advocate un calo del traffico organico di ricerca “può verificarsi per diversi motivi e la maggior parte di essi può essere invertita”, anche se “potrebbe non essere semplice capire cosa è successo esattamente al tuo sito”.

Proprio per aiutarci a comprendere cosa sta influenzando il traffico del nostro sito, il Googler ha abbozzato alcuni esempi di cadute e del modo in cui possono potenzialmente influenzare il nostro traffico.

La forma dei grafici per un sito che perde traffico

Per la prima volta, quindi, Google mostra il vero aspetto dei vari tipi di cali di traffico organico attraverso degli screenshot dei rapporti sul rendimento della Google Search Console, aggiungendo una serie di consigli per aiutarci ad affrontare tali situazioni. È interessante notare la differenza visiva che sussiste tra i vari grafici, segno che ogni tipo di problematica genera oscillazioni caratteristiche e distintive che possiamo riconoscere a colpo d’occhio.

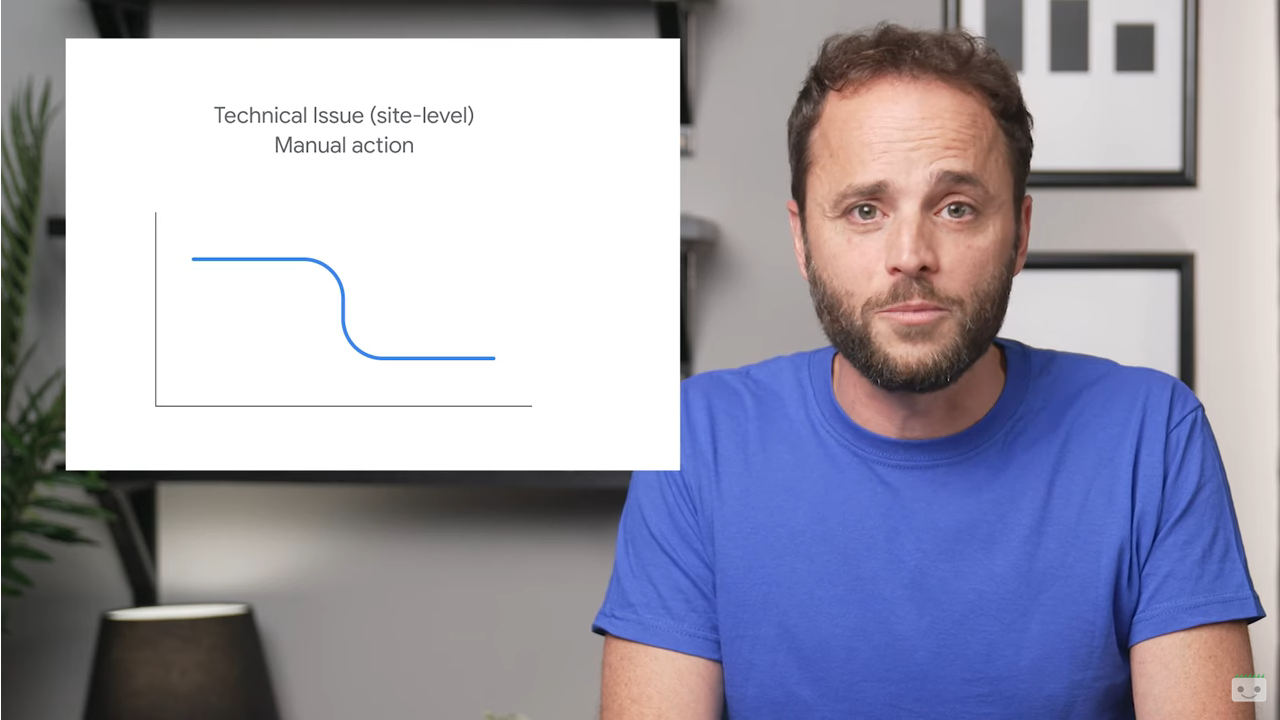

In particolare, i problemi tecnici a livello di sito e le azioni manuali provocano generalmente un enorme e improvviso calo del traffico organico (in alto a sinistra nell’immagine).

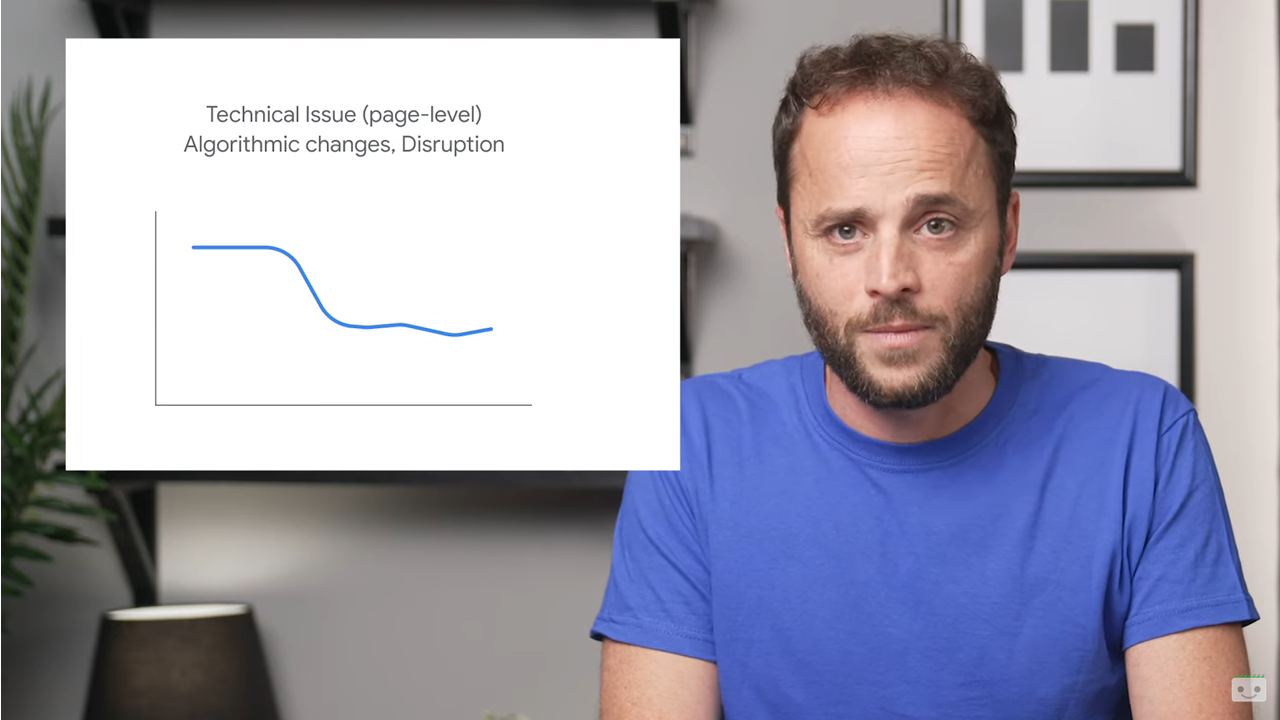

Problemi tecnici a livello di pagina, una modifica dell’algoritmo come un core update o un cambiamento dell’intento di ricerca provocano un calo più lento del traffico, che tende a stabilizzarsi nel tempo.

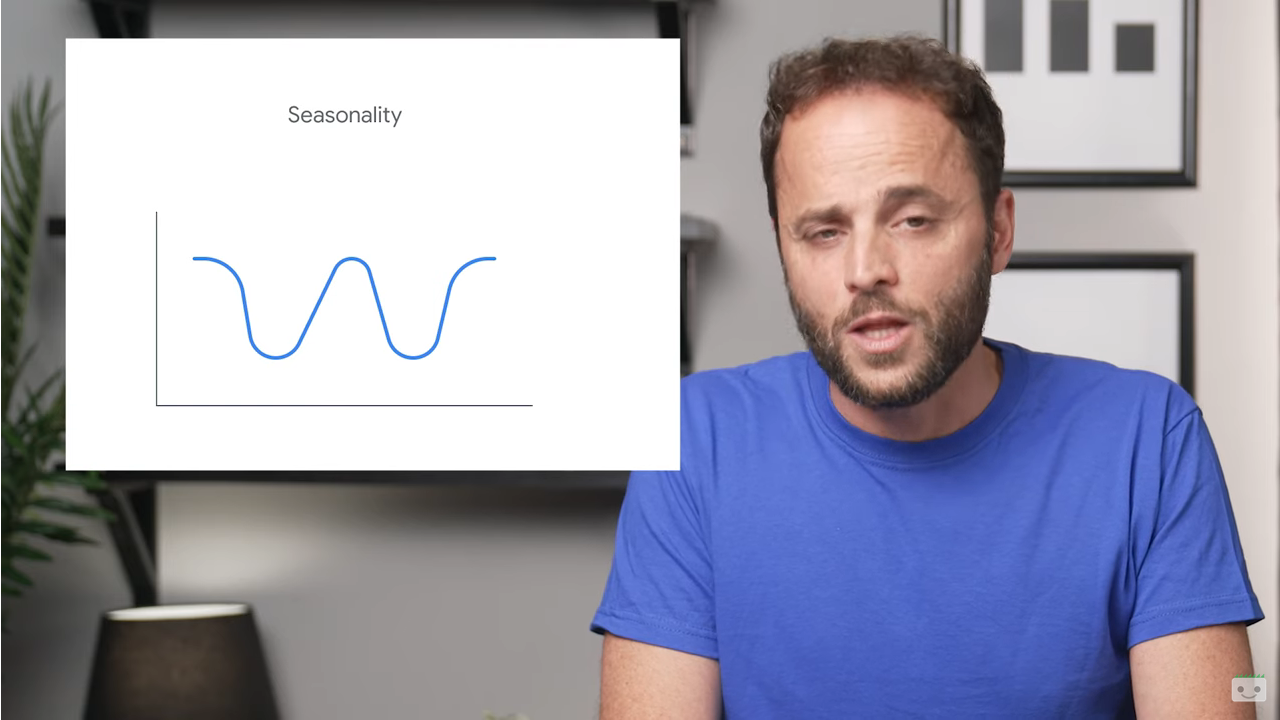

Ci sono poi i cambiamenti legati alla stagionalità, oscillazioni tendenziali e cicliche che provocano dei grafici con curve caratterizzate da alti e bassi.

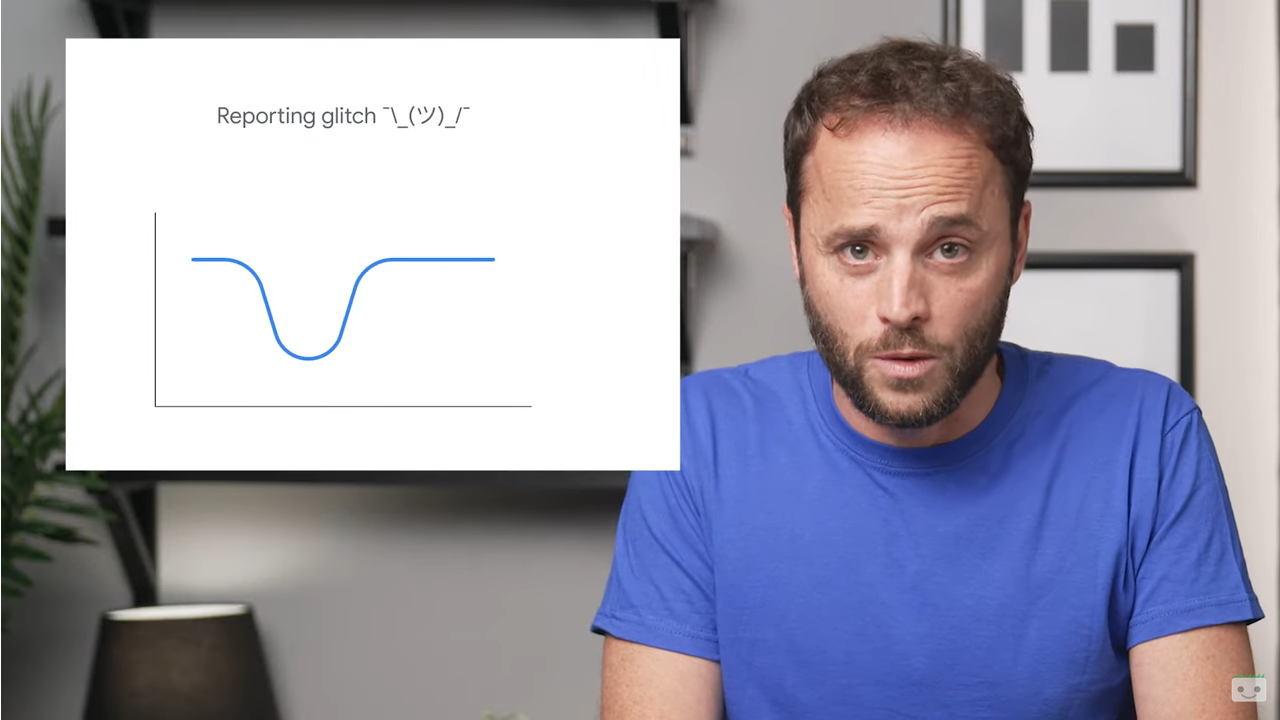

Infine, l’ultimo grafico mostra l’oscillazione di un sito segnalato per problemi tecnici in Search Console e poi tornato alla normalità dopo la correzione.

Molto banalmente, riconoscere esattamente qual è la causa del crollo del traffico organico è un primo passo verso la risoluzione del problema.

Le sette cause di perdite di traffico SEO

Secondo Waisberg, esistono otto principali cause di calo del traffico di ricerca:

- Problemi tecnici. Presenza di errori che possono impedire a Google di eseguire la scansione, l’indicizzazione o la pubblicazione delle nostre pagine per gli utenti, come ad esempio mancata disponibilità del server, errori nel recupero di file robots.txt, pagine in 404 e altro. Tali problemi possono riguardare l’intero sito (ad esempio, se il sito risulta inattivo) o l’intera pagina (come per un tag noindex messo male, che causa una mancata scansione della pagina da parte di Google e genera un calo più lento del traffico). Per individuare il problema, Google suggerisce di utilizzare il rapporto sulle statistiche di scansione e il rapporto sull’indicizzazione delle pagine per scoprire se è stato rilevato un picco corrispondente nei problemi rilevati.

- Problemi di sicurezza. Quando un sito è interessato da una minaccia alla sicurezza, Google potrebbe avvisare gli utenti prima che raggiungano le sue pagine con avvisi o pagine interstitial, che possono ridurre il traffico da ricerca. Per scoprire scoprire se Google ha rilevato una minaccia alla sicurezza sul sito web possiamo usare il rapporto Problemi di sicurezza.

- Problemi di spam . La mancata conformità del sito alle linee guida di Google o la rilevazione da parte di Google di pratiche che violano le norme relative allo spam – tramite sistemi automatici o una revisione umana – potrebbe comportare un’azione manuale, e quindi una penalizzazione o addirittura la rimozione di alcune delle pagine o dell’intero dominio dai risultati della Ricerca Google. Per capire se questo è il motivo per cui il nostro sito perde traffico organico, possiamo controllare le norme sullo spam della Ricerca Google e il rapporto Azioni manuali su Search Console, ricordando che gli algoritmi di Google potrebbero prendere in considerazione violazioni delle norme anche senza un’azione manuale.

- Aggiornamenti algoritmici. Google “migliora costantemente il modo in cui valuta i contenuti e aggiorna di conseguenza i propri algoritmi di pubblicazione e ranking nei risultati di ricerca”, dice Waisberg, e core update e altri aggiornamenti minori possono modificare il rendimento di alcune pagine nei risultati della Ricerca Google. Di base, se sospettiamo che un calo del traffico sia dovuto a un aggiornamento algoritmico, è importante capire che potrebbe non esserci nulla di sbagliato nei nostri contenuti. Le posizioni in SERP non sono statiche o fisse, e anzi i risultati di ricerca di Google sono di natura dinamica perché il web stesso cambia continuamente con contenuti nuovi e aggiornati. Questa variazione costante può causare sia miglioramenti che cali del traffico organico nella Ricerca. Per stabilire se è il caso di apportare una modifica al nostro sito, la guida suggerisce di analizzare le pagine principali del sito in Search Console e valutarne il calo di ranking, e in particolare:

-

- Un piccolo calo della posizione, ad esempio diminuzione dalla 2 alla 4: non intervenire in modo radicale. Un piccolo calo di posizione si verifica quando c’è una leggera variazione di posizione nei primi risultati (ad esempio, un calo dalla posizione 2 alla 4 per una query di ricerca). In Search Console, potremmo vedere un calo significativo del traffico senza un cambiamento significativo nelle impressioni. Piccole fluttuazioni possono verificarsi in qualsiasi momento (potremmo anche risalire di posizione, il tutto senza fare nulla), e Google consiglia di evitare di apportare modifiche radicali se la pagina conserva un buon rendimento.

- Calo significativo di posizione, ad esempio diminuzione dalla 4 alla 29: valutare gli interventi per invertire la rotta. Un calo significativo di posizione si verifica quando notiamo un calo importante dei primi risultati per un’ampia gamma di termini (ad esempio, se passiamo dai primi 10 risultati alla posizione 29). In casi come questo, Google invita a valutare autonomamente l’intero sito web nel suo complesso (e non solo le singole pagine) per assicurarci che i contenuti siano utili, affidabili e pensati per le persone. Se abbiamo apportato modifiche al sito, potrebbe essere necessario un po’ di tempo prima che abbiano effetto (alcuni giorni o anche parecchi mesi). Ad esempio, potrebbero volerci mesi prima che i sistemi stabiliscano che un sito sta attualmente producendo contenuti utili a lungo termine. In generale, la guida consiglia di attendere alcune settimane per analizzare di nuovo il sito in Search Console e scoprire se le azioni hanno avuto un effetto positivo sulla posizione del ranking. Ad ogni modo, dobbiamo ricordare che Google che non garantisce che le modifiche apportate al sito web comportino un impatto notevole sui risultati di ricerca. Se ci sono contenuti più meritevoli, questi continueranno a ottenere un buon ranking da parte dei sistemi del motore di ricerca.

- Spostamenti e migrazioni di siti. C’è poi un altro caso specifico in cui il sito può perdere traffico, quando cioè è stata appena completata una migrazione: se modifichiamo gli URL delle pagine esistenti sul sito, chiarisce Waisberg, potremmo infatti riscontrare fluttuazioni nel ranking mentre Google esegue nuovamente la scansione e l’indicizzazione del sito. Come regola generale, per lo spostamento di un sito web di medie dimensioni possono servire anche alcune settimane prima che Google si accorga del cambiamento, mentre i siti più grandi possono richiedere anche più tempo.

- Stagionalità e modifiche all’interesse di ricerca. A volte, i cambiamenti nel comportamento degli utenti “modificano la domanda per determinate query, a causa di una nuova tendenza o della stagionalità nell’arco dell’anno”. Pertanto, il traffico di un sito può diminuire semplicemente a causa di influenze esterne, per i cambiamenti nel search intent individuato (e premiato) da Google. Per individuare le query che hanno registrato un calo di clic e impressioni possiamo utilizzare il rapporto sul rendimento, applicando un filtro per includere solo una query alla volta (scegliendo le query che ricevono più traffico, spiega la guida), e poi controllare le ricerche su Google Trends per capire se il calo ha riguardato solo il nostro sito o tutto il web.

Come diagnosticare un calo del traffico di Ricerca Google

Secondo Waisberg, il modo più efficiente per capire cosa è successo al traffico di un sito è aprire il suo performance report di Search Console e guardare il grafico principale, che contiene molte informazioni utili.

Un grafico “vale più di mille parole” e riassume molte informazioni, aggiunge l’esperto, e inoltre l’analisi della forma della linea ci dirà già molto sulle potenziali cause del movimento.

Se sono diminuiti sia le impressioni che i clic, iniziamo dal confrontare il nostro grafico con quelli precedenti per individuare subito in quale casistica ci stiamo ritrovando. Se invece le impressioni rimangono le stesse, ma i clic diminuiscono, potrebbe esserci un problema di “interesse” da parte degli utenti: ovvero, le nostre pagine potrebbero non avere i miglior titolo e snippet possibili, e quindi gli utenti non capiscono il contenuto della pagina, o forse altri siti hanno ottenuto un risultato avanzato più interessante e accattivante, che conquista i clic.

Per eseguire questa analisi, l’articolo suggerisce 5 indicazioni:

-

- Modificare l’intervallo di date per includere gli ultimi 16 mesi, per analizzare il calo del traffico nel contesto ed escludere che si tratti di un calo stagionale che si verifica ogni anno in occasione di festività vacanza o di una tendenza.

Il seguente grafico, tratto come gli altri in pagina dalla guida di Google, mostra un grafico del rendimento con stagionalità annuale (16 mesi di dati): salta agli occhi come il calo recente si è verificato esattamente come l’anno precedente.

- Confrontare il periodo di drop con un periodo simile, confrontando lo stesso numero di giorni e preferibilmente gli stessi giorni della settimana, per rivedere esattamente cosa è cambiato – ad esempio, possiamo confrontare gli ultimi 3 mesi con periodo precedente o gli ultimi 3 mesi su base annua. Facendo clic su tutte le schede possiamo scoprire se la modifica è avvenuta solo per query, URL, paesi, dispositivi o aspetti di ricerca specifici.

Nell’immagine sotto vediamo un grafico del rendimento di confronto su tre mesi: salta agli occhi come il calo del traffico è evidente quando si confronta la linea completa (ultimi tre mesi) con la linea tratteggiata (tre mesi precedenti).

- Analizzare separatamente i diversi tipi di ricerca, per comprendere se il calo riscontrato si è verificato nella Ricerca Google, in Google Immagini, nelle tab Video o Google News.

- Monitorare la posizione media nei risultati di ricerca. In generale, dice Waisberg, non dovremmo concentrarci troppo sulla “posizione assoluta”: impressioni e clic sono in definitiva i parametri di valutazione dell’efficacia del sito. Tuttavia, se notiamo un calo di posizione drastico e persistente, potremmo iniziare ad autovalutare i contenuti per verificare se sono utili e affidabili.

- Cercare pattern nelle pagine interessate dal calo. La tabella Pagine ci può servire a individuare l’eventuale presenza di pattern che potrebbero spiegare l’origine del calo. Ad esempio, un fattore importante è scoprire se il calo si è verificato nell’intero sito, in un gruppo di pagine o anche solo in una pagina molto importante del sito. Possiamo fare questa analisi confrontando il periodo di calo con un periodo simile e confrontando le pagine che hanno perso una quantità significativa di clic, seleziona “Differenza di clic” per ordinarla in base alle pagine che hanno perso più traffico. Se riscontriamo che si tratta di un problema a livello di sito, possiamo approfondire l’esame con il rapporto Indicizzazione della pagina; se il calo riguarda solo un gruppo di pagine, useremo invece lo strumento controllo URL per analizzare queste risorse.

Studiare il contesto del sito

Scavare a fondo nei rapporti, usando in supporto anche Google Trends o SEO tool come il nostro, può aiutare a capire in quale categoria ricade il nostro calo di traffico, e in particolare a scoprire se questa perdita di traffico fa parte di una tendenza più ampia del settore o se sta accadendo solo per le nostre pagine.

Ci sono due aspetti particolare da analizzare riguardanti il contesto d’azione del nostro sito:

- Cambiamenti dell’interesse di ricerca o nuovo prodotto. Se ci sono grandi cambiamenti in cosa e come le persone cercano (ne abbiamo avuto una dimostrazione con la pandemia), le persone possono iniziare a cercare query diverse o utilizzare i propri dispositivi per scopi diversi. Inoltre, se il nostro brand è un e-Commerce specifico online, potrebbe esserci un nuovo prodotto concorrente che cannibalizza le nostre query di ricerca.

- Stagionalità. Come sappiamo, ci sono alcune query e ricerche che seguono tendenze stagionali; ad esempio, quelle relative al cibo, perché “le persone cercano diete a gennaio, tacchino a novembre e champagne a dicembre” (almeno negli Stati Uniti) e diversi settori hanno diversi livelli di stagionalità o di peak season.

Analizzare le tendenze delle query

Waisberg suggerisce di usare Google Trends per analizzare le tendenze in diversi settori, perché fornisce l’accesso a un campione in gran parte non filtrato di richieste di ricerca effettive fatte a Google; inoltre, i dati sono “anonimizzati, classificati e aggregati”, permettendo a Google di mostrare interesse per argomenti di tutto il mondo o fino a livello di città.

Con questo strumento, possiamo controllare le query che stanno indirizzando il traffico nostro sito per vedere se hanno evidenti cali in diversi periodi dell’anno.

L’esempio nell’immagine seguente mostra tre tipi di tendenze:

- Il tacchino ha una forte stagionalità, con un picco ogni anno a novembre (periodo del Ringraziamento, di cui il tacchino è il piatto simbolo).

- Il pollo mostra una certa stagionalità, ma meno accentuata.

- Il caffè è significativamente più stabile e “sembra che le persone ne abbiano bisogno durante tutto l’anno”.

Sempre all’interno di Google Trends possiamo scoprire altri due insights interessanti che potrebbero aiutarci con il traffico di ricerca:

- Monitorare le query principali nella nostra regione e confrontarle con le query da cui riceviamo traffico, come mostrato nel rapporto sul rendimento di Search Console. Se nel traffico mancano delle query, controllare se il sito dispone di contenuti su quel topic e verificare che siano scansionati e indicizzati.

- Controllare le query relative ad argomenti importanti, che potrebbe far emergere query correlate in aumento e aiutarci a preparare adeguatamente il sito, ad esempio aggiungendo contenuti correlati.

Come analizzare i cali di traffico con la Search Console

Lo stesso Daniel Waisberg ha dedicato uno specifico episodio della serie Search Console Training su YouTube a illustrare i motivi principali alla base del calo del traffico da Ricerca Google, spiegando in modo particolare come analizzare i pattern delle diminuzioni del traffico verso il sito utilizzando il rapporto sul rendimento di Search Console e Google Trends per esaminare le tendenze generali nel proprio settore o nicchia di attività.

Secondo il Search Advocate di Google, familiarizzare con i motivi principali che possono esserci dietro ai cali di traffico organico può aiutarci a passare dal monitoraggio a un approccio esplorativo verso la ricerca dell’ipotesi più probabile su ciò che sta accadendo, primo step cruciale per provare a invertire la rotta.

I 4 pattern comuni di cali di traffico

Waisberg riprende le grafiche e le informazioni del suo articolo, aggiungendo qualche indicazione utile.

- Problemi tecnici site-level / Azioni Manuali

I problemi tecnici a livello di sito sono errori che possono impedire a Google di eseguire la scansione, indicizzazione o presentazione delle pagine agli utenti. Un esempio di problema tecnico site-level è un sito che non funziona: in questo caso, vedremmo un calo significativo del traffico, non solo da fonte Google Search.

Le azioni manuali, invece, colpiscono un sito che non segue le linee guida di Google, interessando alcune pagine o l’intero sito, che potrebbe quindi essere meno visibile nei risultati della Ricerca.

- Problemi tecnici page-level / Aggiornamenti algoritmici / Modifiche dell’interesse degli utenti

Differente è il caso dei problemi tecnici a livello di pagina, come ad esempio un tag noindex non intenzionale. Poiché questo problema dipende dalla scansione della pagina da parte di Google, genera un calo del traffico più lento rispetto ai problemi a livello di sito (la curva infatti è meno a picco).

Aspetto simile lo determinano i cali dovuti agli aggiornamenti algoritmici, frutto della continua azione migliorativa di Google nel suo modo di valutare i contenuti. Come sappiamo, i core update possono impattare sul rendimento di alcune pagine nella Ricerca Google anche nel tempo, e solitamente questo non avviene sotto forma di forte calo.

Un altro fattore che potrebbe determinare un lento calo del traffico è un’interruzione o modifica dell’interesse di ricerca: a volte, cambiamenti nel comportamento degli utenti provocano una variazione della domanda per determinate query, ad esempio per l’emergere di una nuova tendenza o di un cambiamento importante nel paese che stai osservando. Ciò significa che il traffico del sito potrebbe diminuire semplicemente a causa di influenze e fattori esterni.

- Stagionalità

Il terzo grafico identifica gli effetti della stagionalità, che possono essere causati da molte ragioni, come il clima, ferie o festività: di solito, questi eventi sono ciclici e si verificano a specifici intervalli regolari, ovvero su base settimanale, mensile o trimestrale.

- Glitch

L’ultimo esempio mostra i problemi di segnalazione o glitch: se vediamo un cambiamento importante seguito immediatamente dal ritorno alla normalità, potrebbe essere frutto di un semplice problema tecnico, e Google solitamente aggiunge un’annotazione al grafico per informarci della situazione.

I consigli per analizzare il pattern di calo

Dopo aver scoperto il calo (e dopo i primi, e inevitabili, momenti di panico…), dobbiamo cercare di diagnosticarne le case e, secondo Waisberg, il modo migliore per capire cosa è successo al nostro traffico è esaminare il rapporto sul rendimento di Search Console, che riassume molte informazioni utili e ci dà modo di vedere (e analizzare) la forma della curva della variazione, che già di per sé ci offre delle indicazioni.

Nello specifico, il Googler ci consiglia di espandere l’intervallo di date per includere gli ultimi 16 mesi (per visualizzare oltre i 16 mesi di dati, dobbiamo periodicamente esportare e archiviare le informazioni), così da analizzare il calo del traffico nel contesto e assicurarci che non sia legato a un evento stagionale regolare, come un periodo di festività o una tendenza. Per ulteriore conferma, poi, è opportuno confrontare il periodo di caduta con un periodo simile, come lo stesso mese dell’anno precedente o lo stesso giorno della settimana precedente, per semplificare la ricerca di cosa è esattamente cambiato (e provando a comparare preferibilmente lo stesso numero di giorni e gli stessi giorni della settimana).

Inoltre, dobbiamo navigare tra tutte le tab per scoprire dove è avvenuta la modifica e, in particolare, per capire se ha interessato su query, pagine, Paesi, dispositivi o Aspetto di Ricerca specifici. Analizzare i diversi tipi di ricerca separatamente ci aiuterà a capire se il calo è limitato al sistema Search o se riguarda anche Google Immagini, Video o la scheda Notizie.

Indagare le tendenze generali del settore di attività

L’emergere di cambiamenti importanti nel settore o Paese di attività può spingere le persone a cambiare modo di utilizzare Google, ovvero a cercare utilizzando query diverse o utilizzare i loro dispositivi per scopi diversi. Inoltre, se vendiamo un brand o un prodotto specifico online, potrebbe esserci un nuovo prodotto concorrente che cannibalizza le query di ricerca.

Insomma, la comprensione dei cali di traffico passa fortemente anche dall’analisi delle tendenze generali per il Web, e Google Trends fornisce l’accesso “a un campione in gran parte non filtrato di richieste di ricerca effettive fatto a Google”, con insights utili anche per la ricerca di immagini, notizie, acquisti e YouTube.

Inoltre, possiamo anche segmentare i dati per Paese e categoria così da rendere i dati più pertinenti per il pubblico del nostro sito web.

Dal punto di vista pratico, Waisberg suggerisce di controllare le query che stanno indirizzando il traffico verso il sito web per verificare se palesano cali evidenti in diversi periodi dell’anno: per esempio, le query relative al cibo sono molto stagionali, perché – negli Stati Uniti, ma non solo – le persone cercano “diete” a gennaio, “tacchino” a novembre e “champagne” a dicembre, e di fondo diversi settori hanno diversi livelli di stagionalità.

Perché il mio sito perde traffico?

La domanda diretta sui motivi per cui un sito possa perdere traffico organico è stata anche al centro di un interessante Hangout su Youtube in cui John Mueller ha risposto al dubbio di un utente, legato a un problema che affligge il suo sito: “Dal 2017 stiamo perdendo in modo graduale ranking in generale e anche su keyword rilevanti“, dice, aggiungendo di aver fatto delle verifiche sui backlink ricevuti, che nella metà dei casi derivano da un singolo sottodominio, e sui contenuti (auto-generati tramite un tool, non più usato da alcuni anni).

La domanda dell’utente è quindi duplice: innanzitutto, chiede un consiglio a Mueller su come arrestare il graduale calo di traffico, ma anche un suggerimento pratico sull’eventuale uso del disavow link per rimuovere tutti i backlink del sottodominio, temendo che tale azione possa provocare ulteriori effetti al ranking.

Individuare le cause del calo

Mueller comincia dalla seconda parte di domanda, e risponde in modo netto: “Se rimuovi col disavow una parte significativa dei tuoi link naturali ci possono essere sicuramente degli effetti negativi sul ranking”, confermando ancora una volta il peso dei link per il posizionamento su Google.

Venendo poi alla parte più pratica, e quindi alle cause possibili del calo di traffico e posizioni, il Googler pensa che i contenuti proposti possano essere buoni (“se si tratta di documenti informativi extra riguardanti il tuo sito, i prodotti o i servizi che offri”) e quindi non serve bloccarli o rimuoverli dall’indicizzazione. Pertanto, a prima vista si può dire che “né i link né i contenuti sono direttamente le cause del calo del sito”.

Traffico SEO, i motivi per cui un sito perde ranking

Mueller articola la sua risposta in maniera più estesa, dicendo che in casi del genere, “quando stai vedendo una specie di calo graduale per un periodo di tempo abbastanza lungo”, può esserci una sorta di “naturale variazione del posizionamento” che può essere determinata da cinque possibili motivi.

- Cambiamenti dell’ecosistema Web.

- Modifiche dell’algoritmo.

- Cambiamenti delle ricerche degli utenti.

- Cambiamenti delle aspettative degli utenti sui contenuti.

- Cambiamenti graduali che non derivano da grandi e drammatici problemi dei siti Web.

Il sistema di posizionamento di Google è in continuo movimento e c’è sempre chi sale e chi scende (il miglioramento di ranking di un sito è la perdita di posizione di un altro, inevitabilmente). Premesso questo, possiamo approfondire le cause citate nell’hangout.

Quando un sito perde traffico e posizioni

Tra le modifiche all’ecosistema, secondo l’interpretazione di Roger Montti su SearchEngineLand, vanno inserite situazioni come l’aumento della concorrenza o la “naturale scomparsa dei backlink” perché i siti linkanti sono andati offline o hanno rimosso il collegamento, e comunque tutti i fattori esterni al sito che possono provocare perdita di ranking e traffico.

Più chiaro il ragionamento sui cambiamenti dell’algoritmo, e sappiamo quanto stiano diventando frequenti anche i broad core update, che ridefiniscono il significato della rilevanza di una pagina Web per una query di ricerca e la sua attinenza al search intent delle persone.

Proprio gli utenti sono i “protagonisti” delle altre due ragioni citate: lo stiamo ripetendo in maniera quasi ossessiva, ma comprendere le intenzioni delle persone è la chiave per fare contenuti di qualità e per avere un sito performante, e quindi è importante seguire le evoluzioni delle query ma anche conoscere le tipologie di contenuto che Google sta premiando (perché piacciono agli utenti).

Come risollevare un sito dopo la perdita di traffico

Mueller offriva anche qualche spunto pratico per uscire dalle situazioni di traffico in calo: il primo suggerimento è rimboccarsi le maniche e guardare con più attenzione alle problematiche globali del sito, cercando aree in cui è possibile apportare miglioramenti significativi e provando a rendere i contenuti più pertinenti per le tipologie di utenti che rappresentano il nostro target.

Più in generale, il Senior Webmaster Trends Analyst di Google ci dice che spesso serve dare una “seconda occhiata” al sito e al suo contesto, non fermarsi a quella che potrebbe apparire la prima causa del declino (nel caso specifico del vecchio hangout, i backlink) ma approfondire lo studio e valutare tutti i possibili fattori che influenzano il calo di ranking e di traffico.

Algoritmi, sanzioni e qualità per Google, come capire cali di traffico SEO

Ben più esaustivi e approfonditi sono i consigli arrivati da Pedro Dias, che ha lavorato nel team Google Search Quality tra il 2006 e il 2011 e che in un articolo pubblicato su Search Engine Land ci accompagna ad applicare il giusto approccio alle situazioni di cali di traffico SEO. Il punto di partenza del suo ragionamento è che è cruciale comprendere davvero se il traffico diminuisce a causa di un update o se intervengono altri fattori come azioni manuali, sanzioni eccetera, perché solo conoscendo le loro differenze e le conseguenze che generano – e individuando quindi il motivo scatenante del problema – è possibile reagire con la giusta strategia.

Comprendere come funzionano gli algoritmi e le azioni manuali

L’ex Googler premette che la sua percezione potrebbe pertanto essere attualmente obsoleta, visto che le cose a Google cambiano a un ritmo più che rapido, ma, forte comunque della sua esperienza di lavoro presso “la casella di input più ricercata di tutto il Web”, Dias ci offre indicazioni utili e interessanti su “cosa fa funzionare Google e come funziona la ricerca, con tutti i suoi dadi e bulloni”.

Nello specifico, analizza “questo minuscolo campo di input e il potere che esercita sul Web e, in definitiva, sulle vite di chi gestisce un sito Web”, e chiarisce alcuni concetti, come le penalizzazioni, per insegnarci a distinguere le varie forme e cause per cui Google può far “crollare” un sito

Gli algoritmi di Google sono come ricette

“Non sorprende il fatto che chiunque abbia una presenza sul Web di solito trattiene il respiro ogni volta che Google decide di apportare modifiche ai suoi risultati di ricerca organici”, scrive l’ex Googler, che poi ricorda come “essendo principalmente una software engineering company, Google miri a risolvere tutti i suoi problemi su larga scala, anche perché sarebbe “praticamente impossibile risolvere i problemi che Google deve affrontare esclusivamente con l’intervento umano”.

Per Dias, “gli algoritmi sono come le ricette: una serie di istruzioni dettagliate in un ordine particolare che mirano a completare un’attività specifica o a risolvere un problema”.

Meglio piccoli algoritmi per risolvere un problema alla volta

La probabilità che un algoritmo “produca il risultato atteso è indirettamente proporzionale alla complessità del compito che deve completare”: questo significa che “il più delle volte, è meglio avere più (piccoli) algoritmi che risolvono un (grande) problema complesso, scomponendolo in semplici sotto-attività, piuttosto che un gigantesco algoritmo singolo che cerca di coprire tutte le possibilità”.

Finché c’è un input, prosegue l’esperto, “un algoritmo funzionerà instancabilmente, restituendo ciò per cui è stato programmato; la scala in cui opera dipende solo dalle risorse disponibili, come l’archiviazione, la potenza di elaborazione, la memoria e così via”.

Questi sono “algoritmi di qualità, che spesso non fanno parte dell’infrastruttura”, ma esistono anche “algoritmi di infrastruttura che prendono decisioni su come il contenuto viene sottoposto a scansione e archiviato, ad esempio”. La maggior parte dei motori di ricerca “applica algoritmi di qualità solo al momento della pubblicazione dei risultati di ricerca: i risultati, cioè, sono valutati solo qualitativamente, al momento del servizio”.

Gli aggiornamenti algoritmici per Google

In Google, gli algoritmi di qualità “sono visti come filtri che mirano a far emergere buoni contenuti e cercano segnali di qualità in tutto l’indice di Google”, che sono spesso forniti a livello di pagina per tutti i siti web e che possono quindi essere combinati, producendo “punteggi a livello di directory o di hostname, ad esempio”.

Per i proprietari di siti Web, i SEO e gli esperti di marketing digitale, in molti casi, “l’influenza degli algoritmi può essere percepita come penalità, soprattutto quando un sito Web non soddisfa pienamente tutti i criteri di qualità e gli algoritmi di Google decidono invece di premiare altri siti Web di qualità superiore”.

Nella maggior parte di questi casi, ciò che gli utenti comuni vedono è “un calo delle prestazioni organiche”, che non deriva necessariamente dal fatto che il sito sia stato “spinto giù”, ma più probabilmente “perché ha smesso di essere valutato in modo scorretto, il che può essere positivo o negativo”.

Che cos’è la qualità

Per capire come funzionano questi algoritmi di qualità, dobbiamo prima capire cos’è la qualità, spiega giustamente Dias: come diciamo spesso parlando di articoli di qualità, questo valore è soggettiva, sta “negli occhi di chi guarda”.

La qualità “è una misura relativa all’interno dell’universo in cui viviamo, dipende dalla nostra conoscenza, esperienza e ambiente”, e “ciò che per una persona è qualità, probabilmente per un altro potrebbe non esserlo”. Non possiamo “legare la qualità a un semplice processo binario privo di contesto: ad esempio, se sto morendo di sete nel deserto, mi interessa se una bottiglia d’acqua ha la sabbia sul fondo?”, aggiunge l’autore.

Per i siti web non è diverso: la qualità è, fondamentalmente, fornire “prestazioni oltre le aspettative (Performance over Expectation) o, in termini di marketing, Value Proposition”.

Le valutazioni di Google sulla qualità

Se la qualità è relativa, dobbiamo cercare di capire come fa Google a stabilire cosa sia rispondente ai suoi valori e cosa non lo sia.

In realtà, dice Dias, “Google non detta cosa sia e cosa non sia qualità: tutti gli algoritmi e la documentazione che Google utilizza per le sue Istruzioni per i webmaster (che ora sono confluite nelle Google Search Essentials, ndr) si basano su feedback e dati reali degli utenti”. È anche per questo motivo, possiamo aggiungere, che Google impiega una squadra di oltre 14mila Quality Raters, chiamati a valutare appunto la qualità dei risultati di ricerca forniti dagli algoritmi, usando come bussola le apposite Google quality rater guidelines, che pure cambiano e sono aggiornate frequentemente (l’ultima volta a luglio 2022).

Lo dicevamo anche parlando di search journey: quando “gli utenti eseguono ricerche e interagiscono con i siti Web sull’indice, Google analizza il comportamento degli utenti e spesso esegue più test ricorrenti, al fine di assicurarsi che sia allineato ai loro intenti e bisogni”. Questo processo “garantisce che le linee guida per i siti web emesse da Google si allineino a ciò che vogliono gli utenti del motore di ricerca, non sono necessariamente ciò che Google vuole unilateralmente”.

Gli aggiornamenti dell’algoritmo inseguono gli utenti

Questo è il motivo per cui Google afferma spesso che “gli algoritmi sono fatti per inseguire gli utenti”, ricorda l’articolo, che quindi invita parimenti i siti a “inseguire gli utenti invece degli algoritmi, così da essere alla pari con la direzione verso cui si muove Google”.

Ad ogni modo, “per comprendere e massimizzare il potenziale di risalto di un sito web, dovremmo guardare i nostri siti web da due diverse prospettive, di Servizio e di Prodotto“.

Il sito come un servizio

Quando guardiamo un sito web dal punto di vista del servizio, dovremmo analizzare innanzitutto tutti gli aspetti tecnici coinvolti, dal codice all’infrastruttura: ad esempio, tra tante altre cose “come è progettato per funzionare, quanto è tecnicamente robusto e coerente, come gestisce il processo di comunicazione con altri server e servizi, e poi ancora le integrazioni e il rendering front-end”.

Questa analisi, da sola, non basta perché “tutti i fronzoli tecnici non creano valore dove e se il valore non esiste”, sottolinea Pedro Dias, ma al massimo “aggiungono valore e fanno risplendere al meglio qualsiasi valore nascosto”. Per questo motivo, consiglia l’ex Googler, “si dovrebbe lavorare sui dettagli tecnici, ma anche considerare di guardare il proprio sito Web dal punto di vista del prodotto”.

Il sito come un prodotto

Quando guardiamo un sito Web dal punto di vista del prodotto, “dovremmo mirare a comprendere l’esperienza che gli utenti hanno su di esso e, in definitiva, quale valore stiamo fornendo per distinguerci dalla concorrenza”.

Per rendere questi elementi “meno eterei e più tangibili”, Dias ricorre a una domanda che pone ai suoi clienti: “Se il tuo sito scomparisse oggi dal Web, cosa mancherebbe ai tuoi utenti, che non troverebbero in nessuno dei siti web della concorrenza?”. È dalla risposta che si capisce “se si può puntare a costruire una strategia di business sostenibile e duratura sul web”, e per aiutarci a capire meglio questi concetti ci fornisce questa immagine – l’User Experience Honeycomb di Peter Morville, modificata per inserire un riferimento al concetto specifico di EEAT che fa parte delle linee guida per i valutatori di qualità di Google.

La maggior parte dei professionisti SEO esamina in profondità gli aspetti tecnici della UX come accessibilità, usabilità e possibilità di essere trovati (che riguardano, in effetti, la SEO), ma tendono a tralasciare gli aspetti qualitativi (più strategici), come Utilità, Desiderabilità e Credibilità.

Al centro di questo alveare c’è il Valore (“Value”), che può essere “pienamente raggiunto solo quando tutti gli altri fattori circostanti sono soddisfatti”: quindi, “applicarlo alla tua presenza sul web significa che, a meno che tu non guardi l’intera esperienza olistica, perderai l’obiettivo principale del tuo sito web, che è creare valore per te e i tuoi utenti”.

La qualità non è statica, ma in evoluzione

A complicare ulteriormente le cose c’è il fatto che “la qualità è un obiettivo in movimento”, non è statica, e quindi un sito che vuole “essere percepito come di qualità deve fornire valore, risolvere un problema o un’esigenza” in maniera costante nel tempo. Allo stesso modo, anche Google deve evolvere per garantire sempre il massimo livello di efficacia delle sue risposte, ed è per questo che “esegue costantemente test, spingendo aggiornamenti di qualità e miglioramenti degli algoritmi”.

Come dice Dias, “se avvii il tuo sito e non lo migliori mai, nel tempo i tuoi concorrenti alla fine ti raggiungeranno, migliorando la tecnologia del loro sito o lavorando sull’esperienza e sulla proposta di valore”. Proprio come la vecchia tecnologia diventa obsoleta e deprecata, “nel tempo anche le esperienze innovative tendono a diventare ordinarie e molto probabilmente non riescono ad andare oltre le aspettative”.

Per chiarire il concetto, l’ex Googler fa un esempio immediato: “Nel 2007 Apple ha conquistato il mercato degli smartphone con un dispositivo touch screen, ma al giorno d’oggi, la maggior parte delle persone non prenderà nemmeno in considerazione un telefono che non abbia un touchscreen, perché è diventato un dato di fatto e non può più essere utilizzato come vantaggio competitivo”.

E anche la SEO non può essere un’azione una tantum: non è che “dopo aver ottimizzato una volta il sito, questo resta ottimizzato in modo permanente”, ma “qualsiasi area che sostiene un’azienda deve migliorare e innovare nel tempo, per rimanere competitiva”.

Altrimenti, “quando tutto questo viene lasciato al caso o non diamo l’attenzione necessaria per assicurarci che tutte queste caratteristiche siano comprese dagli utenti, è proprio allora che i siti iniziano a incorrere in problemi di prestazioni organiche”.

Le azioni manuali possono completare gli aggiornamenti algoritmici

Sarebbe ingenuo “presumere che gli algoritmi siano perfetti e facciano tutto ciò che dovrebbero fare in modo impeccabile”, ammette Dias, secondo cui il grande vantaggio “degli umani nella battaglia contro le macchine è che possiamo affrontare gli imprevisti”.

Abbiamo cioè “la capacità di adattarci e comprendere le situazioni anomale, e capire perché qualcosa può essere buono anche se potrebbe sembrare cattivo, o viceversa”. Vale a dire, “gli esseri umani possono dedurre il contesto e l’intenzione, mentre le macchine non sono così brave”.

Nel campo del software engineering, “quando un algoritmo rileva o perde una cosa che non avrebbe dovuto, genera quello che viene indicato rispettivamente come falso positivo o falso negativo”; per applicare le giuste correzioni, bisogna identificare “l’output di falsi positivi o falsi negativi, un compito che spesso è svolto al meglio dagli esseri umani”, e quindi di solito “gli ingegneri impostano un livello di fiducia (soglia) che la macchina dovrebbe considerare prima di richiedere l’intervento umano”.

Quando e perché scatta un’azione manuale

Dentro la Search Quality ci sono “team di persone che valutano i risultati e guardano i siti web per assicurarsi che gli algoritmi funzionino correttamente, ma anche per intervenire quando la macchina sbaglia o non può prendere una decisione”, rivela Pedro Dias, che introduce quindi la figura del Search Quality Analyst.

Il compito di questo analista della qualità della ricerca è “capire ciò che ha davanti, esaminando i dati forniti, e formulare giudizi: queste chiamate di giudizio possono essere semplici, ma sono spesso supervisionate, approvate o rifiutate da altri Analisti a livello globale, al fine di ridurre al minimo i pregiudizi umani”.

Questa attività si traduce frequentemente in azioni statiche che mirano a (ma non solo):

- Creare una serie di dati che possono essere successivamente utilizzati per allenare gli algoritmi;

- Affrontare situazioni specifiche e di impatto, in cui gli algoritmi hanno fallito;

- Segnalare ai proprietari di siti web che comportamenti specifici non rientrano nelle linee guida sulla qualità.

Queste azioni statiche vengono spesso definite azioni manuali, e possono essere attivate per un’ampia varietà di motivi, anche se “l’obiettivo più comune resta contrastare l’intento manipolativo, che per qualche motivo è riuscito a sfruttare con successo un difetto negli algoritmi di qualità”.

Lo svantaggio delle azioni manuali “è che sono statiche e non dinamiche come gli algoritmi: questi ultimi cioè funzionano continuamente e reagiscono alle modifiche sui siti Web, in base solo alla ripetizione della scansione o al perfezionamento dell’algoritmo”. Al contrario, “con le azioni manuali l’effetto rimarrà per tutto il tempo previsto (giorni / mesi / anni) o fino a quando una richiesta di riconsiderazione non viene ricevuta ed elaborata con successo”.

Le differenze tra l’impatto di algoritmi e azioni manuali

Pedro Dias fornisce anche un utile specchietto sintetico che mette a confronto algoritmi e azioni manuali:

| Algoritmi – Mirano al valore del resurfacing – Lavoro su larga scala – Dinamico – Completamente automatizzato – Durata indefinita |

Azioni manuali – Mirano a penalizzare il comportamento – Affrontano scenari specifici – Statico Manuale + Semiautomatico – Durata definita (data di scadenza) |

Prima di applicare qualsiasi azione manuale, un search quality analyst “deve considerare ciò che sta affrontando, valutare l’impatto e il risultato desiderato”, rispondendo a domande come ad esempio:

- Il comportamento ha intenti manipolativi?

- Il comportamento è abbastanza eclatante?

- L’azione manuale avrà un impatto?

- Quali cambiamenti produrrà l’impatto?

- Cosa sto penalizzando (comportamento diffuso o singolo)?

Come spiega l’ex Googler, questi sono aspetti che “devono essere adeguatamente ponderati e considerati prima ancora di prendere in considerazione qualsiasi azione manuale”.

Cosa fare in caso di azione manuale

Visto che Google si sposta “sempre più verso soluzioni algoritmiche, sfruttando l’intelligenza artificiale e l’apprendimento automatico sia per migliorare i risultati che per combattere lo spam, le azioni manuali tenderanno a svanire e alla fine scompariranno completamente nel lungo periodo”, sostiene Dias.

Ad ogni modo, se il nostro sito web è stato colpito da azioni manuali “la prima cosa che devi fare è capire quale comportamento lo ha attivato”, facendo riferimento “alle linee guida tecniche e di qualità di Google per valutare il tuo sito web in base a esse”.

Questo è un lavoro da svolgere con calma e accuratezza, perché “non è il momento di lasciare che il senso di fretta, stress e ansia prendano il comando”; è importante “raccogliere tutte le informazioni, fare piazza pulita degli errori e dei problemi del sito, aggiustare tutto e solo dopo inviare una richiesta di riconsiderazione”.

Come recuperare dalle azioni manuali

Una convinzione diffusa, ma sbagliata, è “che quando un sito è colpito da un’azione manuale e perde traffico e posizionamento, tornerà allo stesso livello una volta revocate le azioni manuali”. Quel ranking, infatti, è frutto (anche) dell’uso di strumenti non consentiti (che hanno provocato la penalizzazione), quindi non ha senso che, dopo la pulizia e la revoca dell’azione manuale, il sito possa tornare esattamente dov’era prima.

Comunque, tiene a sottolineare l’esperto, “qualsiasi sito Web può essere ripristinato da quasi tutti gli scenari” e i casi in cui una proprietà è considerata “irrecuperabile sono estremamente rari”. È però importante che il recupero inizi da “una piena comprensione di ciò con cui hai a che fare”, con la consapevolezza che “azioni manuali e problemi algoritmici possono coesistere” e che “a volte, non inizierai a vedere nulla prima di stabilire le priorità e risolvere tutti i problemi nell’ordine giusto”.

In realtà “non esiste un modo semplice per spiegare cosa cercare e i sintomi di ogni singolo problema algoritmico”, e quindi “il consiglio è di pensare alla tua proposta di valore, al problema che stai risolvendo o alla necessità a cui stai rispondendo, senza dimenticare di chiedere feedback ai tuoi utenti, invitandoli a esprimere opinioni sulla tua attività e sull’esperienza che fornisci sul tuo sito, o su come si aspettano che tu migliori”.

I takeaway sui cali algoritmici o derivanti da azioni manuali

In conclusione, Pedro Dias ci lascia quattro pillole per sintetizzare il suo (esteso) contributo alla causa dei siti penalizzati da aggiornamenti algoritmici o azioni manuali.

- Ripensa la tua proposta di valore e il tuo vantaggio competitivo, perché “avere un sito Web non è di per sé un vantaggio competitivo”.

- Tratta il tuo sito web come un prodotto e innova costantemente: “se non vai avanti, verrai superato, mentre i siti di successo migliorano ed evolvono continuamente”.

- Ricerca i bisogni dei tuoi utenti attraverso la User Experience: “la priorità sono i tuoi utenti, e poi Google”, per cui è utile “parlare e interagire con i tuoi utenti e chiedere le loro opinioni per migliorare le aree critiche”.

- La SEO tecnica è importante, ma da sola non risolverà nulla: “Se il tuo prodotto / contenuto non ha appeal o valore, non importa quanto sia tecnico e ottimizzato, e quindi è cruciale non perdere la value proposition”.

Traffico sito: cosa fare quando calano le altre fonti

Dopo aver analizzato attentamente le possibili cause di perdita di traffico organico è utile provare a fornire qualche indicazione anche sui cali di traffico che interessano le altre fonti che concorrono al successo di un sito, come il traffico a pagamento, diretto e referral. Ciascuna di esse può essere influenzata da diverse variabili, sia interne che esterne, e un monitoraggio costante ci consente non solo di individuare eventuali problemi, ma anche di intervenire tempestivamente con azioni correttive.

- Traffico a pagamento: cali e rimedi

Il primo segnale di un calo nel traffico a pagamento è spesso collegato a una riduzione dell’efficacia delle campagne pubblicitarie. Potrebbe trattarsi di un’errata configurazione, di una mancata ottimizzazione delle parole chiave o di un investimento inadeguato; mettere in pausa o concludere una campagna senza un’adeguata pianificazione o, semplicemente, non ottimizzarla in tempo reale rispetto ai risultati raccolti, può portare rapidamente a una diminuzione dei clic e delle conversioni.

Il bilanciamento tra budget e rendimento è infatti fondamentale: se i fondi delle campagne non sono sufficienti o il costo per clic (CPC) è troppo elevato rispetto alla concorrenza, gli annunci potrebbero esaurire rapidamente l’esposizione, causando un calo delle visite pianificate.

Esistono, inoltre, altri fattori che possono determinare una performance ridotta, come l’obiettivo delle campagne troppo generico o l’inefficienza delle pagine di destinazione che non convertono, generando indirettamente un aumento del tasso di rimbalzo. Se la landing page non offre un’esperienza adeguata, anche il più elevato numero di clic non si trasformerà in risultati concreti. Allo stesso tempo, monitorare costantemente il punteggio di qualità degli annunci consente di identificare problemi di rilevanza tra parole chiave, testo dell’annuncio e pagina di atterraggio, la cui disconnessione potrebbe portare a un calo del traffico e dei clic.

Un rimedio chiaro è quello di aggiornare la strategia di ottimizzazione. Raffinare le parole chiave su cui si focalizza l’asta degli annunci, aumentare o riallocare il budget su campagne più performanti e ottimizzare la pagina di destinazione sono passaggi cruciali. Bisogna regolarmente testare diverse combinazioni di annunci e copy creativi per individuare le configurazioni migliori con l’ausilio di report periodici. Questo continuo processo di ottimizzazione aiuterà a far tornare in equilibrio il rapporto tra visite e conversioni.

- Traffico diretto: cause di calo e interventi correttivi

Nel caso di un calo nel traffico diretto, spesso ci troviamo di fronte a una diminuzione dell’interesse o della familiarità dell’utenza verso il sito. Crolli in questa voce possono essere un sintomo di un indebolimento del brand, dell’esaurimento di eventuali campagne promozionali finalizzate a fidelizzare il pubblico o di problemi legati all’esperienza d’uso del sito.

Torna quindi importante analizzare e migliorare il branding e l’esperienza degli utenti abituali. Quando gli utenti smettono di tornare direttamente al nostro dominio, potrebbe significare che le attività di fidelizzazione non sono più sufficientemente coinvolgenti o che è calata l’incisività del brand nella loro quotidianità. Anche problemi tecnici sul sito, una navigazione difficoltosa o una velocità di caricamento insoddisfacente potrebbero disincentivare i visitatori abituali, portandoli alla ricerca di alternative con maggiore usabilità.

Per invertire questa tendenza, è utile rafforzare le azioni che aumentano la brand awareness e migliorare l’interazione con il pubblico già fidelizzato. Incentivare le visite dirette attraverso campagne di email marketing, contenuti regolari e di qualità, e rivitalizzare le strategie di engagement anche attraverso altre fonti (ad esempio, social media o PR) o aggiornare il sito per assicurarsi che l’usabilità sia sempre ottimale sono tutte strategie efficaci. Se il sito perde d’interesse, potrebbe anche essere utile esplorare nuove formule di coinvolgimento per mantenere viva l’attenzione del pubblico.

- Traffico referral: identificazione delle problematiche e correzioni

Anche le cause di un calo nel traffico referral possono essere molteplici, ma frequente è la perdita di rilevanza o funzionalità dei backlink. Se i link che generano traffico verso il nostro sito diventano meno accessibili (ad esempio, per un errore SEO nel sito di partenza o perché quella pagina è stata eliminata), il flusso di utenti che giunge tramite tali referral diminuisce.

Un’altra causa potenziale riguarda l’importanza delle partnership e del livello di qualità e autenticità dei link: collaborazioni che prima risultavano efficaci potrebbero non generare più lo stesso ritorno se non sono mantenute robuste o aggiornate. Cambiamenti nella politica di link earning o aggiornamenti algoritmi (in particolar modo sugli outbound link) possono incidere negativamente.

Il debug dei link non funzionanti e la revisione delle collaborazioni esistenti possono aiutare a riprendere queste dinamiche. Un controllo con SEOZoom aiuterà a scoprire l’origine di link deboli o non più efficienti. Da lì, risolvere gli errori o stipulare nuove partnership non solo ripristina il traffico, ma può potenziarlo ulteriormente.