Scopriamo Googlebot, il crawler di Google che scansiona i siti

Il nome fa pensare immediatamente a qualcosa di simpatico e in effetti anche l’immagine coordinata conferma questa sensazione: più di tutto, però, Googlebot è il fondamentale software spider con cui Google riesce a eseguire la scansione delle pagine dei siti Web pubblici, seguendo i link che partono da una pagina e la collegano alle altre della Rete e selezionando quindi le risorse che meritano di entrare nell’Indice del motore di ricerca. Insomma, questo robottino è alla base dell’intero processo di scansione e indicizzazione di Google, da cui poi deriva il sistema di classificazione, e non è quindi un caso che il team del motore di ricerca abbia dedicato più attenzione al tema: proviamo a scoprire tutto ciò che serve sapere su Googlebot, il crawler che ha il compito di scandagliare il Web alla ricerca di siti e contenuti per conto di Big G.

Che cos’è Googlebot

Oggi facciamo quindi un passo indietro rispetto alle questioni legate alle pratiche di ottimizzazione e cerchiamo di spiegare sinteticamente cos’è Googlebot e come funziona, ma soprattutto perché è importante per un sito sapere in che modo Google ci guarda – in estrema sintesi, perché avere nozioni di base su come funzionano la scansione e l’indicizzazione del motore di ricerca possono aiutarci a intuire, prevenire o risolvere i problemi tecnici SEO e a garantire che le pagine del sito siano opportunamente accessibili ai crawler stessi.

L’ultimo spunto in ordine cronologico per approfondire l’argomento arriva dall’aggiornamento della guida ufficiale di Google a Googlebot, ma già in precedenza il crawler era stato al centro di un episodio di SEO Mythbusting, la serie su YouTube realizzata da Martin Splitt che, spinto dalle richieste di tanti webmaster e sviluppatori e dalla domanda precisa di Suz Hinton (Cloud Developer Advocate presso Microsoft, ospite dell’occasione), si è dilungato a chiarire alcune caratteristiche di questo software.

In questa occasione, Splitt aveva fornito una chiara e semplice definizione di Googlebot, che sostanzialmente è un programma che esegue tre funzioni: la prima è il crawling, l’analisi approfondita del Web alla ricerca di pagine e contenuti; la seconda è indicizzare tali risorse e la terza è il “ranking”, che però “non fa più Googlebot”, specifica meglio.

In pratica, il bot prende contenuti da Internet, cerca di capire l’argomento dei contenuti e quali “materiali” possono essere proposti agli utenti che cercano “queste cose”, e infine determina quali delle risorse precedentemente indicizzate è effettivamente la migliore per quella specifica query in quel particolare momento.

Cosa fa Googlebot e a cosa serve

Volendo approfondire meglio, Googlebot è un software speciale, comunemente denominato spider, crawler o semplicemente bot, che esegue la scansione del web seguendo i link che trova all’interno delle pagine per trovare e leggere contenuti nuovi o aggiornati e suggerire cosa dovrebbe essere aggiunto all’Indice, la biblioteca con inventario in continua espansione da cui Google estrae direttamente i risultati della ricerca online.

Questo software consente a Google di compilare oltre 1 milione di GB di informazioni in una frazione di secondo, e quindi dietro al suo aspetto carino – l’immagine ufficiale di Googlebot raffigura appunto un simpatico robottino con lo sguardo vivace e vagamente simile a Wall-E, pronto a lanciarsi in una ricerca per trovare e indicizzare la conoscenza in tutti gli angoli di Web ancora sconosciuti – c’è una macchina potente che esegue la scansione del Web e aggiunge pagine al suo indice costantemente.

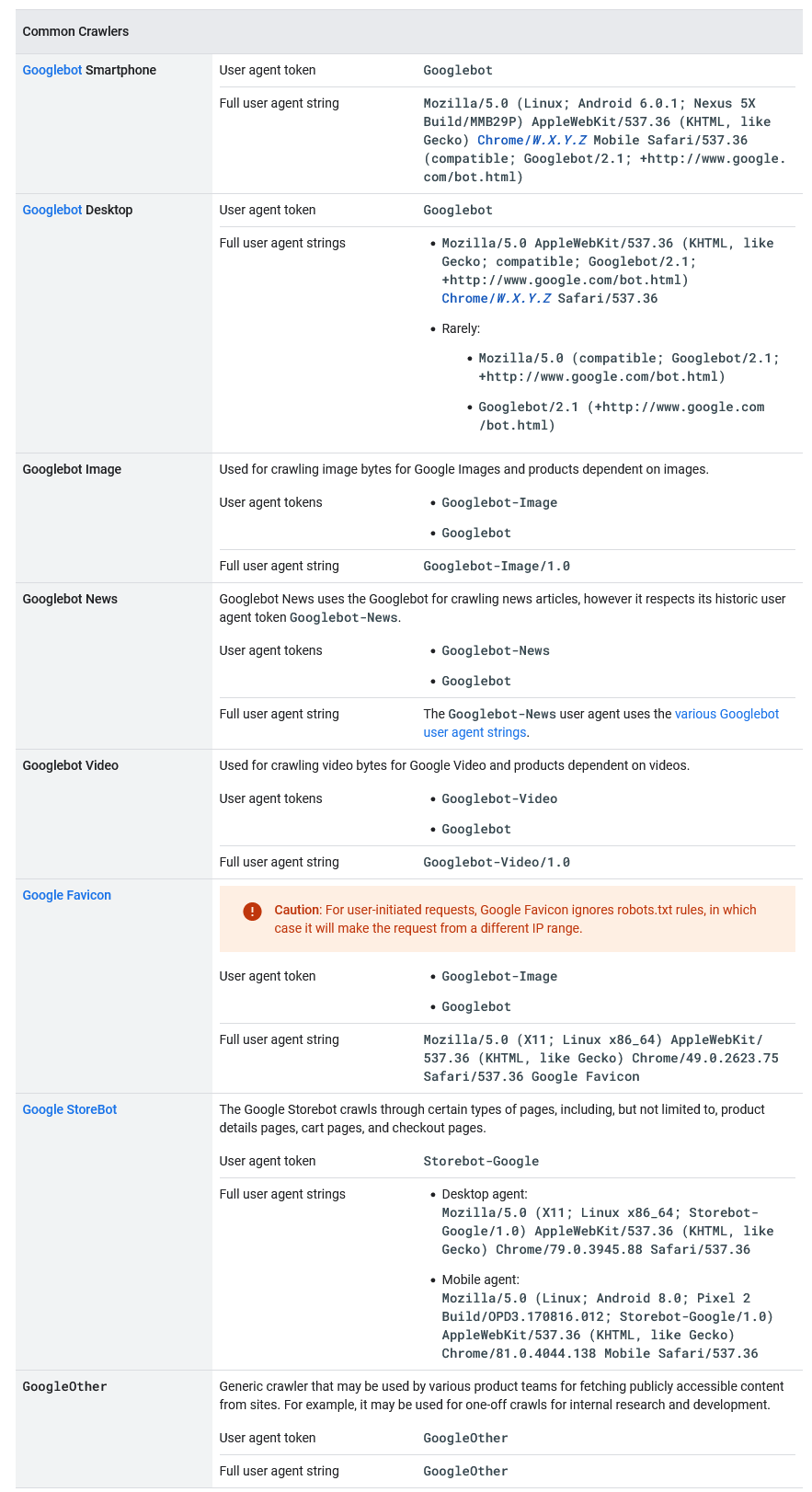

Più precisamente, poi, Googlebot è il nome generico di due diversi tipi di crawler: un crawler desktop che simula un utente che usa un dispositivo desktop e un crawler mobile che simula un utente che usa un dispositivo mobile. A volte il nostro sito è visitato da entrambe le versioni di Googlebot (e nel caso possiamo identificare il sottotipo di Googlebot esaminando la stringa dello user agent nella richiesta), ma se il nostro sito è stato già convertito in mobile-first su Google, la maggior parte delle richieste di scansione di Googlebot viene effettuata usando il crawler mobile, mentre una piccola parte viene effettuata con il crawler desktop, e viceversa per i siti che non sono stati ancora convertiti (come spiega Google infatti, il crawler di minoranza effettua la scansione soltanto degli URL già sottoposti a scansione dal crawler di maggioranza).

Inoltre, sempre dal punto di vista tecnico sia Googlebot desktop che Googlebot mobile condividono lo stesso token di prodotto (token dello user agent) nel file robots.txt, quindi non possiamo impostare selettivamente come target Googlebot per smartphone o Googlebot per desktop usando il file robots.txt.

Gli altri bot di Google

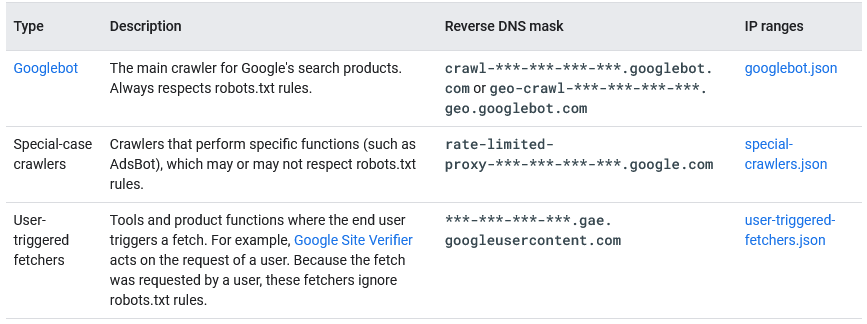

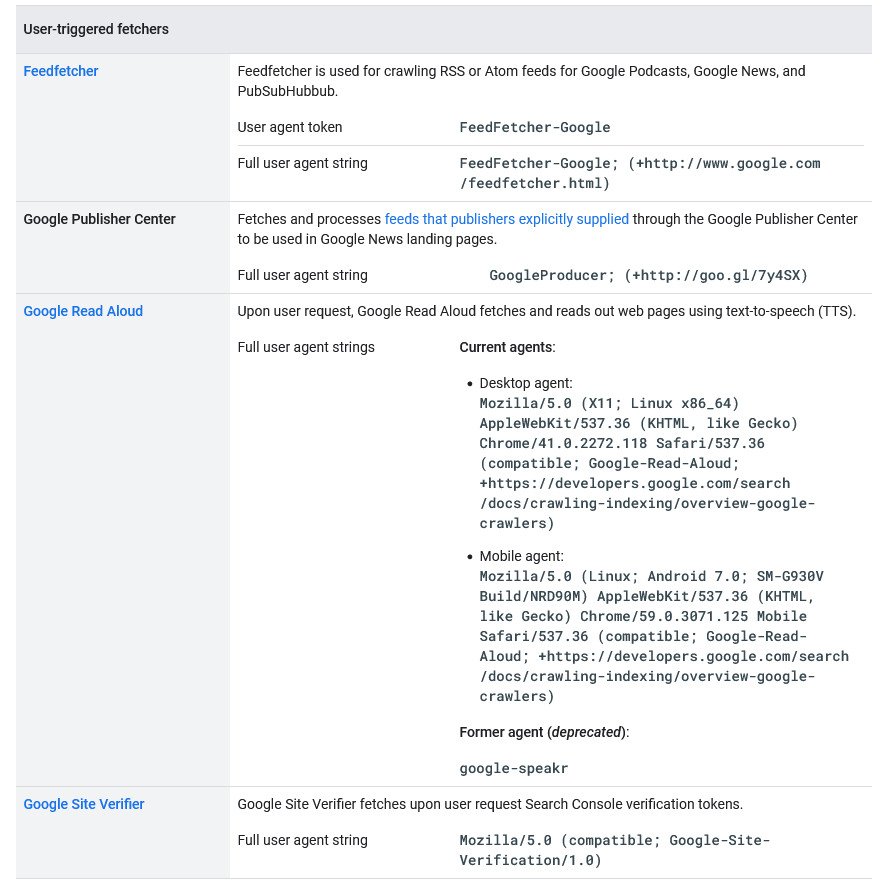

Google utilizza crawler e fetcher (strumenti come un browser che richiedono un singolo URL quando richiesto da un utente) per eseguire azioni per i suoi prodotti, automaticamente o attivate su richiesta dell’utente. Googlebot è soltanto il principale crawler di Google, ma non è l’unico e anzi esistono diversi robot, che hanno compiti specifici e che possono essere inclusi in tre grandi categorie, come spiega la nuova versione del documento ufficiale di Mountain View, aggiornata alla fine di aprile 2023:

- Crawler comuni, tra cui appunto Googlebot, che vengono utilizzati per creare gli indici di ricerca di Google, eseguire altre scansioni specifiche del prodotto e per l’analisi. Per caratteristica distintiva, rispettano sempre le regole del file robots.txt, hanno come maschera DNS inversa “crawl-***-***-***-***.googlebot.com o geo-crawl-***-***-***-***.geo. googlebot.com” e l’elenco degli intervalli IP si trova nello specifico file googlebot.json.

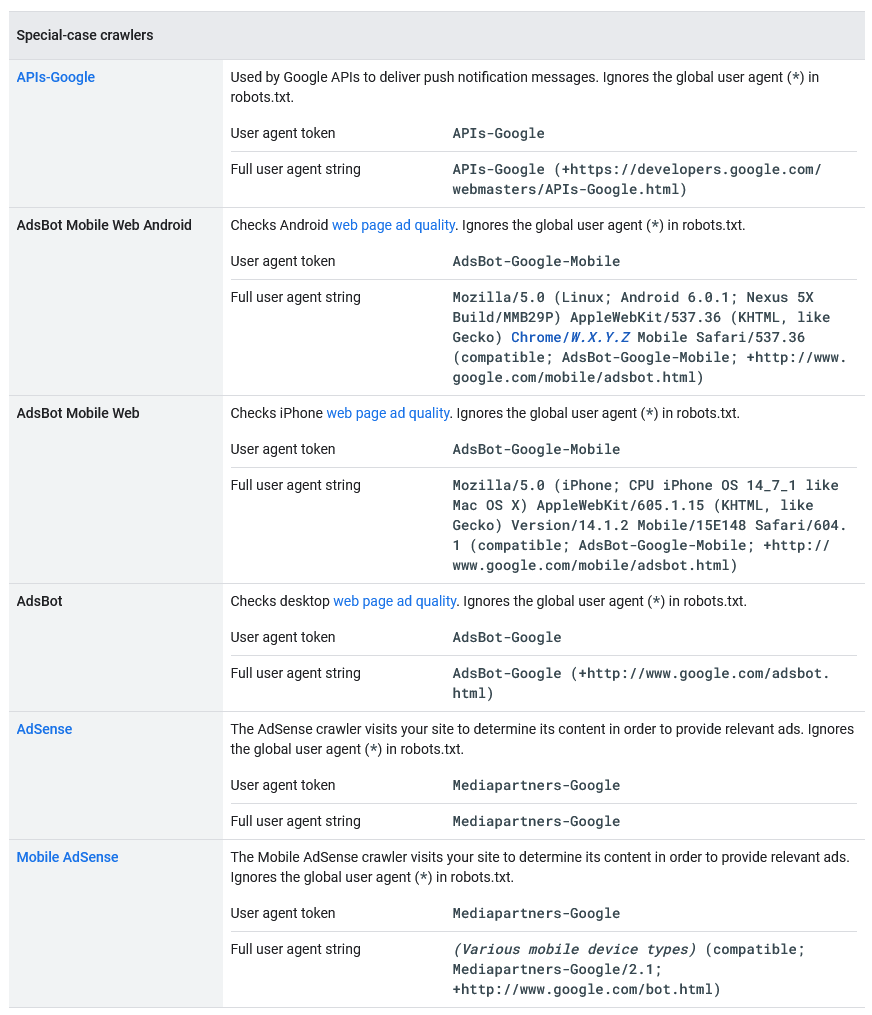

- Crawler speciali: crawler che eseguono funzioni specifiche, utilizzati da prodotti specifici in cui esiste un accordo tra il sito sottoposto a scansione e il prodotto in merito al processo di scansione, e che possono o meno rispettare le regole di robots.txt. Ad esempio, AdSense e AdsBot controllano la qualità degli annunci, mentre Mobile Apps Android controlla le app Android, Googlebot-Image segue le immagini, Googlebot-Video i video e Googlebot-News le notizie. La loro maschera DNS inversa è “rate-limited-proxy-***-***-***-***.google.com” e l’elenco degli intervalli IP si trova nel file special-crawlers.json (ed è diverso da quelli dei crawler comuni).

- Fetcher attivati dall’utente: strumenti e funzioni di prodotto in cui l’utente finale attiva un recupero (fetch), come Google Site Verifier che agisce su richiesta di un utente. Poiché il recupero è stato richiesto da un utente, questi fetcher ignorano le regole di robots.txt. La loro maschera DNS inversa è “***-***-***-***.gae.googleusercontent.com” e l’elenco degli intervalli IP si trova nel file user-triggered-fetchers.json.

Questo specchietto ufficiale ci aiuta a tenere sotto’occhio tutti i possibili visitatori (per lo più desiderati) del nostro sito e delle nostre pagine, suddivisi nelle tre categorie appena descritte.

Le caratteristiche tecniche di Googlebot: uno spider evergreen e super veloce

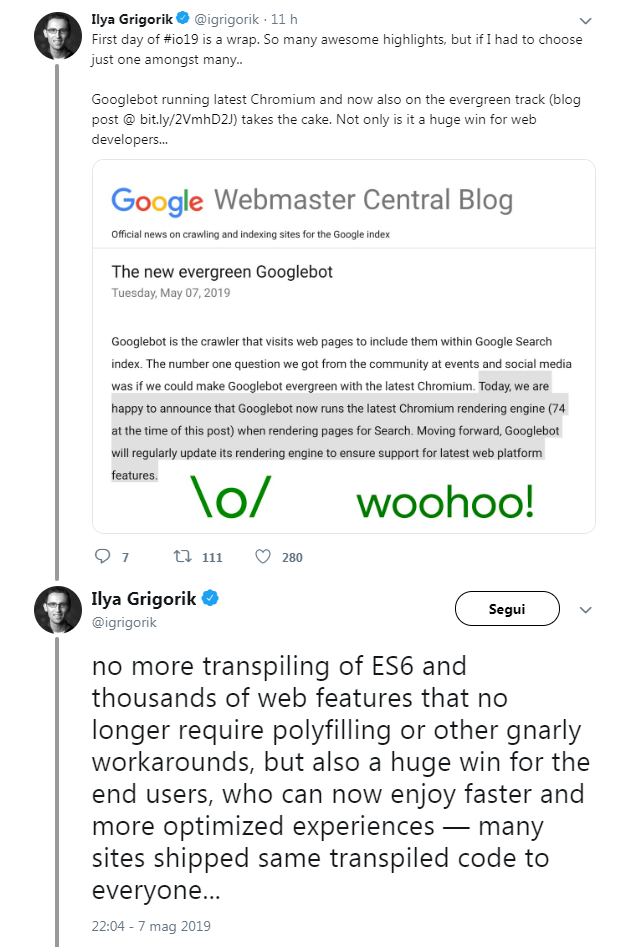

A partire dal maggio 2019 per il crawler di Big G c’è stata una fondamentale novità tecnica: per assicurare il supporto alle più nuove feature delle web platform, infatti, Googlebot è diventato evergreen e in continuo aggiornamento, dotato di un motore capace di gestire costantemente l’ultima versione di Chromium quando esegue il rendering delle pagine Web per la Ricerca.

Secondo Google, questa funzione era la “richiesta numero uno” da parte di partecipanti a eventi e community sui social media rispetto alle implementazioni da apportare al bot, e dunque il team californiano si è concentrato sulla possibilità di rendere GoogleBot sempre aggiornato all’ultima versione di Chromium, portando avanti un lavoro durato anni per intervenire sull’architettura profonda di Chromium, ottimizzare i layer, integrare e far funzionare il rendering per la Search e così via.

In termini concreti, da quel momento Googlebot è diventato capace di supportare oltre mille feature nuove, come in particolare ES6 e nuove funzionalità JavaScript, IntersectionObserver per il lazy-loading e le API Web Components v1. Da Google invitano poi webmaster e sviluppatori a verificare se il sito esegue transpiling o utilizza polyfill in modo specifico per GoogleBot e, in caso affermativo, valutare se sia ancora necessario alla luce del nuovo motore, sottolineando anche che ci sono ancora alcune limitazioni, soprattutto per JavaScript.

In particolare, in questi casi Google necessita ancora di eseguire la scansione e il rendering di JavaScript in due fasi: dapprima GoogleBot scansiona la pagina, poi ripete l’operazione per restituirla graficamente (traduzione letterale di rendering) in modo completo.

Un intervento necessario per modernizzare lo spider e portare vantaggi a sviluppatori e utenti finali

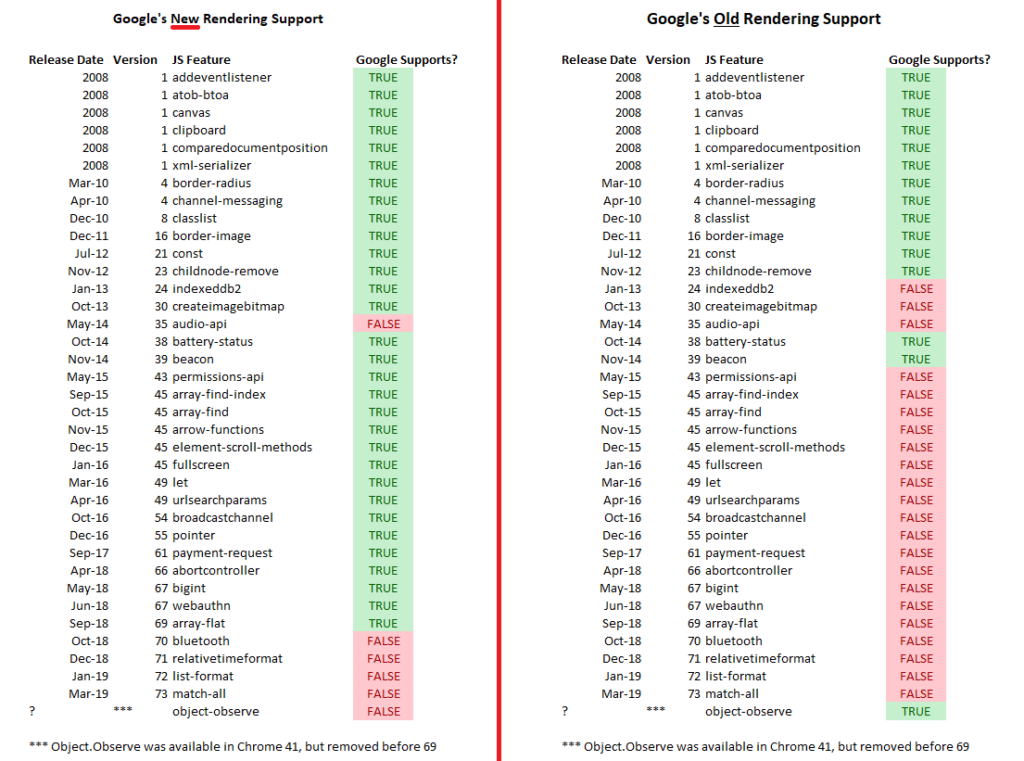

Fino al maggio 2019 GoogleBot era stato volutamente mantenuto obsoleto (per la precisione, il motore era testato su Chrome v41, rilasciato nel 2015) per garantire che indicizzasse le pagine Web compatibili con le versioni precedenti di Chrome. Tuttavia, negli ultimi tempi era divenuto diffuso un disservizio per i siti web costruiti su moderni framework con funzionalità non supportate da Chrome 41, che quindi subivano l’effetto opposto e incontravano difficoltà.

La scelta di rendere evergreen GoogleBot e il suo motore di ricerca risolve questo problema e, allo stesso tempo, rappresenta una notizia positiva per gli utenti finali, che possono ora fruire di esperienze più veloci e maggiormente ottimizzate.

Come ha scritto su twitter Ilya Grigorik, Web performance engineer di Google, non ci saranno più “transpiling di ES6″ o “centinaia di web features che non richiedono più il polyfilling o altre soluzioni alternative” complesse, a vantaggio anche dei tanti siti che hanno inviato lo stesso codice transpiled a tutti.

Come funziona il nuovo motore di Googlebot

Già prima della conferma ufficiale, in realtà, alcuni esperti internazionali e in particolare Alec Bertram di DeepCrawl avevano scoperto che Google stava testando una versione più moderna di GoogleBot con funzionalità presenti in Chrome v69 o successive, anziché su quelle tradizionali di Chrome v41. E proprio Martin Splitt ha confermato il test con un tweet, in cui dice che in Google i test sono frequenti e che a volte sono visibili.

Nello specifico, la novità riguarda il supporto di alcune funzioni JavaScript da parte di GoogleBot, che nella nuova versione è stato esteso di molto rispetto alle precedenti: negli script lanciati da DeepCrawl e mostrati in pagina si possono cogliere le varie differenze tra la versione di Chrome 41 (che, come detto, era quella usata di base al momento) e la versione 69 (una delle più attuali nel maggio 2019).

I comuni problemi con JavaScript

Nell’articolo si spiegano anche alcuni dettagli delle classiche operazioni di web crawling: i motori di ricerca possono prendere (fetch) o scaricare l’HTML di una pagina Web, estrarne il contenuto e utilizzarlo per indicizzare e classificare le pagine. Con l’evoluzione delle attività di web development, gli sviluppatori hanno iniziato a utilizzare JavaScript complessi sul lato client nel browser per rendere le loro pagine più veloci, più leggere e più dinamiche.

Queste funzionalità JavaScript causano problemi alla classica attività di fetch dei crawler: mentre scaricano le funzioni JavaScript, non eseguono altre operazioni e quindi non possono vedere alcun contenuto aggiunto alla pagina con JavaScript.

Per questo motivo, i crawler dei motori di ricerca e GoogleBot si sono adattati a questi cambiamenti, implementando nel crawling una fase di rendering dopo quella di fetch, che essenzialmente carica la pagina sottoposta a scansione in un browser, consente di caricare completamente ed eseguire qualsiasi JavaScript, per poi usare il contenuto trovato nella pagina renderizzata quando indicizza e posiziona un URL.

Cosa significa l’aggiornamento di GoogleBot per i SEO

L’aggiornamento definitivo di GoogleBot ha portato effetti importanti per SEO e sviluppatori, soprattutto dal punto di vista pratico: il fatto che Google riesca a visualizzare pagine Web come un browser moderno dovrebbe dare meno preoccupazioni circa l’interpretazione di risorse di vario tipo, comprese le web app moderne, limitando il ricorso a soluzioni alternative come il rendering dinamico per rendere il contenuto sottoposto a scansione, indicizzazione e posizionamento su Google.

Ranking su Google e Googlebot, qual è il rapporto?

Tornando al video di Splitt (e soprattutto all’accenno al posizionamento), il developer advocate del Google Search Relations team spiega meglio il concetto di Googlebot e ranking, specificando che l’attività di ranking su Google è informata da Googlebot, ma non è parte di Googlebot.

Questo significa dunque che durante la fase di indicizzazione il programma assicura che il contenuto sottoposto a scansione sia utile per il motore di ricerca e il suo algoritmo di posizionamento, che utilizza, come abbiamo detto svariate volte, specifici criteri per classificare le pagine, i famosi 200 fattori di ranking.

Un esempio per capire la relazione: la Ricerca come una biblioteca

Torna quindi utile la già citata similitudine con una biblioteca, in cui il responsabile “deve stabilire quale sia il contenuto dei vari libri per dare le giuste risposte alle persone che li chiedono in prestito. Per farlo, consulta il catalogo di tutti i volumi presenti e legge l’indice dei singoli libri”.

Il catalogo è dunque l’Indice di Google creato attraverso le scansioni di Googlebot, e poi “qualcun altro” usa queste informazioni per prendere decisioni ponderate e presentare agli utenti il contenuto che richiedono (il libro che vogliono leggere, per proseguire nell’analogia fornita).

Quando una persona chiede al bibliotecario “qual è il miglior libro per imparare a fare torte di mele in modo molto veloce”, quest’ultimo deve essere in grado di rispondere adeguatamente studiando gli indici degli argomenti dei vari libri che parlano di cucina, ma sa anche quali sono i più popolari. Quindi, in ambito Web abbiamo l’indice fornito da Googlebot e la “seconda parte”, la classificazione, che si basa su un sistema sofisticato che studia l’interazione tra i contenuti presenti per decidere quali “libri” raccomandare a chi chiede informazioni.

Una spiegazione semplice e non tecnica della scansione

Splitt è tornato successivamente a chiarire l’analogia sul funzionamento di Googlebot e un articolo di SearchEngineLand riporta le sue parole per spiegare in modo non tecnico il processo scansione del crawler di Google.

“Tu stai scrivendo un nuovo libro e il bibliotecario deve concretamente prendere il libro, capire di cosa tratta e anche a cosa si riferisce, se ci sono altri libri che potrebbero essere stati fonte di partenza o potrebbero essere referenziati da questo libro”, ha detto il Googler. Nel suo esempio, il bibliotecario è il web crawler di Google, ovvero Googlebot, mentre il libro è un sito o una pagina Web.

Semplificando, il processo dell’indicizzazione funziona quindi in questo modo: “Devi leggere [il libro], devi capire di cosa si tratta, devi capire come si collega agli altri libri, e poi puoi ordinarlo nel catalogo”. Pertanto, il contenuto della pagina web viene memorizzato nel “catalogo“, che rappresenta fuor di metafora l’indice del motore di ricerca, da dove può essere classificato e pubblicato come risultato per le query pertinenti.

In termini tecnici, ciò significa che Google ha “un elenco di URL e prendiamo ciascuno di questi URL, facciamo loro una richiesta di rete, quindi guardiamo la risposta del server e poi lo renderizziamo (fondamentalmente, lo apriamo in un browser per eseguire JavaScript); quindi guardiamo di nuovo il contenuto e poi lo inseriamo nell’indice a cui appartiene, in modo simile a quello che fa il bibliotecario”.

Quando Googlebot scansiona un sito?

Completata la discussione teorica, nel video si affrontano poi tematiche più tecniche legate al bot di Mountain View, e in particolare Splitt spiega come e quando un sito viene sottoposto a scansione da Googlebot: “Nella prima fase di crawling arriviamo alla tua pagina perché abbiamo trovato un link su un altro sito o perché hai inviato una Sitemap o perché in qualche modo sei stato inserito nel nostro sistema”. Un esempio di questo tipo è usare la Search Console per segnalare il sito a Google, un metodo che dà un suggerimento e uno sprone al bot e lo sprona (hint and trigger).

Quanto spesso Googlebot esegue la scansione

Collegato a questo tema c’è un altro punto importante, la frequenza della scansione: Splitt inizia a dire che il bot prova a capire se tra le risorse già presenti nell’Indice c’è qualcosa che ha bisogno di essere controllato più spesso. Ovvero, il sito offre notizie di attualità che cambiano ogni giorno, è un eCommerce che propone offerte che cambiano ogni 15 giorni, o addirittura ha contenuti che non cambiano perché è il sito di un museo che si aggiorna raramente (magari per mostre temporanee)?

Ciò che fa Googlebot è separare i dati dell’indice in una sezione che viene chiamata “daily or fresh” che viene inizialmente sottoposta a scansione in modo assiduo per poi ridurre la frequenza col tempo. Se Google si accorge che il sito è “super spammy o super broken“, Googlebot potrebbe non scansionare il sito, così come le regole imposte al sito tengono lontano il bot.

Come funziona la scansione di Google

Nel video si aggiunge anche che Googlebot non scansiona semplicemente tutte le pagine di un sito allo stesso momento, sia per limitazioni di risorse interne sia per evitare di sovraccaricare il servizio del sito.

Dunque, Google cerca di capire quanto può spingersi nella scansione, quante risorse proprie ha a disposizione e quanto può stressare il sito, determinando quello che spesso viene definito crawl budget e che spesso è difficile determinare. “Ciò che facciamo – aggiunge Splitt – è lanciare una scansione per un po’, alzare il livello di intensità e quando iniziamo a vedere errori ridurre il carico“.

Il mio sito è visitato da Googlebot?

Questa è la crawler part dello spider di Google, a cui seguono altre attività tecniche più specifiche come il rendering; per i siti, però, può essere importante sapere come capire se un sito è visitato da Googlebot, e Martin Splitt spiega come fare.

Google usa un browser a due fasi (crawling e vero rendering), e in entrambi i momenti presenta ai siti una richiesta con intestazione dell’user agent, che lascia tracce ben visibili nei log referrer. Come si legge nei documenti ufficiali di Mountain View, Google usa una decina di token dello user-agent, responsabili di una parte specifica di crawling (ad esempio, AdsBot-Google-Mobile controlla la qualità dell’annuncio nella pagina web Android).

I siti possono scegliere di offrire ai crawler una versione non completa delle pagine, ma un HTML pre-renderizzato appositamente per facilitare la scansione: è quello che si chiama rendering dinamico, che significa in pratica avere contenuti visualizzati lato client e contenuti pre-visualizzati per specifici user-agent, come si legge nelle guide di Google. Il rendering dinamico o dynamic rendering viene consigliato soprattutto per siti che hanno contenuti generati con JavaScript, che restano di difficile elaborazione per molti crawler, e offre agli user-agent dei contenuti adatti alle proprie capacità, come ad esempio una versione HTML statica della pagina.

L’episodio di SEO Mythbusting prosegue dedicando attenzione a un tema caldo, ovvero la navigazione mobile; nello specifico, Suz Hinton chiede dettagli circa il modo con cui Google analizza e distingue i contenuti di siti mobile e di siti desktop. L’analyst di Big G si sofferma innanzitutto a spiegare cos’è il mobile first index per Google, ovvero il modo in cui “scopriamo i tuoi contenuti utilizzando un user agent mobile e una viewport mobile”, che serve al motore di ricerca per assicurarsi di servire qualcosa di carino (something nice) alle persone che navigano da dispositivo mobile.

Proseguendo nel discorso, Martin Splitt dedica attenzione anche ai correlati concetti di mobile readiness o mobile friendliness: rendere una pagina mobile friendly significa assicurarsi che tutti i contenuti rientrino nell’area viewport, che i “tap targets” siano sufficientemente larghi da evitare errori di pressione, che i contenuti possano essere letti senza dover necessariamente allargare lo schermo e così via.

Tutto questo è un indicatore di qualità per Google, ovvero uno dei 200 fattori di ranking di cui abbiamo fatto cenno prima, anche se alla fine il consiglio che dà l’analyst è di “offrire buoni contenuti per l’utente“, perché è la cosa più importante per un sito.

La guida ufficiale a Googlebot: modalità di accesso e di blocco al sito

Abbiamo detto che nei giorni passati c’è stato un aggiornamento della documentazione ufficiale di Google dedicata a Mountain View, in particolare per la sezione in cui si spiega il funzionamento del crawler e le sue modalità di accesso a un sito.

Innanzitutto, la guida segnala che Googlebot non dovrebbe accedere a gran parte dei siti in media più di una volta ogni pochi secondi, ma che, per possibili ritardi, tale frequenza potrebbe risultare leggermente superiore in brevi periodi.

Googlebot è stato progettato per essere eseguito contemporaneamente da migliaia di macchine per migliorare le prestazioni e seguire il ritmo di crescita del Web. Inoltre, per ridurre l’utilizzo di larghezza di banda Google esegue molti crawler su computer vicini ai siti che potrebbero sottoporre a scansione. Pertanto, i nostri file di log potrebbero indicare visite di google.com da diversi computer, tutte con lo user agent Googlebot: l’obiettivo di Google è comunque eseguire a ogni visita la scansione del maggior numero possibile di pagine del sito senza sovraccaricare la larghezza di banda del server, e se il sito non riesce a stare al passo con le richieste di scansione di Google, possiamo richiedere di cambiare la frequenza di scansione.

In genere Googlebot esegue la scansione su HTTP/1.1. Tuttavia, da novembre 2020, Googlebot potrebbe sottoporre a scansione i siti che potrebbero trarne vantaggio su HTTP/2, se supportato. In questo modo è possibile risparmiare risorse di calcolo (ad esempio CPU, RAM) per il sito e Googlebot, ma non ci sono ripercussioni sull’indicizzazione o il ranking del sito.

Per disattivare la scansione su HTTP/2, dobbiamo indicare al server che ospita il sito di rispondere con un codice di stato HTTP 421 quando Googlebot tenta di eseguire la scansione del sito su HTTP/2; se ciò non è fattibile, possiamo usare una soluzione temporanea e inviare un messaggio al team di Googlebot.

Googlebot può eseguire la scansione dei primi 15 MB dei contenuti in un file HTML o in un file di testo supportato. Dopo questa soglia, Googlebot interrompe la scansione e considera comunque solo i primi 15 MB dei contenuti per l’indicizzazione. Più precisamente, il limite di 15 MB si applica ai recuperi effettuati da Googlebot (Googlebot Smartphone e Googlebot Desktop) durante il fetching dei tipi di file supportati da Ricerca Google; il contenuto successivo viene eliminato da Googlebot e solo i primi 15 MB vengono inoltrati all’indicizzazione.

Questo limite, però, non si applica a risorse tipo immagini o video, perché in questo caso Googlebot recupera video e immagini a cui si fa riferimento nell’HTML con un URL (ad esempio, <img src=”https://example.com/images/puppy.jpg” alt=”cute puppy looking very disappointed” />) separatamente con recuperi consecutivi.

Google e 15 MB: cosa significa il limite

Proprio questo riferimento ai 15 MB, apparso come detto a fine giugno 2022, ha scatenato la reazione della community SEO internazionale, costringendo Gary Illyes a scrivere un ulteriore approfondimento sul blog per chiarire la questione.

Innanzitutto, la soglia dei primi 15 megabyte (MB) che Googlebot “vede” durante il recupero di determinati tipi di file non è nuova, ma “è in circolazione da molti anni” ed è stata aggiunta alla documentazione “perché potrebbe essere utile per alcune persone durante il debug e perché cambia raramente”.

Questo limite si applica solo ai byte (contenuti) ricevuti per la richiesta iniziale effettuata da Googlebot, non alle risorse di riferimento all’interno della pagina. Ciò significa, ad esempio, che se apriamo https://example.com/puppies.html, il nostro browser scaricherà inizialmente i byte del file HTML e, in base a tali byte, potrebbe effettuare ulteriori richieste di JavaScript esterno, immagini o qualsiasi altra cosa a cui fa riferimento un URL nell’HTML; Googlebot fa la stessa cosa.

Per la maggior parte dei siti, il limite di 15 MB significa “molto probabilmente niente” perché ci sono pochissime pagine su Internet di dimensioni maggiori ed “è improbabile che tu, caro lettore, ne sia il proprietario, poiché la dimensione media di un file HTML è circa 500 volte inferiore: 30 kilobyte (kB)”. Tuttavia, dice Gary, “se sei il proprietario di una pagina HTML che supera i 15 MB, forse potresti almeno spostare alcuni script inline e polvere CSS su file esterni, per favore”.

Anche i data URIs contribuiscono alla dimensione del file HTML “poiché sono nel file HTML”.

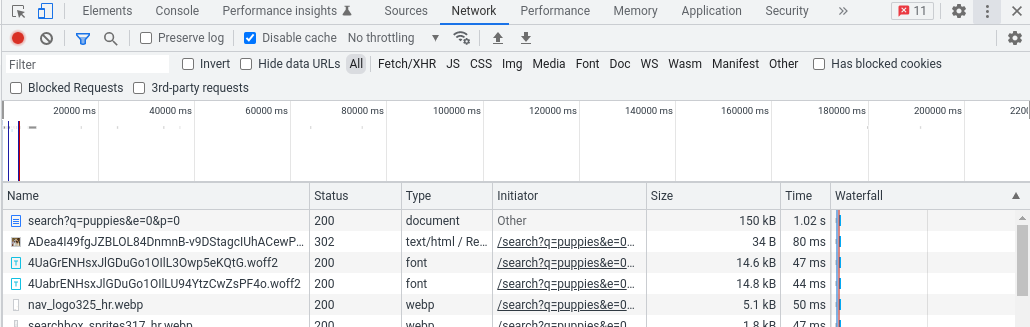

Per cercare le dimensioni di una pagina e capire quindi se superiamo il limite esistono diversi modi, ma “il più semplice è probabilmente utilizzare il browser e i suoi strumenti per sviluppatori”.

In particolare, consiglia Illyes, dobbiamo caricare la pagina come faremmo normalmente, quindi avviare gli Strumenti per sviluppatori e passare alla scheda Rete; ricaricando la pagina dovremmo vedere tutte le richieste che il browser ha dovuto fare per eseguire il rendering della pagina. La richiesta principale è quella che stiamo cercando, con la dimensione in byte della pagina nella colonna Dimensione.

In questo esempio dagli Strumenti per sviluppatori di Chrome la pagina pesa 150 kB, dato mostrato nella colonna delle dimensioni:

Una possibile alternativa per i più avventurosi è utilizzare cURL da una riga di comando, come mostrato di seguito:

curl

-A "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/103.0.0.0 Safari/537.36"

-so /dev/null https://example.com/puppies.html -w '%{size_download}'Come impedire a Googlebot di visitare il sito

In alcuni casi potremmo essere tentati dall’idea di impedire a Googlebot di visitare il sito.

Tuttavia, dice Google, “è quasi impossibile tenere segreto un server web evitando di pubblicare link che vi rimandino”: ad esempio, non appena un utente segue un link che da questo server “segreto” rimanda a un altro server web, l’URL “segreto” potrebbe essere visualizzato nel tag referrer ed essere memorizzato e pubblicato dall’altro server web nel suo log referrer. In modo simile, sul Web esistono molti link obsoleti e inaccessibili. Quando qualcuno pubblica un link sbagliato che rimanda al tuo sito o non aggiorna i link per riflettere i cambiamenti avvenuti nel tuo server, Googlebot prova a eseguire la scansione di un link sbagliato del sito.

In definitiva, c’è comunque una serie di opzioni per impedire a Googlebot di eseguire la scansione dei contenuti del sito – qui ad esempio ci sono tre modi per nascondere un sito a Google, ma non agli utenti – ma Google invita a ricordare “la differenza tra impedire a Googlebot di eseguire la scansione di una pagina, impedire a Googlebot di indicizzare una pagina e impedirne del tutto l’accesso sia ai crawler sia agli utenti”.

Verifica di Google: la lista ufficiale degli IP e la ricerca DNS inversa

Prima di bloccare Googlebot, però, c’è un altro aspetto da non trascurare: la stringa user agent utilizzata da Googlebot è spesso oggetto di spoofing da parte di altri crawler, e quindi è molto importante verificare che una richiesta problematica provenga effettivamente da Google.

Il miglior modo per verificare che una richiesta provenga effettivamente da Googlebot è utilizzare una ricerca DNS inversa nell’IP di origine della richiesta oppure far corrispondere l’IP di origine con gli intervalli di indirizzi IP di Googlebot, che Google ha deciso di rendere pubblici nel mese di novembre 2021 andando incontro alle sollecitazioni della community.