L’elenco degli indirizzi IP di Googlebot per verificare i passaggi dei crawler

È un tema che può preoccupare proprietari di siti, webmaster e SEO: come distinguere i passaggi dei crawler affidabili dagli accessi eseguiti da spammer o altri piantagrane che affermano di essere Googlebot? In aggiunta ai due metodi classici per verificare le scansioni, da qualche tempo Google ha deciso di pubblicare ufficialmente la lista degli indirizzi IP utilizzati da Googlebot per le sue visite, permettendo quindi agli interessati di avere un modo definitivo per verificare che gli accessi dei crawler al sito corrispondano a quelli dichiarati.

La lista degli indirizzi IP di Googlebot

A rivelare questo agognato elenco è la nuova pagina aggiunta alla documentazione ufficiale di Google, in cui si legge che ora è possibile “verificare se un crawler web che accede al server è davvero un crawler di Google, come Googlebot”, così da evitare che eventuali spammer o altri disturbatori accedano al sito affermando di essere Googlebot e facciano danni con le loro scansioni.

Grazie a questo intervento, infatti, ora è possibile “identificare Googlebot in base all’indirizzo IP, abbinando l’indirizzo IP del crawler all’elenco degli indirizzi IP di Googlebot”.

Qual è l’elenco degli indirizzi IP di Googlebot e di Google

Possiamo visualizzare l’elenco completo degli indirizzi IP di Googlebot in un file JSON pubblicato a questo link. C’è da tener presente, però, che Google potrebbe aggiornare questo elenco, e quindi sarebbe utile controllare il file periodicamente.

Possiamo anche scoprire tutti gli altri crawler di Google verificando se l’indirizzo IP riscontrato sul server corrisponde a uno di quelli presenti nell’elenco completo degli indirizzi IP di Google. Anche in questo caso, la lista di indirizzi può variare nel tempo.

Come verificare i crawler di Google

Finora, l’unico modo per eseguire questa operazione era il reverse DNS degli indirizzi che avevano fatto accesso al server, ma ora ci sono due strade a disposizione, come dice ancora la guida Google.

- Metodo manuale: adatto a ricerche una tantum, si basa sull’utilizzo degli strumenti della riga di comando ed è sufficiente per la maggior parte dei casi d’uso.

- Metodo automatico: utile per ricerche su larga scala, utilizza una soluzione automatica per confrontare l’indirizzo IP di un crawler con l’elenco degli indirizzi IP di Googlebot pubblicati.

Il processo manuale

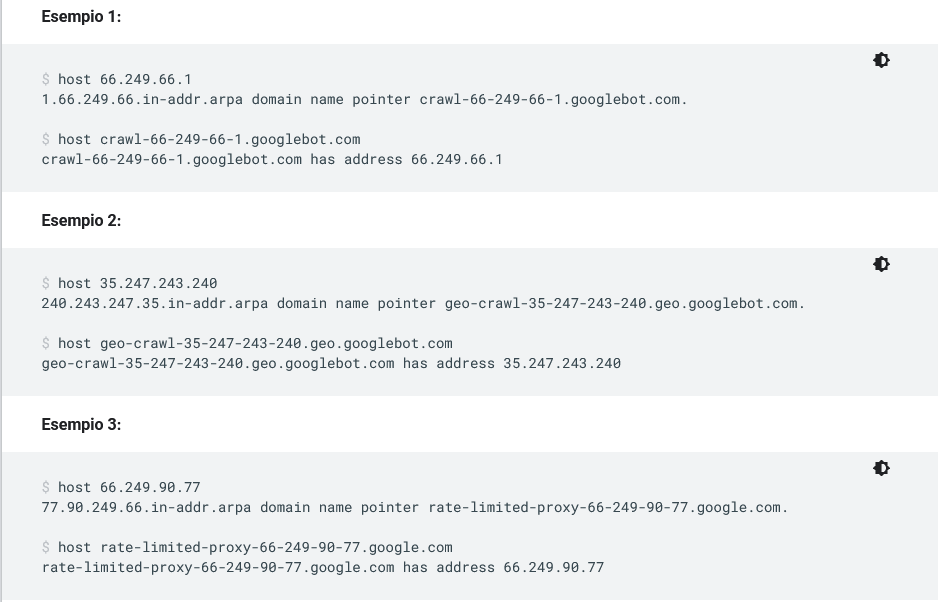

Per eseguire una verifica manuale dobbiamo quindi usare gli strumenti della riga di comando, eseguendo una ricerca DNS inversa sull’indirizzo IP di accesso dai nostri log, utilizzando il comando host.

Il secondo step è controllare che il nome di dominio sia googlebot.com, google.com o googleusercontent.com, a cui fa seguito un Forward DNS lookup sul nome di dominio recuperato nel primo passaggio, usando il comando host sul nome di dominio recuperato. Infine, dobbiamo riscontrare che quello ricavato sia lo stesso dell’indirizzo IP di accesso originale dai nostri log.

Le soluzioni automatiche

A questo metodo classico ora si aggiunge la possibilità di automatizzare il processo e identificare Googlebot tramite l’indirizzo IP, comparando l’indirizzo IP del crawler che ha fatto accesso al sito all’elenco pubblico di indirizzi IP di Googlebot; ciò vale, ovviamente, anche se voglaimo estendere la verifica a tutti gli altri crawler di Google, per cui basterà far riferimento agli altri elenchi specifici (che distinguono gli indirizzi dei crawler speciali da quelli dei fetcher che si attivano su richiesta dell’utente). Inoltre, ricordiamo anche che esistono servizi di terze parti, come Cloudflare e altri software, che aiutano a gestire questi aspetti.

Una nuova opportunità contro accessi indesiderati

È dal 2007 che Google ha introdotto per i SEO e i proprietari di siti il meccanismo di controllo inverso del DNS per verificare che il sedicente crawler Googlebot sia effettivamente chi dice di essere. Ora ha deciso di pubblicare l’elenco di indirizzi IP che Googlebot utilizza per eseguire la scansione di ogni sito, che amplia quindi le opportunità per monitorare lo stato delle scansioni.

Può infatti capitare che i siti siano rallentati e potenzialmente persino andare offline a causa di falsi bot che eseguono la scansione e lo spidering del sito, e chiaramente nessuno (a parte casi eccezionali) ha interesse nell’impedire al vero Google di eseguire la scansione del sito, perché ciò può portare a problemi di indicizzazione e posizionamento nella Ricerca Google.

In parole pratiche, quindi, questo elenco può aiutarci a sapere con certezza quale bot è veramente di Google e quale no, e quindi rendere più semplice individuare quali sono gli eventuali bot ingannevoli che dobbiamo bloccare.