A Google I/O 2022 le ultime novità sul sistema Search (e sulla SEO)

Tanti, tantissimi annunci legati agli smisurati campi in cui si fa sentire la presenza di Big G – il famoso ecosistema Google, che copre praticamente ogni aspetto della vita, digitale e non, come possiamo vedere in questa lista di 100 cose annunciate! – ma nulla di particolarmente sorprendente o rivoluzionario per il sistema Search e quindi per la SEO. Calato il sipario su Google I/O 2022 possiamo fare una panoramica sull’evento di quest’anno e sulle possibili novità che arriveranno sul motore di ricerca, così eventualmente da prepararci e preparare i nostri progetti per intercettarle.

Google I/O 2022, il discorso di Sundar Pichai

Forse era impossibile che per il motore di ricerca ci fosse già una ulteriore rivoluzione dopo quella anticipata a Google I/O 2021, quando la rivelazione di Google MUM e delle applicazioni dei sistemi di intelligenza artificiale (anche) al sistema Search aveva attirato tutti i riflettori sul più famoso prodotto di Big G, ma probabilmente nessuno si aspettava così poca presenza effettiva della Ricerca all’interno della manifestazione dedicata a webmaster e sviluppatori web che rappresenta una vera e propria vetrina per l’azienda californiana (e che deve il suo nome deriva alle iniziali di Input e output).

Ad ogni modo, non sono mancati spunti di interesse all’interno di Google I/O 2022, che riguardano (ancora) le applicazioni della tecnologia alla Ricerca per riuscire a garantire quella che, come conferma il CEO di Google e Alphabet Sundar Pichai, resta la mission fondamentale di Google, oggi come circa 24 anni fa: “organizzare le informazioni del mondo e renderle universalmente accessibili e utili”.

Informazioni e conoscenza al centro del processo

La tecnologia sta svolgendo un ruolo centrale nell’accompagnare Mountain View verso il raggiungimento di questo obiettivo e “i progressi che abbiamo fatto sono dovuti ai nostri anni di investimenti in tecnologie avanzate, dall’IA all’infrastruttura tecnica che alimenta tutto”, dice Pichai nel suo discorso introduttivo.

Sono due i modi chiave in cui l’azienda porta avanti “questa missione: approfondendo la nostra comprensione delle informazioni, in modo da poterle trasformare in conoscenza, e migliorare lo stato dell’informatica, in modo che la conoscenza sia più facile da accedere, non importa chi sei o dove ti trovi”.

Pichai passa poi a raccontare alcune dei più recenti traguardi del motore di ricerca, che “durante la pandemia, si è concentrato tra l’altro sulla fornitura di informazioni accurate per aiutare le persone a rimanere in salute” (e nell’ultimo anno, le persone hanno utilizzato quasi due miliardi di volte Ricerca Google e Maps per trovare un luogo dove potevano ottenere un vaccino contro il COVID), ha ampliato la “tecnologia di previsione delle inondazioni per aiutare le persone a rimanere al sicuro di fronte ai disastri naturali” (e durante la stagione dei monsoni dello scorso anno, questi avvisi di inondazione hanno allertato più di 23 milioni di persone in India e Bangladesh, supportando l’evacuazione tempestiva di centinaia di migliaia di persone), ha collaborato con il governo in Ucraina “per dispiegare rapidamente allarmi antiaerei” (inviando centinaia di milioni di avvisi per aiutare le persone a mettersi in salvo).

Cosa è in arrivo per Search

Pichai ha anche rapidamente presentato alcune delle funzioni innovative e degli upgrade che sono in arrivo su Google Search a livello globale; in particolare, il CEO della compagnia ha citato l’aggiunta di altre 24 lingue a Google Translate (il sistema di traduzione in tempo reale che “è una testimonianza di come la conoscenza e l’informatica si uniscono per migliorare la vita delle persone”) e i costanti miglioramenti alle IA conversazionali.

Si tratta della versione 2.0 di Google LaMDA, il modello di linguaggio generativo per applicazioni di dialogo in grado di conversare su qualsiasi argomento, che diventa così “la nostra IA conversazionale più avanzata di sempre”.

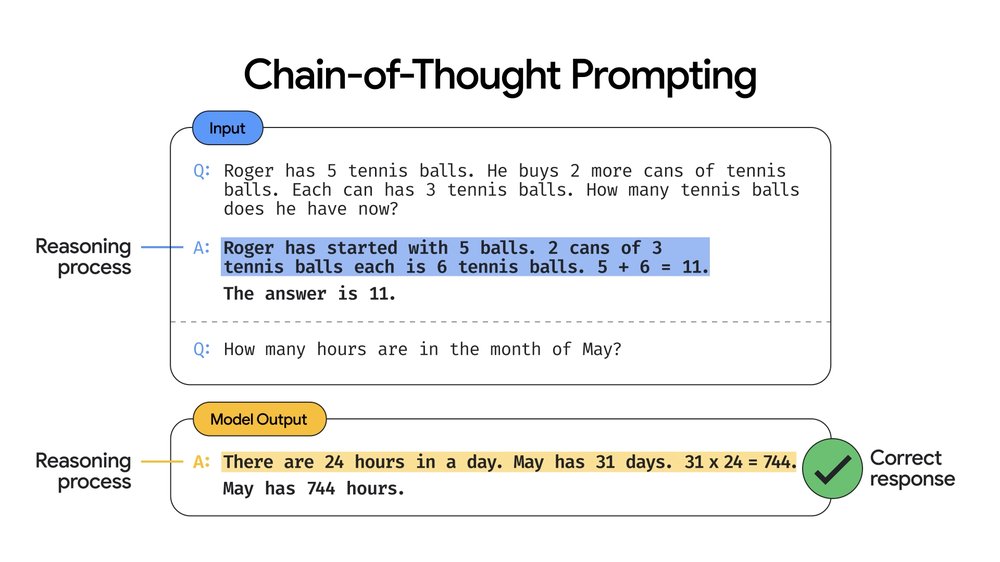

Ad affiancare LaMDA 2 c’è ora anche Pathways Language Model, o in breve PaLM, un nuovo modello tecnologico pensato per esplorare altri aspetti dell’elaborazione del linguaggio naturale e dell’IA: si tratta del modello Google più grande fino ad oggi, addestrato su 540 miliardi di parametri, che stando a Pichai “dimostra prestazioni rivoluzionarie su molte attività di elaborazione del linguaggio naturale, come la generazione di codice dal testo, la risposta a un problema di parole matematiche o persino la spiegazione di una barzelletta” grazie a una tecnica chiamata suggerimento della catena di pensiero o chain-of-thought prompting, che consente di descrivere i problemi a più fasi, come una serie di passaggi intermedi, e aumentare di un ampio margine la precisione della risposta.

In ultimo (limitandoci sempre alle applicazioni su Search e ai possibili effetti sulla SEO), il CEO di Google anticipa l’utilizzo sempre più intenso della Realtà Aumentata anche attraverso l’app di Google Lens che, secondo i dati rivelati nel corso dell’evento, è ormai usata più di 8 miliardi di volte al mese in tutto il mondo, valore praticamente triplo rispetto a quello dello scorso anno.

Multisearch, il nuovo sistema per ricerche intorno a noi

Ed è proprio tramite Lens che funziona Multisearch, che forse è l’annuncio più importante per il segmento Search che è arrivato a Google I/O 2022 (anche se, in realtà, il sistema è stato presentato già nelle scorse settimane e nella manifestazione si è parlato di un ulteriore update).

Multisearch è una funzione speciale di ricerca che, tramite l’uso dell’app Lens e della fotocamera dello smartphone, consente di eseguire ricerche partendo dall’immagine inquadrata aggiungendo però una query di testo aggiuntiva per perfezionare la ricerca. Google utilizzerà quindi sia l’immagine che la query testuale per mostrare i risultati della ricerca visiva.

Con Multisearch Near Me c’è uno step in più: sarà possibile fare uno zoom in di quelle query di immagini e testo alla ricerca di prodotti o altro tramite la fotocamera, oppure di risultati locali – ad esempio, per trovare un ristorante che proponga un piatto specifico.

In ottica SEO, questa feature rappresenta un nuovo modo con cui gli utenti/consumatori possono entrare in contatto con i nostri contenuti: oltre ai classici risultati di ricerca desktop, alle ricerche mobile, a quelle vocali, alla ricerca immagini ora dobbiamo “preoccuparci” anche della multiricerca, che ci conferma anche che già da ora le risorse di tipo visual sono centrali per intercettare le persone e per spingerle verso il clic – e questo ora è ancora più importante per le imprese locali.

Ricerche integrate di immagini e testo anche per ricerche locali

Secondo Prabhakar Raghavan, Senior Vice President della compagnia, con Multisearch “stiamo ridefinendo ancora una volta la Ricerca Google, combinando la nostra comprensione di tutti i tipi di informazioni (di testo, vocali, visive e altro), in modo che tu possa trovare informazioni utili su tutto ciò che vedi, ascolti e sperimenti, nei modi più intuitivi”.

Raghavan descrive brevemente le possibili applicazioni di questo sistema che, nella versione Near Me, sarà disponibile a livello globale entro la fine dell’anno in inglese e nel tempo si espanderà a più lingue: “Puoi utilizzare un’immagine o uno screenshot e aggiungere ‘vicino a me’ per vedere le opzioni di ristoranti o rivenditori locali che hanno l’abbigliamento, i prodotti per la casa e il cibo che stai cercando”. Ad esempio, prosegue, “supponi di vedere online un piatto colorato che vorresti provare, ma non sai cosa contiene o come si chiama: quando utilizzi la Multisearch per trovarlo vicino a te, Google esegue la scansione di milioni di immagini e recensioni pubblicate su pagine Web e dalla nostra community di collaboratori di Maps per trovare risultati sui luoghi nelle vicinanze che offrono il piatto in modo che tu possa godertelo tu stesso”.

E presto ci sarà un ulteriore aggiornamento, chiamato “scene exploration” che permette di migliorare la ricerca visiva con Google riconoscendo non più solo gli oggetti catturati in un unico fotogramma ma, appunto, l’intera scena. Grazie all’uso della ricerca multipla Multisearch potremo eseguire una panoramica tramite la videocamera dello smartphone e ottenere istantaneamente informazioni su più oggetti presenti in questa scena ampia.

Questa esplorazione delle scene “è un potente passo avanti nella capacità dei nostri dispositivi di comprendere il mondo nel modo in cui lo facciamo noi” e permetterà alle persone di “trovare facilmente ciò che stanno cercando”, conclude il Senior Vice President di Google.

Le applicazioni annunciate per Search (e per la SEO)

Passando a questioni più pratiche, vediamo quali sono le novità che interessano direttamente il motore di ricerca più usato al mondo.

Il primo annuncio riguarda il delicato tema della privacy: Google sta per introdurre nella Ricerca uno strumento specifico per gestire la propria presenza online e aiutare ogni persona a controllare facilmente “se le tue informazioni di identificazione personale possono essere trovate nei risultati di ricerca, così puoi stare più tranquillo sulla tua fingerprint online”, chiarisce Danielle Romain, VP Trust. Questo tool si rende necessario perché “per molte persone, un elemento chiave per sentirsi più sicure e private online è avere un maggiore controllo su dove possono essere trovate le loro informazioni sensibili e di identificazione personale”.

Questo tool renderà ancora più semplice il processo di rimozione dei risultati di Google che contengono informazioni personali di contatto (come ad esempio numero di telefono, indirizzo di casa o indirizzo email), e sarà disponibile nell’app Google o cliccando sui tre punti accanto ai singoli risultati di Ricerca Google. Quando Google riceve la segnalazione con richiesta di rimozione, valuterà tutti i contenuti della pagina web per verificare la fondatezza del caso e non limitare la disponibilità di altre informazioni ampiamente utili (ad esempio negli articoli di notizie) e “naturalmente, la rimozione delle informazioni di contatto da Ricerca Google non le rimuove dal Web, motivo per cui potrebbe essere utile contattare direttamente il sito di hosting, se ti senti a tuo agio nel farlo”, suggerisce Romain.

“Un’altra parte importante della sicurezza online è la fiducia nelle informazioni che trovi”, dice invece Nidhi Hebbar, Product Manager a Google, nel presentare un ulteriore upgrade della funzione About This Result: lanciato a febbraio 2021, questo strumento è disponibile in inglese sui singoli risultati di ricerca e serve ad aiutare gli utenti a scoprire il contesto generale di un sito web prima ancora di visitarlo.

In attesa dell’estensione ad altre lingue – che dovrebbe arrivare entro la fine dell’anno, dice Hebbar – la funzione è stata utilizzata più di 1,6 miliardi di volte e ora sbarca anche in altri ambienti dell’ecosistema. In particolare, quando l’utente visualizza una pagina web sull’app Google, con un semplice tocco potrà vedere una scheda con informazioni sulla fonte, inclusa una breve descrizione, cosa dice il sito di se stesso e quali sono le opinioni di altri sul Web, così da permettere a ogni persona di disporre “degli strumenti per valutare le informazioni ovunque sia online, non solo nella pagina dei risultati di ricerca”.

In pratica, come mostra la gif, con questo aggiornamento potremo trovare un contesto utile su una fonte anche se siamo già sul sito web e su qualsiasi sito Web.

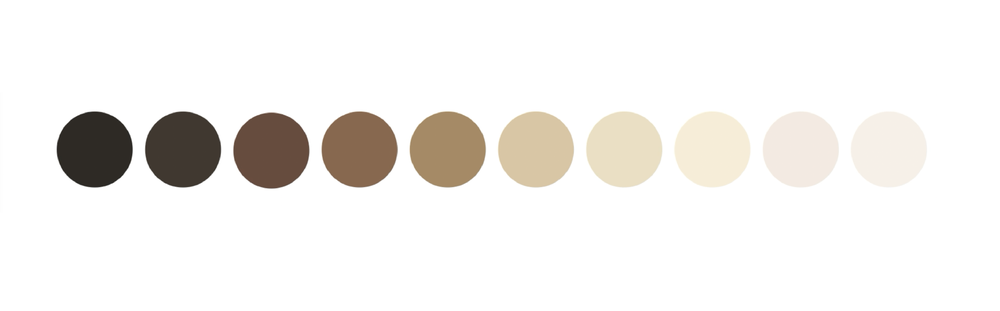

Interessa anche Search la nuova scala dei toni della pelle, studiata insieme al dottor Ellis Monk (professore e sociologo di Harvard) per renderla più inclusiva dello spettro effettivo dei toni di colorazione della pelle che vediamo nella nostra società. Il nuovo strumento si chiama Monk Skin Tone Scale ed è appunto una scala a 10 tonalità che sarà incorporata in vari prodotti Google nei prossimi mesi, con l’obiettivo di aiutare Big G “e l’industria tecnologica in generale a creare set di dati più rappresentativi in modo da poter addestrare e valutare i modelli di intelligenza artificiale per l’equità, risultando in funzionalità e prodotti che funzionano meglio per tutti, di tutte le tonalità della pelle”, come spiega Tulsee Doshi, Head of Product Responsible AI.

In particolare, la scala sarà usata da Google per valutare e migliorare i modelli che rilevano i volti nelle immagini, ma anche per “facilitare per le persone di ogni estrazione trovare risultati più pertinenti e utili” nella Ricerca e per migliorare Google Foto (con dei filtri appositi progettati per funzionare bene su tutti i toni della pelle e valutati utilizzando la scala MST).

Chiudiamo poi con un annuncio di natura ancor più funzionale: a breve, nella sezione Copertura (Index) di Google Search Console sarà presente il video page indexing report (letteralmente rapporto sull’indicizzazione delle pagine video), che mostrerà un riepilogo di tutte le pagine video trovate da Google durante la scansione e l’indicizzazione del sito web, con le classiche informazioni relative allo stato delle pagine e alla presenza di eventuali errori.