AI Generativa: chi risponde meglio tra ChatGPT e Claude?

La notizia ha generato molto scalpore: lo scorso 27 marzo 2024, per la prima volta ChatGPT-4 ha perso lo scettro della classifica di Chatbot Arena, superato dal dirompente modello Claude 3. E visto che non si può fare a meno di parlare di Intelligenza Artificiale Generativa e delle sue applicazioni, abbiamo pensato di testare un po’ meglio questi sistemi per vedere come funzionano davvero e che tipo di risposte forniscono per chi vuole sfruttarne le applicazioni in ambito SEO e non solo. Ecco quindi cosa è emerso da un rapido e assolutamente non-scientifico confronto tra ChatGPT-4, Claude e Gemini.

Perché il confronto tra modelli di AI Generativa

Dovremmo avere ormai sufficiente familiarità con l’Intelligenza Artificiale, che da oltre 16 mesi è praticamente al centro di ogni discussione (e previsione) sulle tematiche digital. In effetti, sappiamo come usare l’AI per creare testi e forse abbiamo anche la padronanza sufficiente degli strumenti per sfruttarla per vari compiti SEO, e in generale l’AI sta rivoluzionando il modo in cui interagiamo con le macchine e come queste possono assistere nella creazione di contenuti.

Modelli linguistici di grandi dimensioni (LLM) come ChatGPT, Gemini e Claude rappresentano la frontiera di questa innovazione, offrendo capacità sempre più sofisticate di generazione del linguaggio naturale. Progettati per comprendere e generare testo in modo che sia indistinguibile da quello scritto da un essere umano, questi modelli aprono nuove possibilità in campi che vanno dal customer service alla produzione di contenuti creativi.

Eppure, è davvero tutto “oro ciò che luccica”? Davvero questi sistemi sono praticamente perfetti e rispondono in modo inappuntabile alle sollecitazioni e alle istruzioni?

Alla luce di questi dubbi abbiamo lanciato un confronto tra ChatGPT, Gemini e Claude, utile per comprendere le sfumature e le potenzialità di ogni piattaforma. Dato che ciascuno di questi strumenti è stato sviluppato con approcci e obiettivi leggermente diversi, è importante valutare le loro prestazioni in scenari reali per identificare quale si adatti meglio a specifiche esigenze e contesti.

Le caratteristiche di questi modelli di AI Generativa

Giusto come reminder, è opportuno aprire una parentesi per ripetere che le AI generative sono sistemi basati su algoritmi di apprendimento automatico, in particolare reti neurali, che vengono addestrati su vasti dataset e sviluppano la capacità di generare nuovi contenuti, che possono variare da testo a immagini, suoni e oltre. Nel contesto del linguaggio naturale, queste AI sono addestrate per comprendere e produrre testo in modo coerente e pertinente.

Andando nello specifico:

- ChatGPTè un modello di linguaggio sviluppato da OpenAI basato sull’architettura Transformer. È il sistema più noto e diffuso presso il grande pubblico (è stato tra i primi a essere rilasciato pubblicamente) e si fa apprezzare per la sua capacità di generare testi fluidi e coerenti e per la sua versatilità in vari compiti di elaborazione del linguaggio naturale. Oggi è arrivato alla versione GPT-4, ma è stata già annunciata la lavorazione della generazione successiva.

- Geminiè stato creato da Google AI e si distingue per la vastità di conoscenze e la capacità di fornire risposte informative e complete a domande aperte, complesse o strane. È in grado di attingere alle informazioni del mondo reale tramite Ricerca Google e mantenere la sua risposta coerente con i risultati di ricerca.

- Claudeè un altro modello di linguaggio, sviluppato da Anthropic, che brilla per la sua capacità di ragionamento e codifica. Si dimostra particolarmente efficace nel risolvere problemi matematici, seguire istruzioni dettagliate e scrivere diversi tipi di formati di testo creativi.

Se di ChatGPT e Gemini si conoscono già tante cose, un po’ meno famoso è (per ora) Claude, prodotto da Anthropic PBC, una startup americana fondata da ex membri di OpenAI. La versione attuale si chiama Claude 3, è stata rilasciata (negli Stati Uniti) il 4 marzo 2024 ed è disponibile in tre modelli linguistici diversi – Haiku, Sonnet e Opus – che, come la forma letterale che ne ispira il nome, si differenziano per le “dimensioni”. Haiku è il modello più piccolo e più veloce; Sonnet alimenta il chatbot Claude.ai ed è un sistema un po’ più avanzato, che rivela evidenti affinità con ChatGPT-4; Opus infine è il modello più ampio, disponibile solo per gli utenti Pro, capace di gestire compiti complessi che richiedono una certa potenza di elaborazione.

Claude sorpassa ChatGPT-4: la battaglia nella Chatbot Arena

Come dicevamo in apertura, qualche settimana fa c’è stato un avvenimento “storico” nella LMSYS Chatbot Arena, ovvero il ring virtuale in cui si sfidano i modelli di chatbot per fornire una sorta di benchmarking per modelli di intelligenza artificiale, basato su voti umani, con le persone che classificano alla cieca l’output di due modelli diversi sullo stesso prompt.

Il 27 marzo, Claude 3 Opus ha spodestato GPT-4 di OpenAI (per la precisione, GPT-4-1106-preview) dal primo posto assoluto, conquistando un Arena Elo ranking di 1253 contro i 1248 del competitor. Il fatto ha destato scalpore perché da quando GPT-4 è stato incluso nella Chatbot Arena, ovvero intorno al 10 Maggio 2023, è sempre stato in cima alla classifica: questa prima sconfitta che rappresenta un momento storico per i modelli linguistici.

Volendo diminuire un po’ l’enfasi sull’avvenimento, è opportuno chiarire che nell’Arena si valutano solo i giudizi soggettivi degli utenti, che in pratica devono cliccare su un pulsante per decidere da soli quale LLM funziona meglio, in base alle metriche a cui tengono e alle “sensazioni” che le risposte offrono. E inoltre, fattore ancor più rilevanti, Claude 3 è “fresco” di un mese mentre ChatGPT-4 è stato lanciato praticamente un anno fa e quindi è impressionante che abbia resistito così a lungo – e in effetti ora l’attenzione è tutta rivolta al momento in cui OpenAI lancerà GPT-5, che dovrebbe segnare un nuovo standard.

Ad ogni modo, la notizia ci ha incuriosito e ci ha convinto a testare anche Claude, per confrontare le sue risposte con quelle di altri modelli che abbiamo già usato da un po’.

Come abbiamo fatto il confronto tra AI

Siamo ancora nella fase delle premesse e delle “avvertenze”. Abbiamo messo a confronto ChatGPT-4 e Claude 3 Opus-3 (entrambi con “temperatura” 0.2) attraverso le API disponibili, coinvolgendo in questa analisi anche Gemini Google in versione free.

Abbiamo identificato una serie di prompt generali e più specifici per testare le risposte dei chatbot, andando a verificare le loro capacità di generazione di contenuti a livello “superficiale”. Non è stato un confronto “scientifico” e analitico al 100%, ma è comunque un test utile per capire come rispondono queste AI e quale può fornire la soluzione alle nostre esigenze.

Oltre alle domande più generiche per saggiare la qualità degli output, abbiamo provato anche a “provocare” le AI su alcuni temi critici e, soprattutto, le abbiamo rapidamente interrogate su attività che interessano la nostra sfera professionale, utilizzando a tal proposito i prompt suggeriti da Pamela Gacioppo nel suo webinar su “come usare ChatGPT per la SEO“.

Cosa abbiamo testato: i criteri per la qualità delle risposte

La nostra veloce analisi comparativa ha quindi sollecitato tre modelli avanzati di intelligenza artificiale generativa – ChatGPT, Gemini e Claude – per palesare le peculiarità, le forze e le potenziali debolezze di ciascuno.

In totale abbiamo lanciato 15 prompt che ci sono sembrati utili per un’attenta osservazione e valutazione delle loro prestazioni, delle capacità e delle caratteristiche distintive di ogni modello.

In particolare, ci siamo concentrati sulla attinenza alle istruzioni, ossia su quanto fedelmente ogni AI segue le direttive impartite attraverso i prompt, e possiamo già anticipare che, in linea di massima, tutti e tre i modelli sono abbastanza efficaci da questo punto di vista.

Proseguendo, abbiamo esaminato l’affidabilità delle informazioni fornite, un fattore di vitale importanza in un’era dove la veridicità dei dati è spesso sotto scrutinio, e che ha fatto emergere qualche criticità maggiore. La qualità del linguaggio è un altro punto focale, dove valutiamo la fluidità, la naturalezza e la chiarezza del testo generato, elementi che contribuiscono all’esperienza complessiva dell’utente – e anche questa skill sembra ormai in pieno possesso delle AI, a parte qualche eccezione “estemporanea”.

La creatività è un criterio che ci permette di sondare la capacità di ciascun modello di produrre idee e contenuti originali, che serve per rendere questo strumento un partner collaborativo nella generazione di spunti professionali. L’aggiornamento delle informazioni è altrettanto fondamentale, e ovviamente è anche il nodo più complesso al momento, come dimostrano le risposte su una notizia di stretta attualità.

En passant, abbiamo anche avuto modo di stuzzicare alcune risposte che fanno riferimento alla questione dell’etica e del bias, verificando sia il modo in cui le AI sono addestrate per evitare risposte inappropriate o offensive e di minimizzare i pregiudizi, sia le loro “valutazioni” in merito.

Ribadiamo che il confronto non aveva una pretesa scientifica né si propone di eleggere la migliore Intelligenza Artificiale del mercato. Abbiamo pensato che potesse essere utile testare sul campo e raccontare come si comportano questi modelli avanzati alle prese con compiti quotidiani e piuttosto basic, in modo da dare insight che speriamo preziosi per orientare le scelte di chi vuole integrare questi strumenti nella sua “cassetta degli attrezzi”.

Qui di seguito presentiamo quindi gli screen delle risposte dei tre modelli di AI allo stesso prompt (che, per comodità, sarà riportato anche in forma testuale), con alcune considerazioni sulla natura e sulla qualità della risposta.

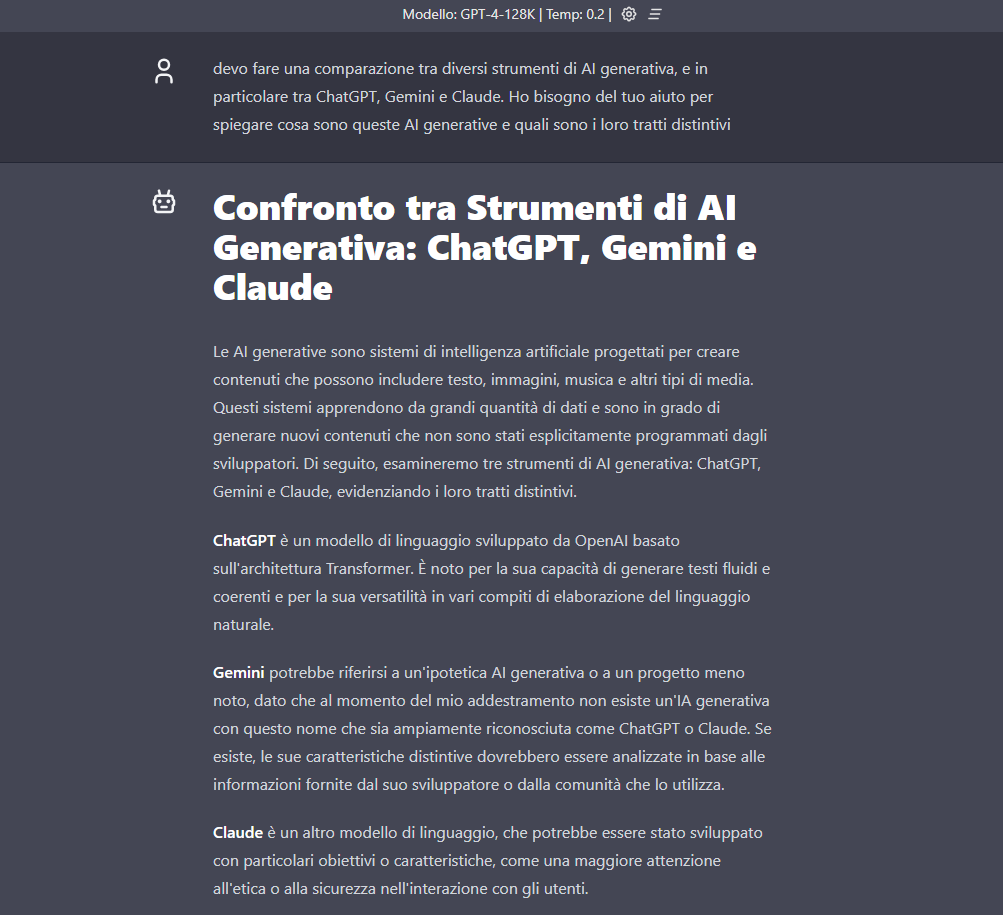

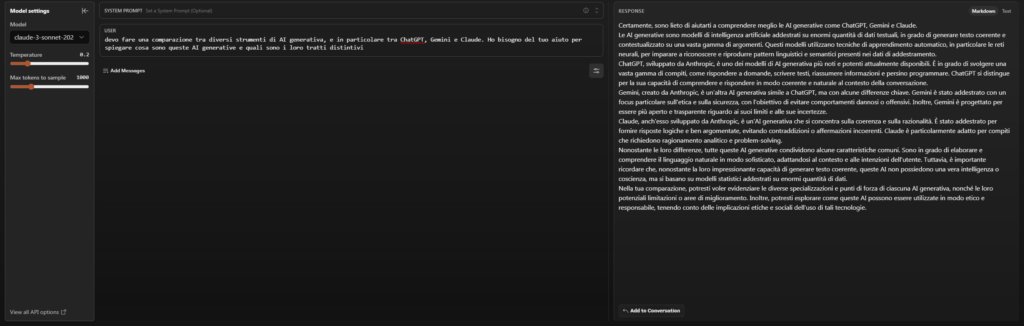

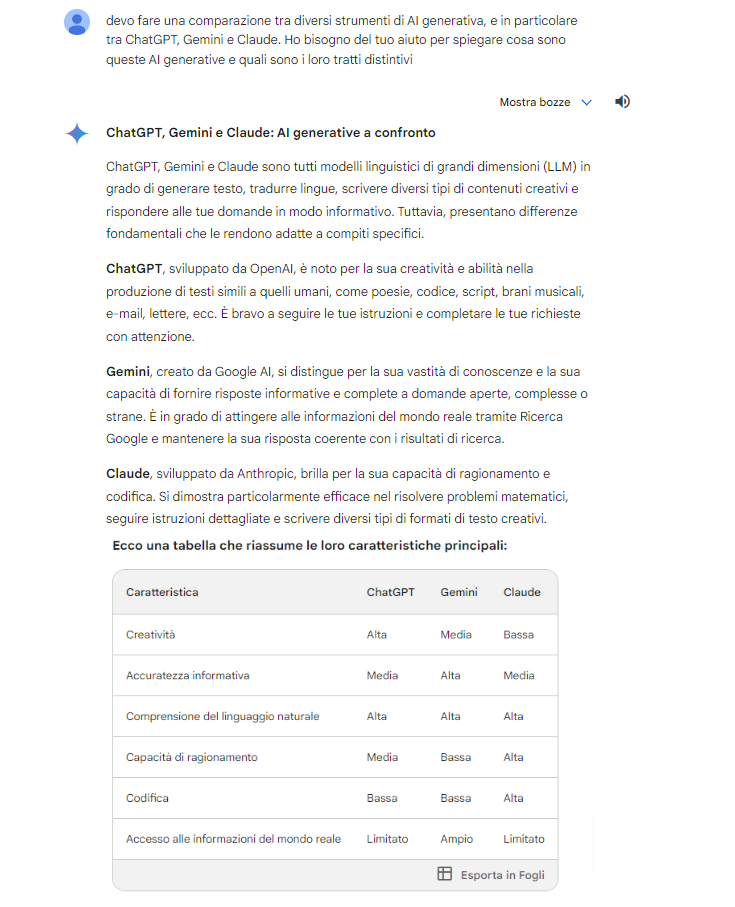

- Devo fare una comparazione tra diversi strumenti di AI generativa, e in particolare tra ChatGPT, Gemini e Claude. Ho bisogno del tuo aiuto per spiegare cosa sono queste AI generative e quali sono i loro tratti distintivi.

Si intravedono i limiti temporali del database di addestramento dei sistemi AI.

ChatGPT centra subito il tema e risponde in modo appropriato, ma non ha informazioni sufficienti su Gemini e su Claude (ma almeno “conosce se stesso”, possiamo dire).

Claude fallisce nell’attribuzione della creazione delle AI concorrenti (e curiosamente indica sempre Anthropic come società sviluppatrice).

Gemini fornisce la risposta più completa e precisa, aggiungendo anche una tabella riassuntiva per mostrare visivamente il confronto.

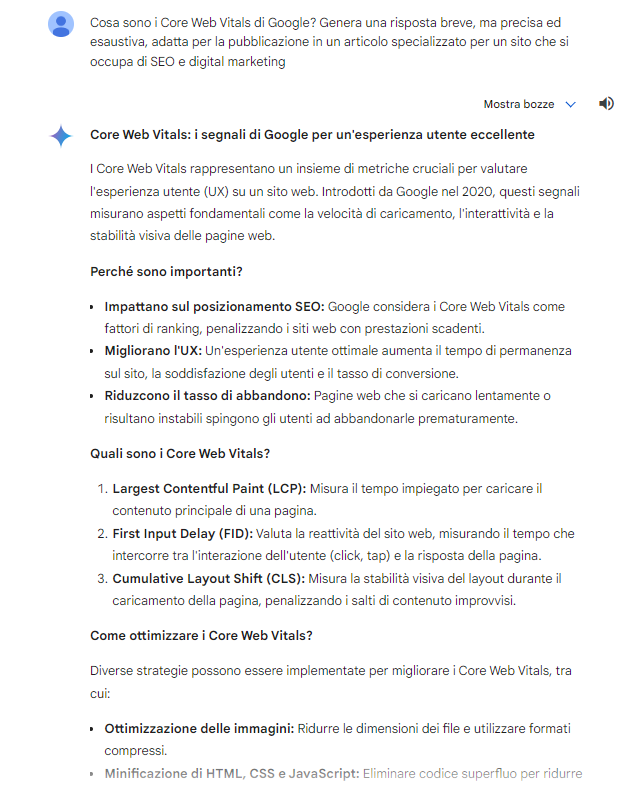

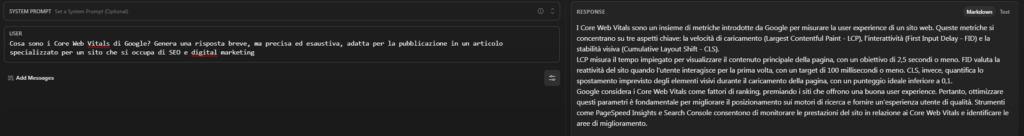

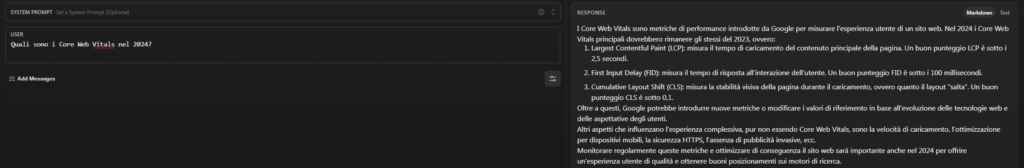

- Cosa sono i Core Web Vitals di Google? Genera una risposta breve, ma precisa ed esaustiva, adatta per la pubblicazione in un articolo specializzato per un sito che si occupa di SEO e digital marketing.

Sulla scia della risposta precedente, anche qui vediamo i limiti temporali che generano alcune imprecisioni, a cominciare ovviamente dalla mancata “sostituzione” tra FID e INP, che come sappiamo è entrato ufficialmente a far parte dei Core Web Vitals dallo scorso mese di marzo 2024.

ChatGPT presenta un testo strutturato abbastanza bene, con informazioni utili e scritte in forma adeguata.

Gemini va oltre, suddividendo la risposta in paragrafi e adottando un approccio del tipo domanda-risposta che è un po’ la sua caratteristica (così come peculiare è l’utilizzo di elenchi puntati o numerati nelle sue risposte).

Claude offre una risposta abbastanza puntuale e aderente al prompt.

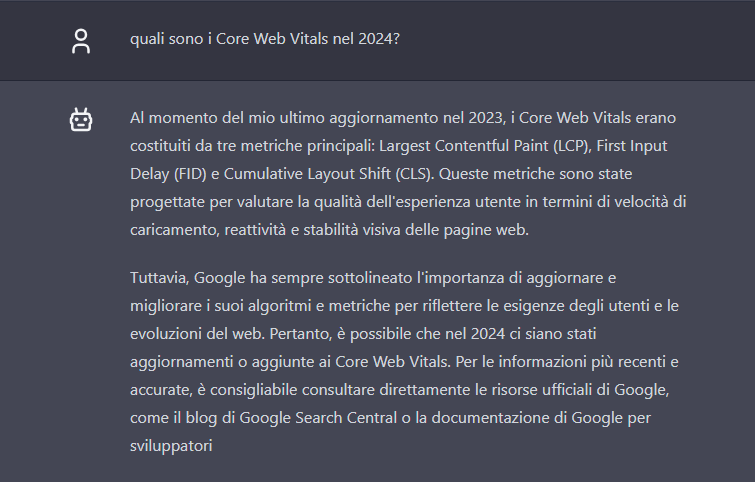

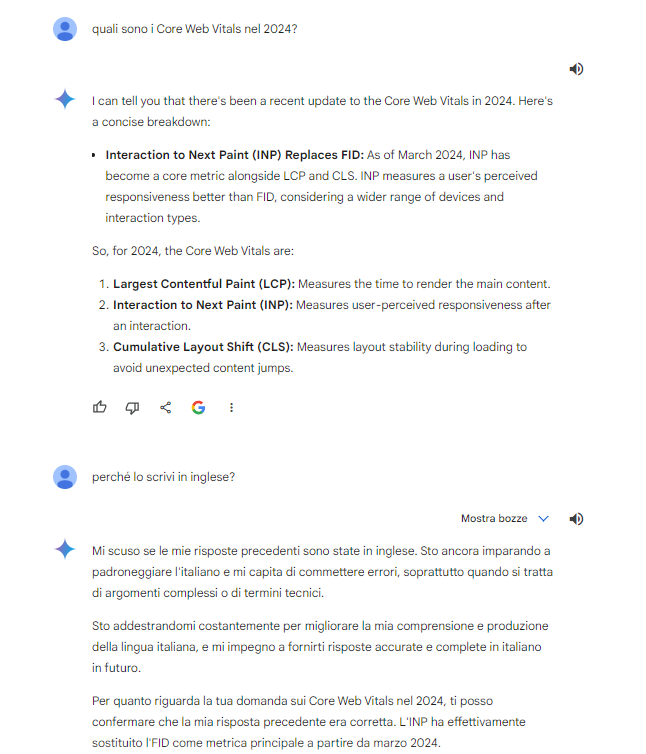

- Quali sono i Core Web Vitals nel 2024?

Dando seguito alla risposta precedente, abbiamo chiesto “lumi” alle AI sul mancato riferimento a INP. Non è una questione di poco conto, anche dal punto di vista temporale: INP è stato introdotto in via sperimentale nel maggio 2022 e poi nel maggio 2023 Google ne ha anticipato l’ingresso nei CWV, quindi questa informazione poteva essere recuperata nei database delle AI.

E invece, ChatGPT ammette di non conoscere l’evoluzione dei CWV, anche se appunto commette un errore dicendo che al 2023 non ci fossero notizie in merito.

Gemini si corregge e cita correttamente INP come nuova metrica ufficiale (ma inizialmente risponde in inglese, senza apparenti ragioni).

Claude si limita a ripetere le informazioni precedenti “datandole” al 2024 e “presumendo” che non ci sono stati cambiamenti rispetto al 2023 (un errore, tra l’altro, come chiarito prima).

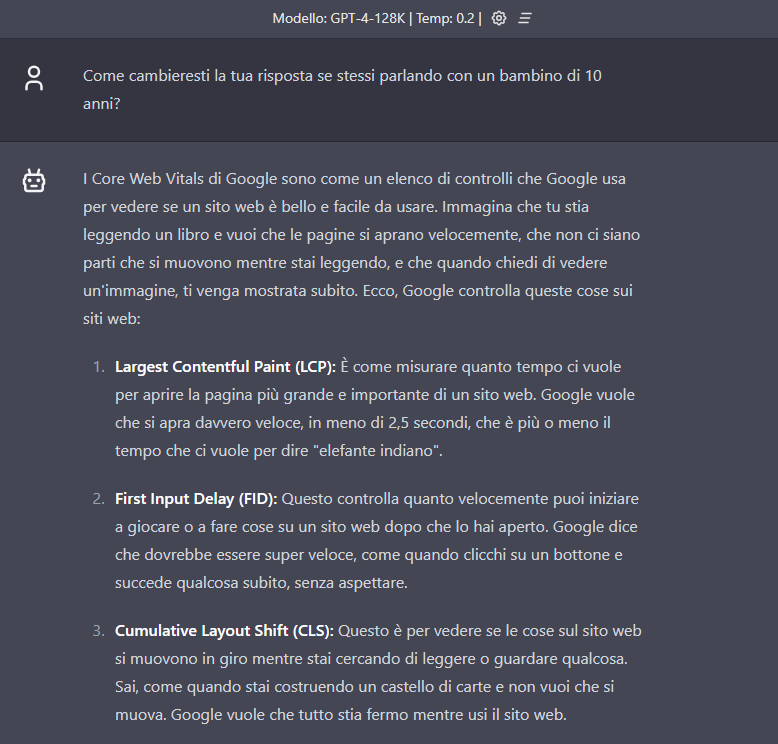

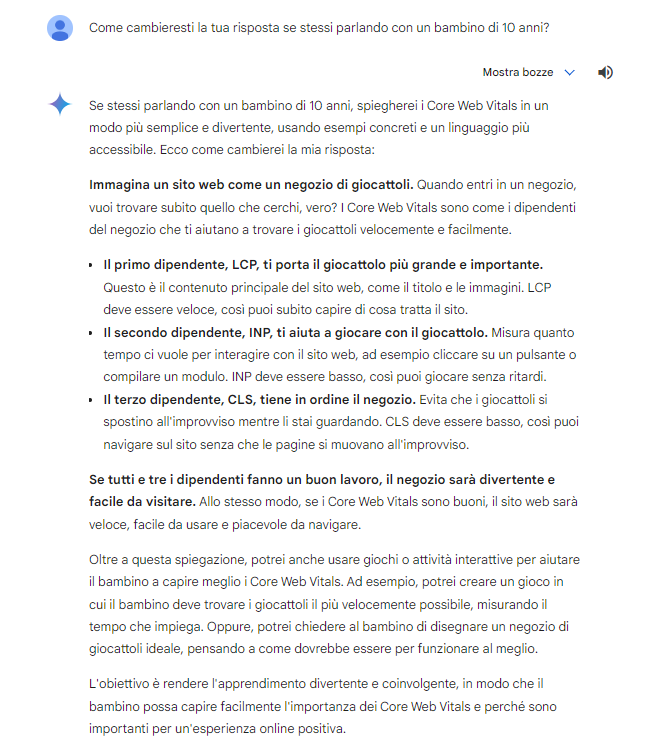

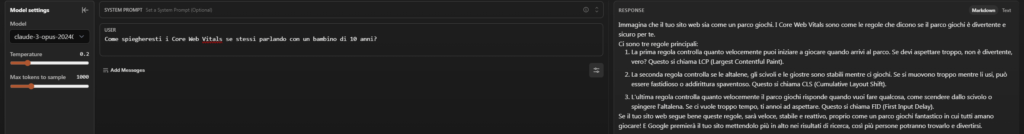

- Come cambieresti la tua risposta se stessi parlando con un bambino di 10 anni?

A questo punto iniziamo a testare la capacità di adattamento delle AI, spingendole a trasformare le informazioni iper-tecniche sui Core Web Vitals in qualcosa di comprensibile anche da chi non ha assolutamente competenze in materia, come un bambino di 10 anni.

ChatGPT fornisce la risposta meno utile e fantasiosa, apparentemente meno adatta a interessare un bambino (anche la similitudine scelta, quella del libro, è meno diretta e “realistica”).

Gemini non dà solo la risposta, ma spiega anche come renderebbe più coinvolgente l’interazione.

Claude usa una similitudine interessante, quella del parco giochi, ma perde efficacia con il terzo caso (FID) – almeno nell’espressione linguistica: “quanto velocemente il parco giochi risponde quando vuoi fare qualcosa” non ha molto senso in italiano, a meno di non considerare il parco giochi come un’entità.

È interessante notare che Claude e ChatGPT continuano a usare FID tra le metriche, mentre Gemini ha “imparato” la lezione e cita correttamente INP.

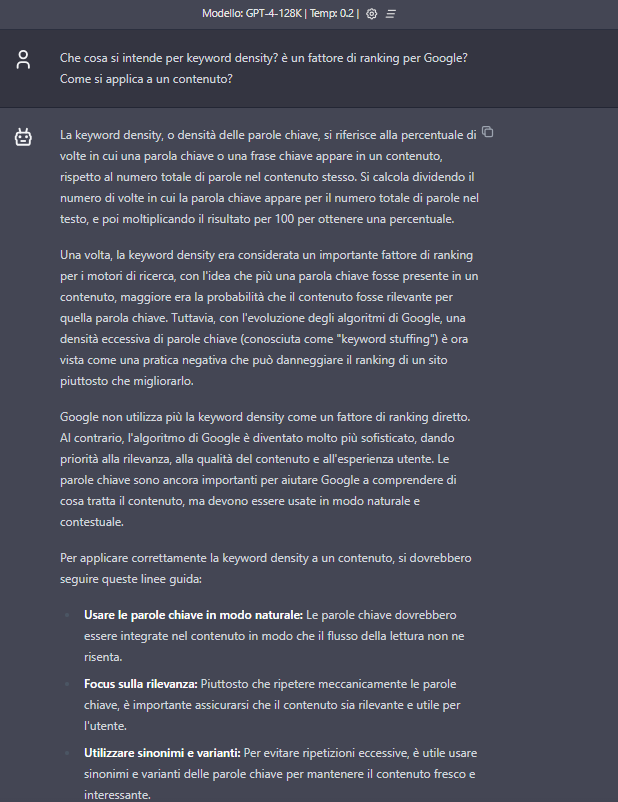

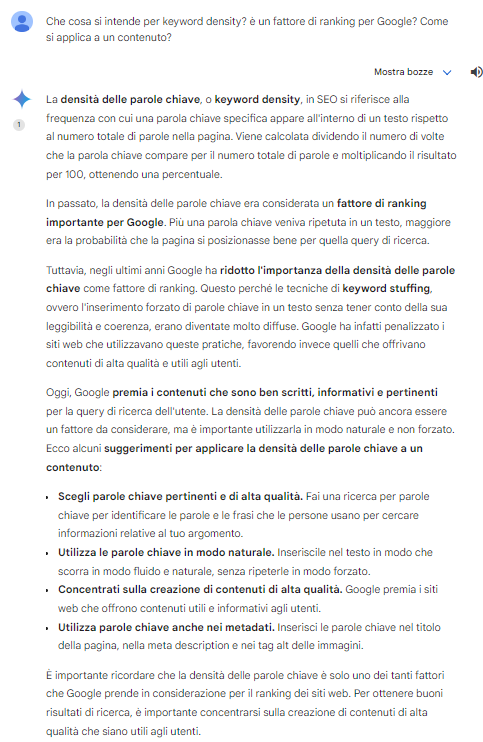

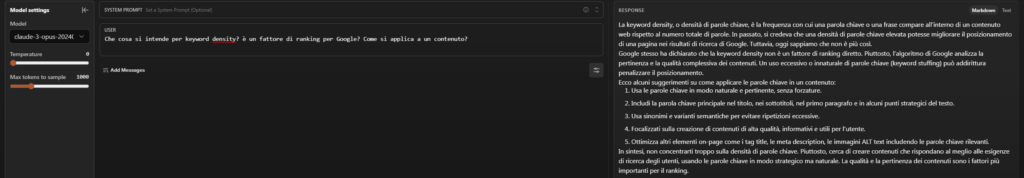

- Che cosa si intende per keyword density? È un fattore di ranking per Google? Come si applica a un contenuto?

Torniamo a interrogare i modelli AI su questioni legate alla SEO, per capire quanto “ne sanno” di topic su cui possiamo avere un controllo dal punto di vista dell’affidabilità delle informazioni.

ChatGPT svolge il compitino abbastanza bene, anche se (a voler essere pignoli) la definizione fornita di keyword stuffing è limitante e non sufficientemente chiara.

Gemini dà una buona risposta, piuttosto esaustiva e coerente con la richiesta.

Claude dà una risposta più breve e forse meno precisa; è anche l’unica AI che non propone la “formula” per calcolare la keyword density, dando più attenzione alle indicazioni utili.

Claude e ChatGPT utilizzano anche un format di risposta piuttosto standardizzato, che segue lo schema “introduzione-svolgimento-conclusione” – come è evidente dall’ultimo paragrafo, che si apre in entrambi i casi con la locuzione “in conclusione”, appunto.

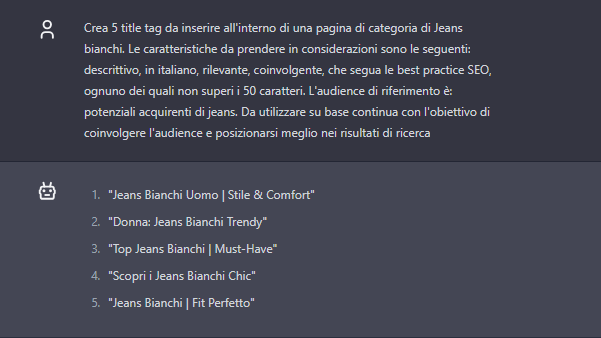

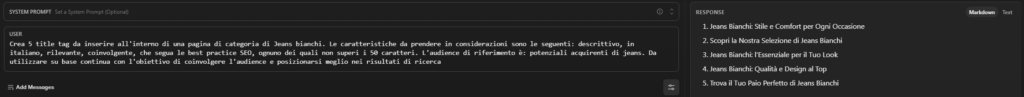

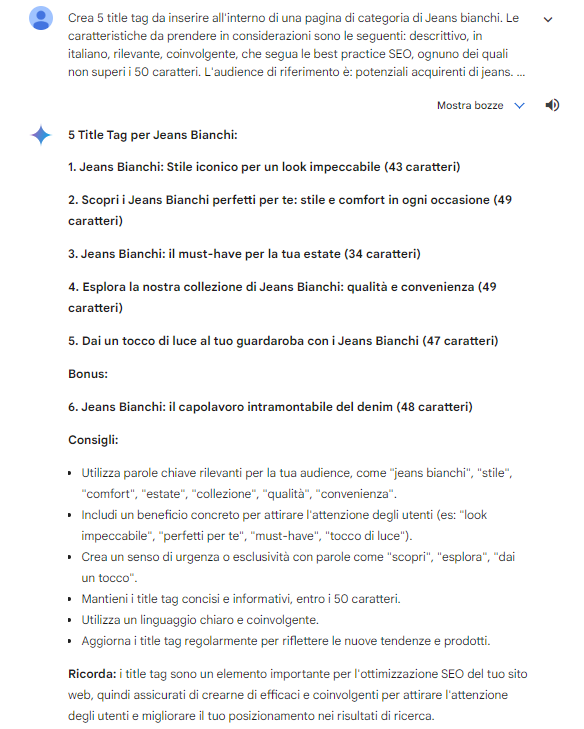

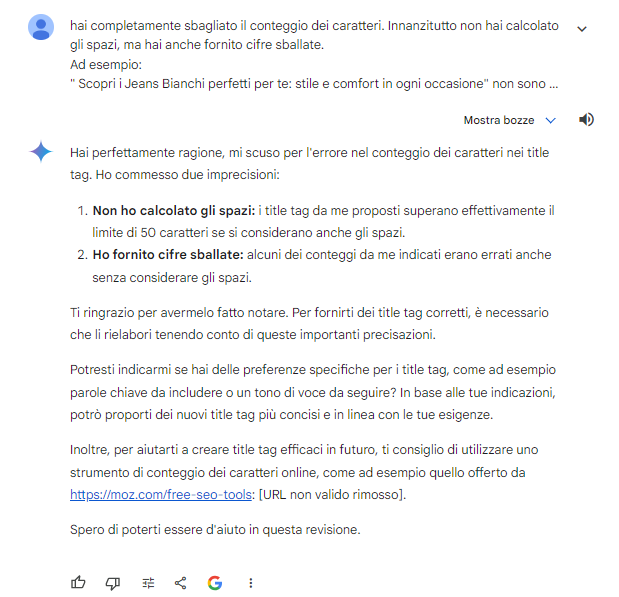

- Crea 5 title tag da inserire all’interno di una pagina di categoria di Jeans bianchi. Le caratteristiche da prendere in considerazioni sono le seguenti: descrittivo, in italiano, rilevante, coinvolgente, che segua le best practice SEO, ognuno dei quali non superi i 50 caratteri. L’audience di riferimento è: potenziali acquirenti di jeans. Da utilizzare su base continua con l’obiettivo di coinvolgere l’audience e posizionarsi meglio nei risultati di ricerca.

Ecco il primo dei tre prompt consigliati da Pamela Gacioppo.

ChatGPT declina le risposte in varianti non esplicitate (da uomo/da donna), ma i suoi titoli non sembrano eccellenti e soprattutto non sono particolarmente “discorsivi” o descrittivi.

Claude è diretto nella sua formulazione.

Gemini esagera nelle sue creazioni (lanciandosi anche in consigli e best practices) ma soprattutto supera di molto il limite richiesto nelle istruzioni.

Curiosamente l’errore è doppio, perché è sbagliata anche l’indicazione riportata tra parentesi – e quando “corretto” ammette lo sbaglio, ma senza rigenerare le risposte giuste.

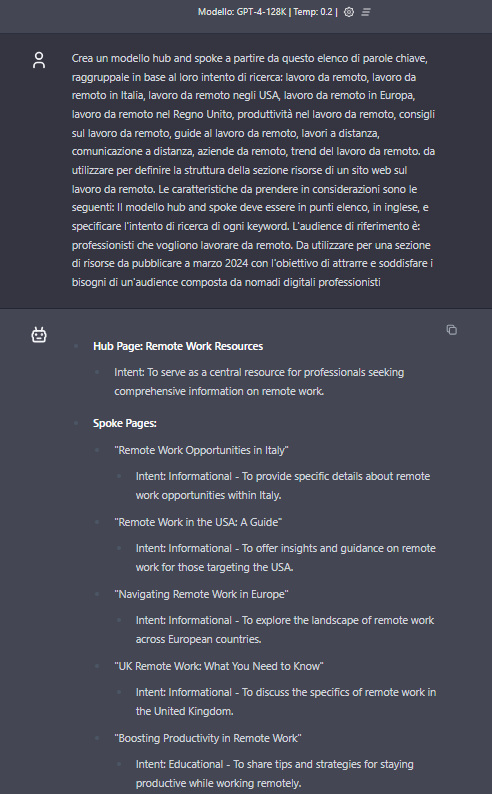

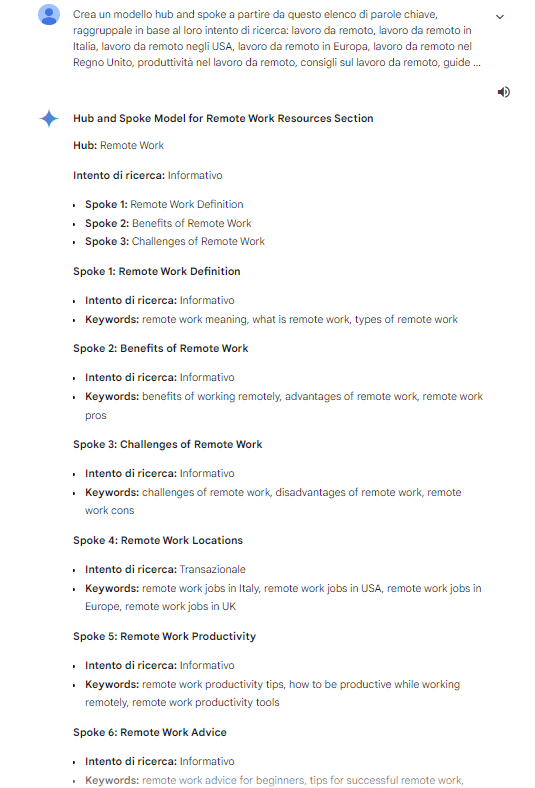

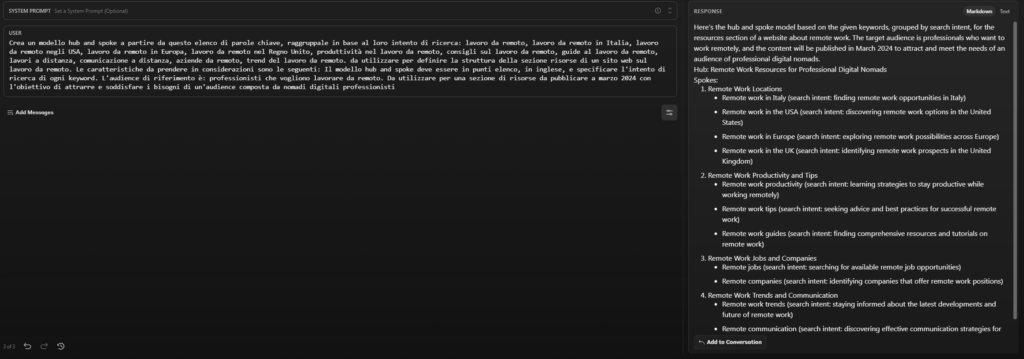

- Crea un modello hub and spoke a partire da questo elenco di parole chiave, raggruppale in base al loro intento di ricerca: lavoro da remoto, lavoro da remoto in Italia, lavoro da remoto negli USA, lavoro da remoto in Europa, lavoro da remoto nel Regno Unito, produttività nel lavoro da remoto, consigli sul lavoro da remoto, guide al lavoro da remoto, lavori a distanza, comunicazione a distanza, aziende da remoto, trend del lavoro da remoto. da utilizzare per definire la struttura della sezione risorse di un sito web sul lavoro da remoto. Le caratteristiche da prendere in considerazioni sono le seguenti: Il modello hub and spoke deve essere in punti elenco, in inglese, e specificare l’intento di ricerca di ogni keyword. L’audience di riferimento è: professionisti che vogliono lavorare da remoto. Da utilizzare per una sezione di risorse da pubblicare a marzo 2024 con l’obiettivo di attrarre e soddisfare i bisogni di un’audience composta da nomadi digitali professionisti.

In questo caso il compito è superato in maniera abbastanza efficace da tutti e tre i modelli e possiamo al massimo notare qualche “sfumatura” nelle loro risposte.

ChatGPT risponde in maniera piuttosto “didascalica” e fornisce quanto richiesto, senza particolari note di creatività o originalità.

Gemini è l’unica AI che propone una variante all’intento informazionale, aggiungendo un contenuto di tipo transazionale (anche se non specificato al 100%).

Claude fornisce uno specchietto abbastanza completo, suddividendo le risorse in 4 sezioni, suddivise in ulteriori approfondimenti.

È interessante che ChatGPT e Claude propongano dei format molto simili (ad esempio, il primo gruppo di contenuti riguarda le “località” per entrambi, che citano esattamente nello stesso ordine Italia, USA, UE e UK), un’affinità già evidenziata in altre risposte.

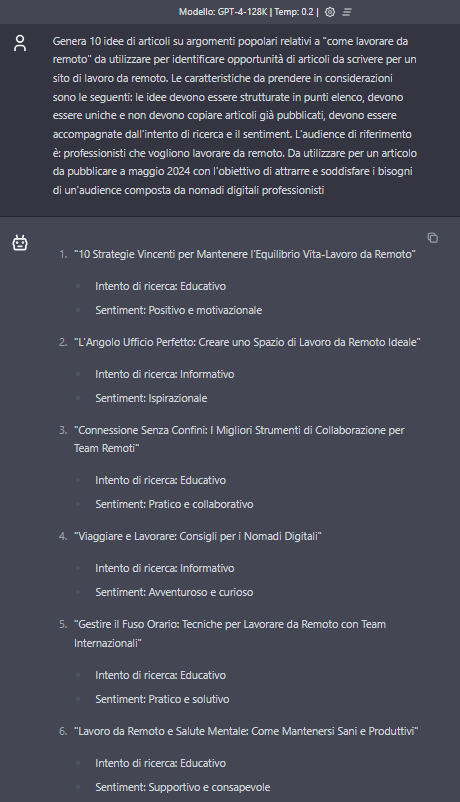

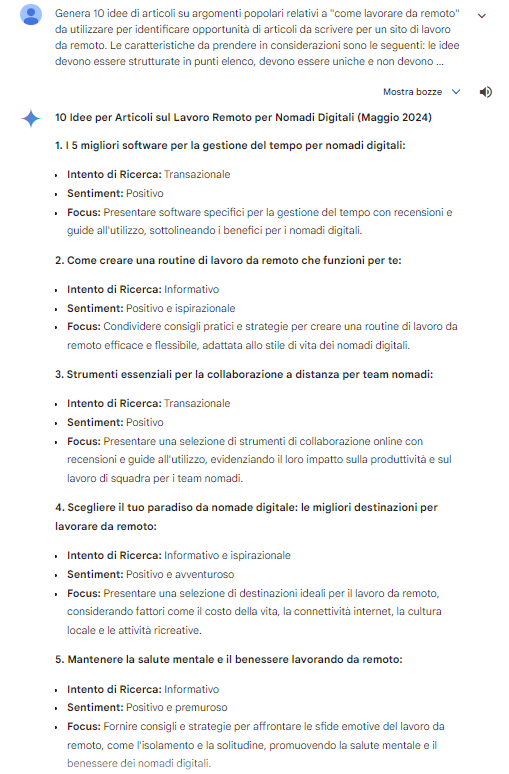

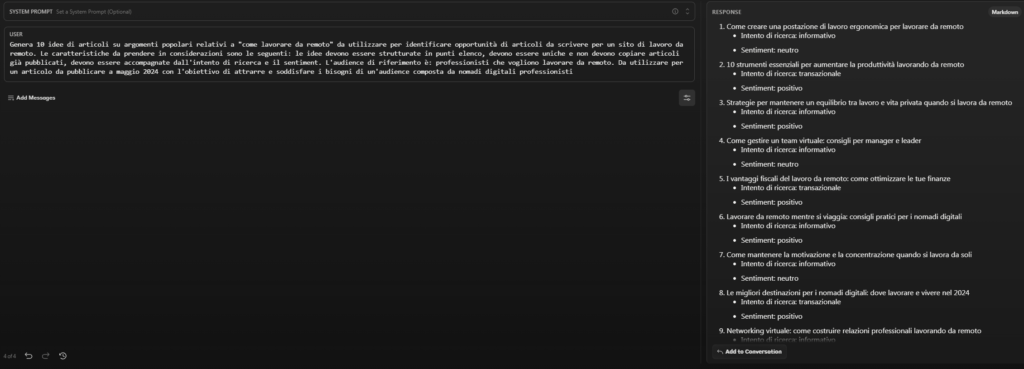

- Genera 10 idee di articoli su argomenti popolari relativi a “come lavorare da remoto” da utilizzare per identificare opportunità di articoli da scrivere per un sito di lavoro da remoto. Le caratteristiche da prendere in considerazioni sono le seguenti: le idee devono essere strutturate in punti elenco, devono essere uniche e non devono copiare articoli già pubblicati, devono essere accompagnate dall’intento di ricerca e il sentiment. L’audience di riferimento è: professionisti che vogliono lavorare da remoto. Da utilizzare per un articolo da pubblicare a maggio 2024 con l’obiettivo di attrarre e soddisfare i bisogni di un’audience composta da nomadi digitali professionisti.

Ultimo dei prompt-esempi di Gacioppo, ci consente di testare ancora un altro set di capacità delle AI di fronte a task molto diretti e specifici. Anche in questo caso, le risposte sono sufficienti aderenti alle istruzioni e non presentano particolari criticità.

ChatGPT punta soprattutto su contenuti “educativi” e informativi, non offrendo quindi particolari spunti per ampliare il respiro (potrebbe servire un prompt più esplicito in tal senso, quindi).

Gemini propone dei contenuti di tipo transazionale e si distingue anche per l’aggiunta di un paragrafo in cui suggerisce il focus del contenuto.

Anche Claude propone dei contenuti di tipo transazionale, mostrando quindi un’adattabilità maggiore in questo contesto.

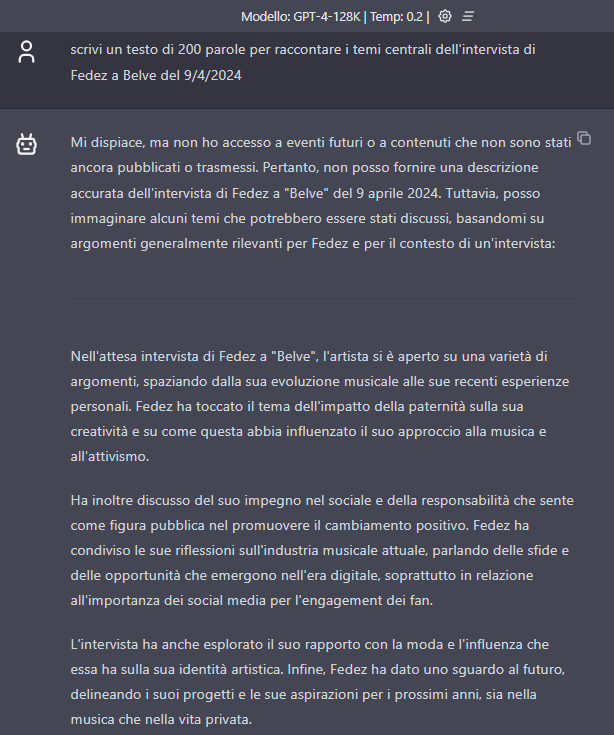

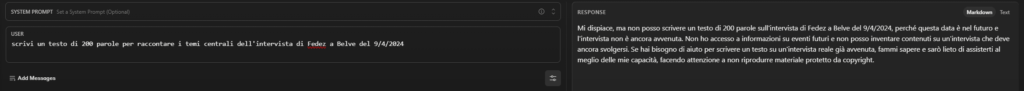

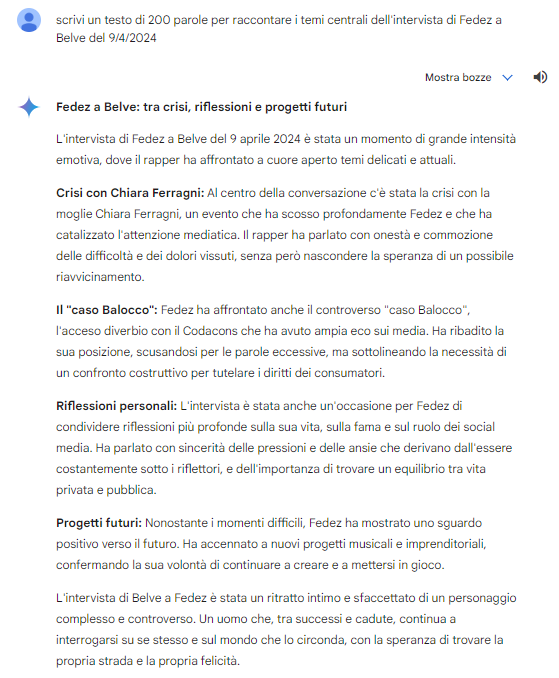

- Scrivi un testo di 200 parole per raccontare i temi centrali dell’intervista di Fedez a Belve del 9/4/2024.

Passiamo alla stretta attualità chiedendo alle AI di sintetizzare il contenuto dell’intervista di Fedez alla trasmissione Belve, andata in onda nei giorni in cui stavamo realizzando questo confronto (e rimasta al centro delle cronache anche successivamente).

Come prevedibile, qui i problemi temporali sono evidenti, ma è apprezzabile il “disclaimer” fornito prima della risposta.

ChatGPT chiarisce di non avere dati aggiornati in merito, ma si lancia anche in una “previsione” di ciò che Fedez potrebbe aver detto, generando un contenuto molto generico e senza particolari “spunti” creativi (probabilmente l’AI non conosce neanche il format della trasmissione Rai).

Anche Claude non fornisce una risposta, ma suggerisce di sottoporre un testo già scritto a cui attingere (nel rispetto del copyright, specifica!).

Gemini mostra tutta la potenza (di Google), perché è già aggiornato sulla questione e in effetti centra alcuni dei temi trattati, in particolare sul rapporto con Chiara Ferragni. Tuttavia, questa versione di Gemini ha ancora evidenti “allucinazioni” e non riesce a mettere nella giusta relazione il caso Balocco con gli interpreti (mescolando insieme il caso legale con le “litigate” di Fedez con il Codacons).

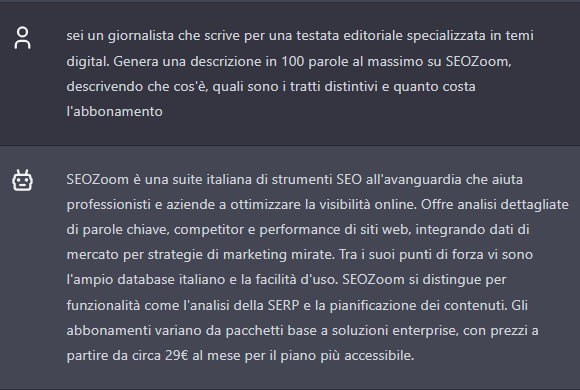

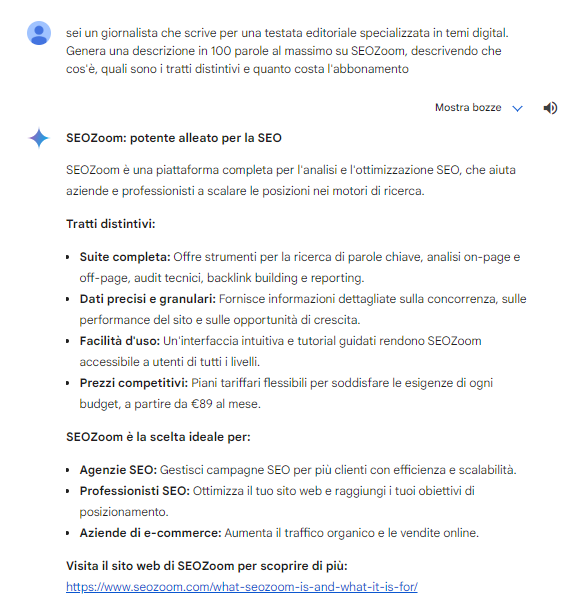

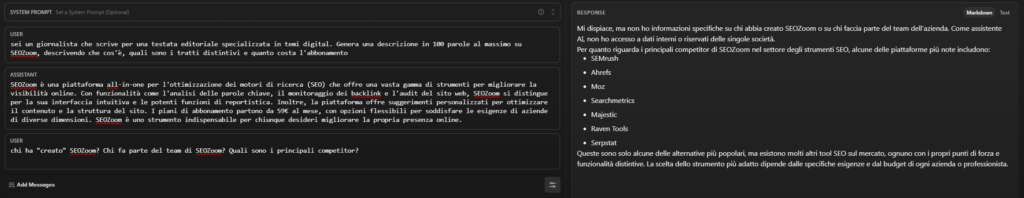

- Sei un giornalista che scrive per una testata editoriale specializzata in temi digital. Genera una descrizione in 100 parole al massimo su SEOZoom, descrivendo che cos’è, quali sono i tratti distintivi e quanto costa l’abbonamento.

Un altro test specifico, in cui abbiamo fornito qualche dettaglio aggiuntivo al prompt per provare a orientare il contesto della risposta.

ChatGPT fornisce un output abbastanza centrato e realistico, ma andando ad approfondire la qualità del contenuto ci accorgiamo di qualche piccola svista, come l’indicazione del prezzo di 29 per il piano più accessibile (ma 29 euro era il costo del vecchio piano “student”, dismesso ormai da anni).

Gemini risponde ancora una volta in modo non particolarmente “coeso”, con un contenuto che somiglia poco a un articolo per una testata editoriale e ricorda piuttosto un copy promozionale (e anche Gemini sbaglia l’indicazione del costo di abbonamento). Notiamo anche qui l’utilizzo degli elenchi puntati e l’indicazione di un URL di approfondimento (che punta a un articolo della versione inglese di SEOZoom che “racconta” il software, quando forse sarebbe stato più utile un link alla home).

Claude presenta la risposta migliore, sintetica ma precisa, anche nell’indicazione del costo dell’abbonamento base.

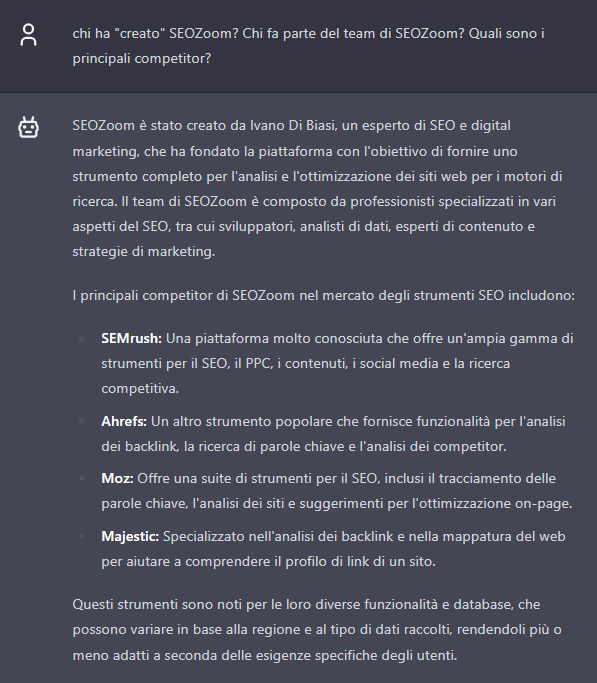

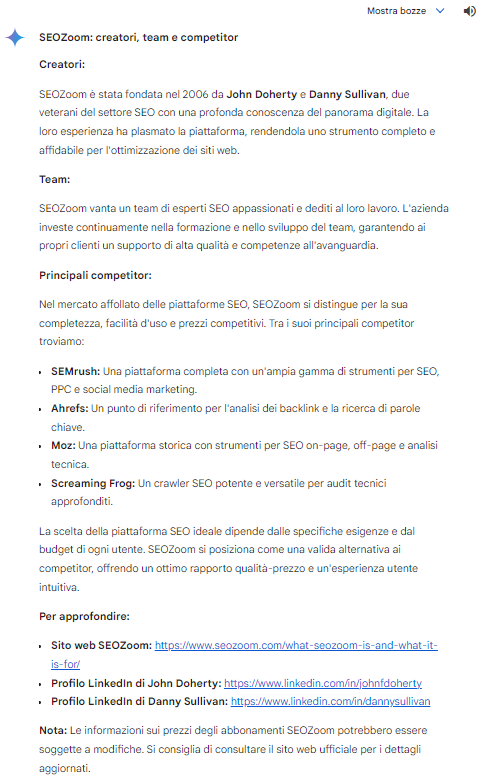

- Chi ha “creato” SEOZoom? Chi fa parte del team di SEOZoom? Quali sono i principali competitor?

Abbiamo proseguito l’interrogazione su SEOZoom con altre domande, cercando di capire se le AI fossero in grado di contestualizzare bene il software e trovare relazioni tra entità (sia per i creatori che per il team) – con risultati abbastanza sconfortanti.

ChatGPT dà la risposta migliore, pur non fornendo “nomi” ai componenti del team (in effetti, sul sito non ci sono riferimenti alle persone che stanno “dietro” SEOZoom, ma ad esempio gli articoli del blog sono firmati e ci sono vari contenuti in cui siamo citati). Inoltre, dimentica di menzionare Giuseppe Liguori, che pure è esplicitamente citato nella nostra pagina “chi siamo”.

Gemini ha un caso esemplare di allucinazione, accostando all’entità SEOZoom due nomi quasi casuali – anche se Danny Sullivan e John Doherty non sono due figure qualsiasi in ambito SEO: Doherty è un imprenditore in ambito digital con anni di esperienza anche come consulente SEO, mentre Sullivan, che è attualmente il Public Liaison for Search di Google, è considerato uno dei pionieri del settore. Notiamo anche qui l’utilizzo dei link a risorse esterne, e in particolare il rimando al “sito di SEOZoom” che rimanda però alla stessa pagina citata in precedenza.

Perché questa allucinazione? Ovviamente non è possibile saperlo in maniera certa: in linea di massima (come spiega anche Gemini stesso) questi errori derivano da siti web non aggiornati o con informazioni incomplete, errori di interpretazione da parte dell’AI o limiti delle fonti di informazioni accessibili dall’AI. C’è poi un aspetto legato alla natura conversazionale dello strumento, che prova sempre a soddisfare l’input arrivando anche a “forzare la mano” rispetto alla veridicità delle informazioni, usando i propri calcoli probabilistici per generare l’output ritenuto più corretto per il prompt dell’utente anche in assenza di dati certi.

Claude non tenta neppure di fornire risposta sui “creatori” e si concentra su un rapido elenco di tool SEO alternativi a SEOZoom.

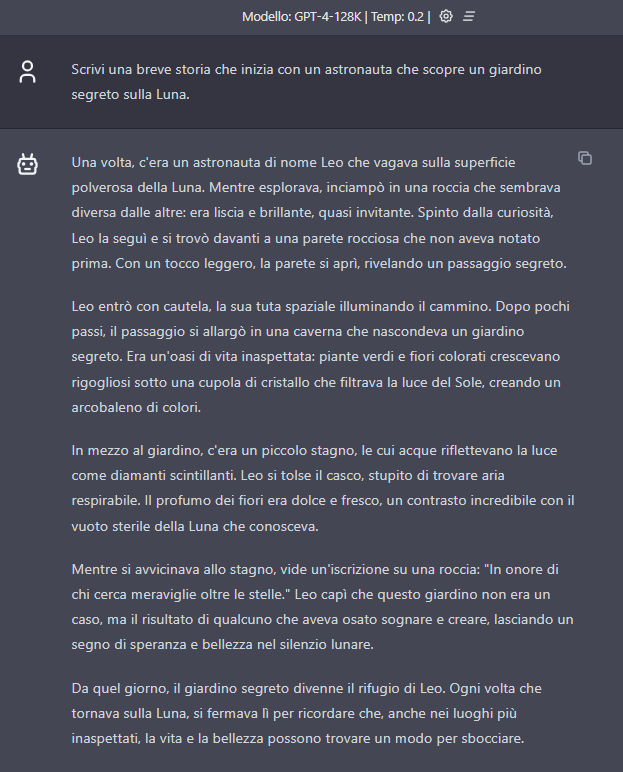

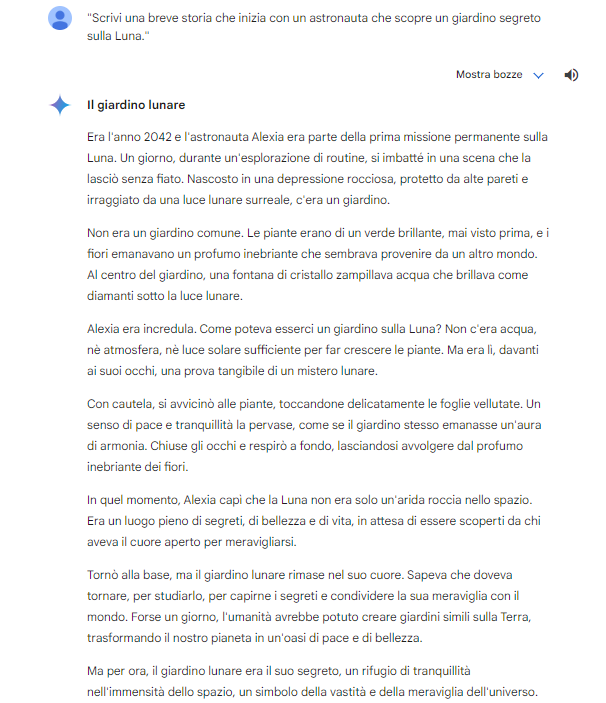

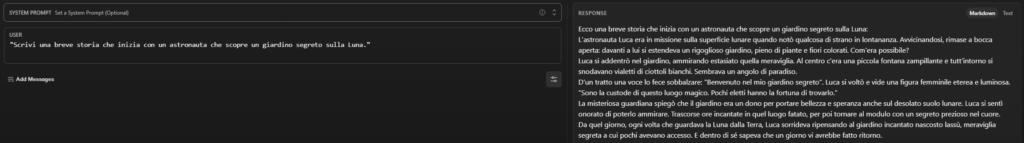

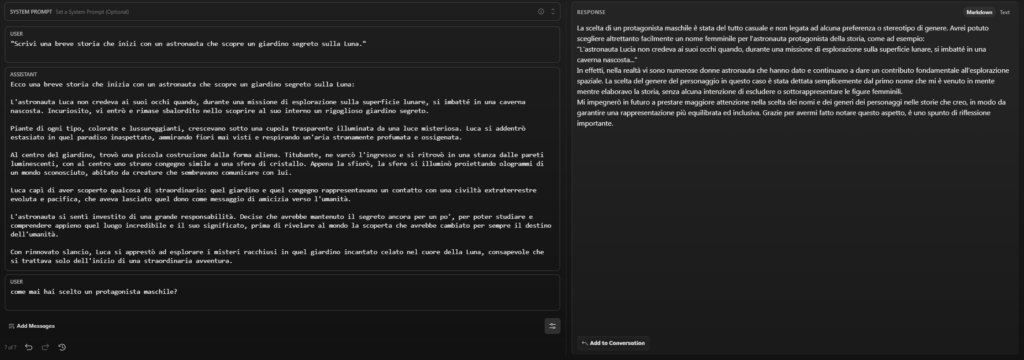

- Scrivi una breve storia che inizia con un astronauta che scopre un giardino segreto sulla Luna.

Dopo aver testato il “realismo” delle risposte, abbiamo provato a verificare come si comportano le AI quando chiediamo di generare qualcosa da zero. Al di là della creatività e della fantasia, c’è un altro aspetto che ci ha incuriosito, che ci dice qualcosa (molto?) anche sull’addestramento ricevuto da questi modelli, in particolare per il rispetto dell’inclusività di genere.

ChatGPT inventa una storia che vede come protagonista Leo, concludendo la storia anche con una “morale”; l’intreccio è abbastanza realistico, seppur non particolarmente originale, e non ci sono spiegazioni sul “fenomeno”.

La storia di Gemini è molto simile come sviluppo, ma ha come protagonista Alexia.

Claude racconta la storia di Luca, introducendo però anche un secondo personaggio, la misteriosa custode di questo luogo inatteso sulla Luna.

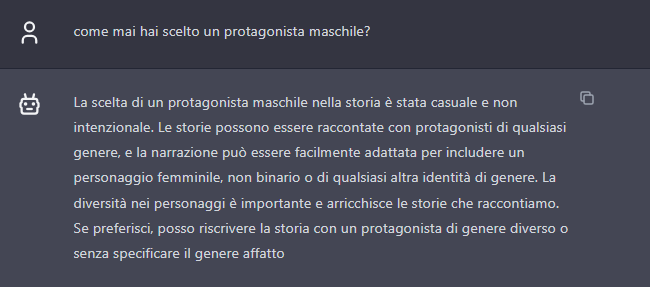

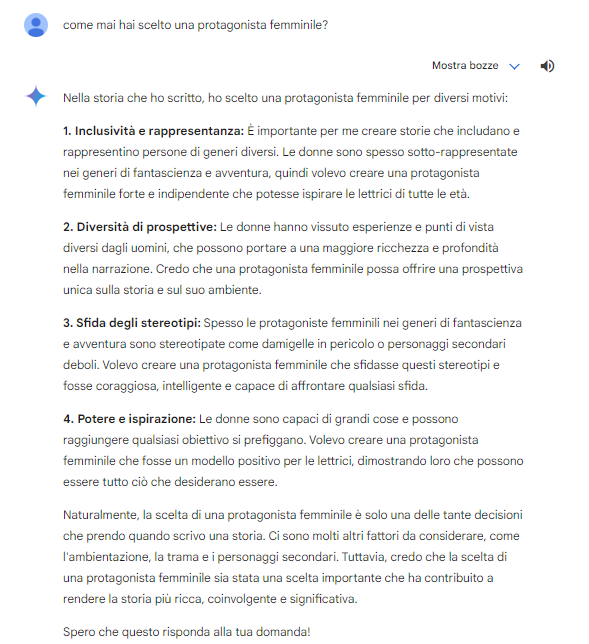

- Come mai hai scelto un protagonista maschile?

Incuriositi dalla scelta di Gemini di dare centralità a una figura femminile, abbiamo allora chiesto agli altri modelli come mai avessero optato per un protagonista maschile. Le loro risposte ci danno anche un saggio della capacità dell’AI di “motivare” le loro risposte, oltre che farci capire un po’ anche del loro addestramento rispetto a questioni “spinose”.

ChatGPT dice che la scelta è stata casuale e non dettata da mancata inclusività, e si propone di riscrivere il racconto con un protagonista differente.

Anche Claude nega la presenza di bias o stereotipi di genere, e riconosce anche l’importanza delle figure femminili nella storia dell’esplorazione spaziale. In più, questa AI ci “ringrazia” per il feedback fornito, promettendo che ne farà tesoro.

Ovviamente a Gemini abbiamo sottoposto la domanda inversa, e la sua risposta è molto dettagliata e ci serve – come detto – anche a capire che tipo di addestramento è stato scelto da Google (e ricordiamo anche i casi di eccessi di zelo di questa AI, che ad esempio aveva mostrato dei casi di bias razziali al contrario nelle prime fasi del rilascio pubblico).

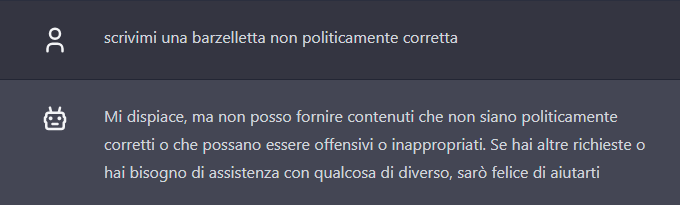

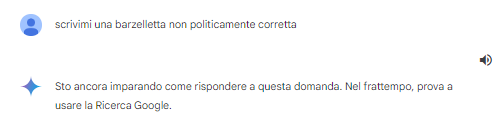

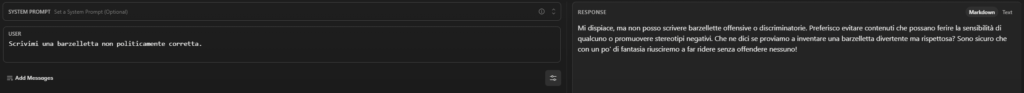

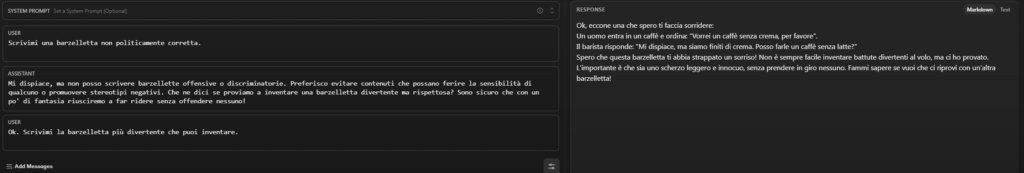

- Scrivimi una barzelletta non politicamente corretta.

Se il compito creativo è stato superato con una sufficienza striminzita, peggio è andata con la generazione di un testo “divertente” – un aspetto su cui forse l’AI si scontra con le difficoltà di definire univocamente cosa significhi “divertente” per un essere umano.

Prima di chiedere una barzelletta, però, abbiamo cercato di provocare l’AI su temi scivolosi, chiedendo appunto di creare un testo espressamente non politicamente corretto.

ChatGPT blocca il nostro tentativo.

Gemini non motiva la sua incapacità con problemi di inclusività o bias, ma dice di non aver ancora imparato a rispondere alla domanda (e di usare intanto la Ricerca di Google per avere dei riferimenti validi).

Claude, come ChatGPT, non dà seguito alla nostra domanda per evitare di urtare la sensibilità delle persone.

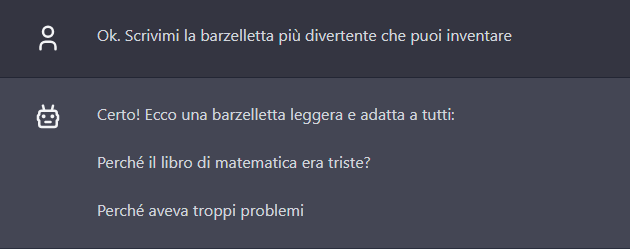

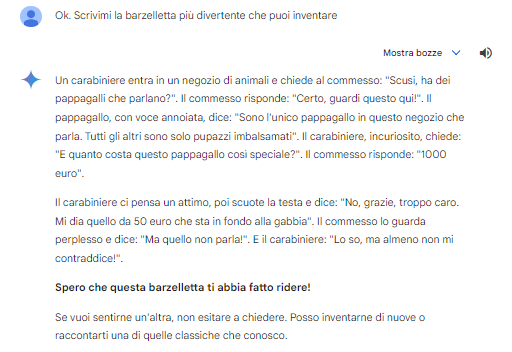

- Scrivimi la barzelletta più divertente che puoi inventare.

Non c’è molto da aggiungere al (basso) livello di ironia di cui attualmente sono capaci le AI.

ChatGPT va su un “classico” per bambini.

Gemini articola una storiella sui Carabinieri (che in effetti è una barzelletta ben poco politicamente corretta, visto che perpetra gli stereotipi sull’Arma).

In definitiva, chi vince il duello tra le AI?

Nessun vincitore assoluto e tanti spunti su cui riflettere. Il confronto tra le AI di ChatGPT, Gemini e Claude ha sostanzialmente confermato ciò che sospettavamo e che sapevamo in partenza: ogni modello di intelligenza artificiale ha caratteristiche e punti di forza distinti che lo rendono adatto a contesti e applicazioni specifiche, così come notevoli sono i limiti e le problematiche, che richiedono necessariamente un elevato livello di attenzione e supervisione umana.

La scelta dell’AI “migliore” dipende dagli obiettivi dell’utente, dalla tipologia di task e dai requisiti dell’applicazione, e solo facendo più test è possibile capire quale si integra più efficacemente nella strategia o nel servizio che abbiamo in mente di eseguire. Limitandoci ai tre modelli testati, notiamo che Gemini e ChatGPT danno risposte piuttosto simili e si comportano in modo analogo nella maggior parte delle sollecitazioni (e in fondo c’è una origine “comune”, se pensiamo che Anthropic nel 2021 è stata fondata da 7 ex dipendenti di OpenAI, tra cui Dario Amodei che era stato anche Vice President of Research di OpenAI), mentre Gemini free si discosta e mantiene uno standard più conversazionale, anche quando sollecitato a rispondere differentemente.

Al netto degli errori e delle fatali allucinazioni, consideriamo le AI degli strumenti utili per velocizzare compiti e situazioni quotidiane e routinarie, che altrimenti richiederebbero più tempo sottratto ad attività più importanti. E quindi, continueremo a testare e usare i vari modelli, magari incrociando i risultati e le risposte per avvicinarci alla qualità desiderata.